Редакция ноябрь, 2024

Аннотация

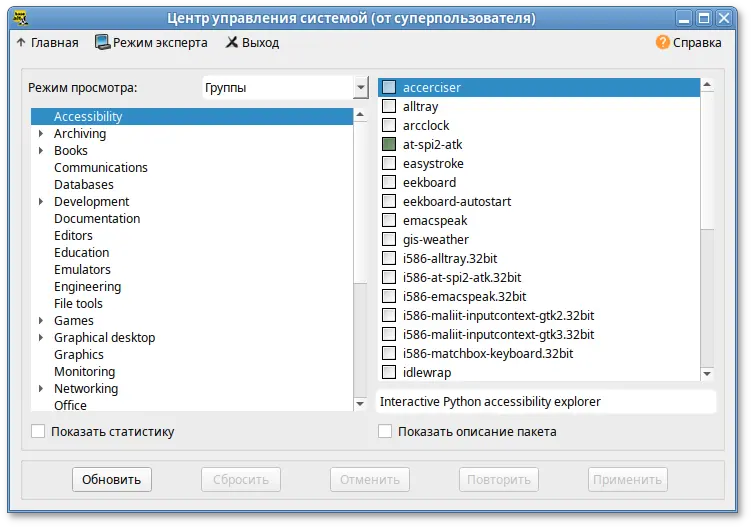

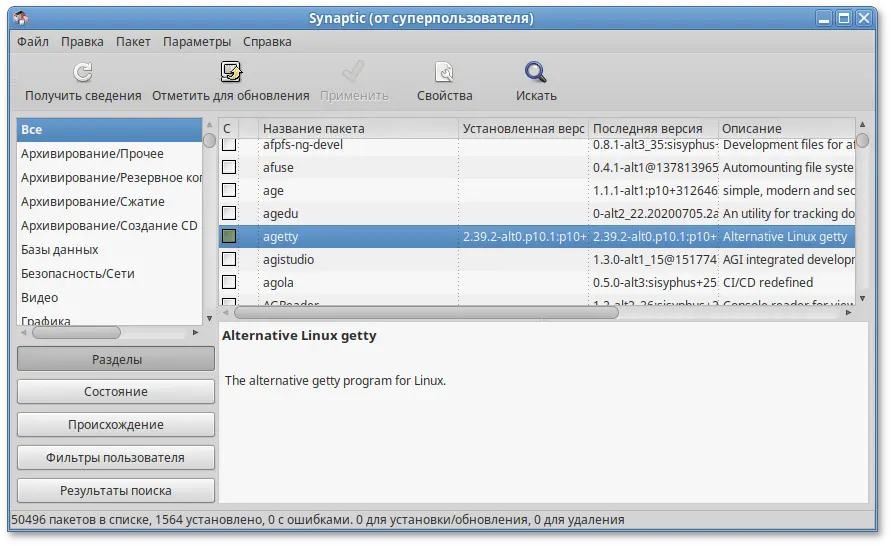

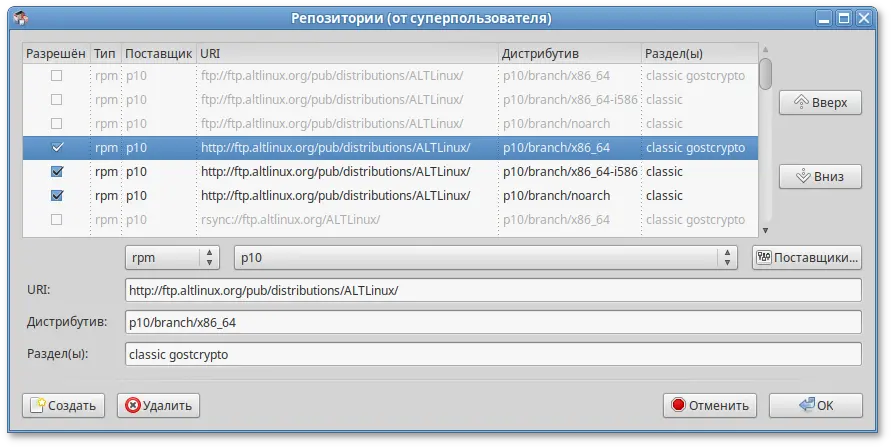

apt-get и её графическая оболочка synaptic позволяют пользователям легко обновлять свои системы и быть в курсе актуальных новостей мира свободных программ.

Содержание

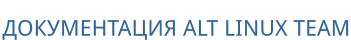

SCDWriter.exe;

Предупреждение

Предупреждение

Предупреждение

Предупреждение

#где <файл-образа.iso> — образ диска ISO, аddoflag=direct if=<файл-образа.iso> of=/dev/sdX bs=1M status=progress;sync

/dev/sdX — устройство, соответствующее flash-диску.

#где <файл-образа.iso> — образ диска ISO, аpv<файл-образа.iso> | dd oflag=direct of=/dev/sdX bs=1M;sync

/dev/sdX — устройство, соответствующее flash-диску.

lsblk или (если такой команды нет) blkid.

$ lsblk | grep disk

sda 8:0 0 931,5G 0 disk

sdb 8:16 0 931,5G 0 disk

sdc 8:32 1 7,4G 0 disk

flash-диск имеет имя устройства sdc.

# dd oflag=direct if=/home/iso/alt-server-10.4-x86_64.iso of=/dev/sdc bs=1M status=progress; sync

# pv /home/iso/alt-server-10.4-x86_64.iso | dd oflag=direct of=/dev/sdc bs=1M;sync

dd: warning: partial read (524288 bytes); suggest iflag=fullblock

3GiB 0:10:28 [4,61MiB/s] [===================================> ] 72% ETA 0:04:07

Предупреждение

sudo dd if=alt-server-10.4-x86_64.isoof=/dev/rdiskX bs=10Msync

alt-server-10.4-x86_64.iso — образ диска ISO, а /dev/rdiskX — flash-диск.

diskutil list

Предупреждение

$ du -b alt-server-10.4-x86_64.iso | cut -f1

5278818304

$ md5sum alt-server-10.4-x86_64.iso

e103dc0cfee41a73956dbcfe9a3547c8 alt-server-10.4-x86_64.iso

# head -c 5278818304 /dev/sdd | md5sum

e103dc0cfee41a73956dbcfe9a3547c8

где размер после -c — вывод в п.1, а /dev/sdd — устройство DVD или USB Flash, на которое производилась запись.

Предупреждение

Примечание

[root@localhost /]#

Примечание

Примечание

Примечание

Примечание

позволяет показать/скрыть панель со списком шагов установки:

позволяет показать/скрыть панель со списком шагов установки:

Примечание

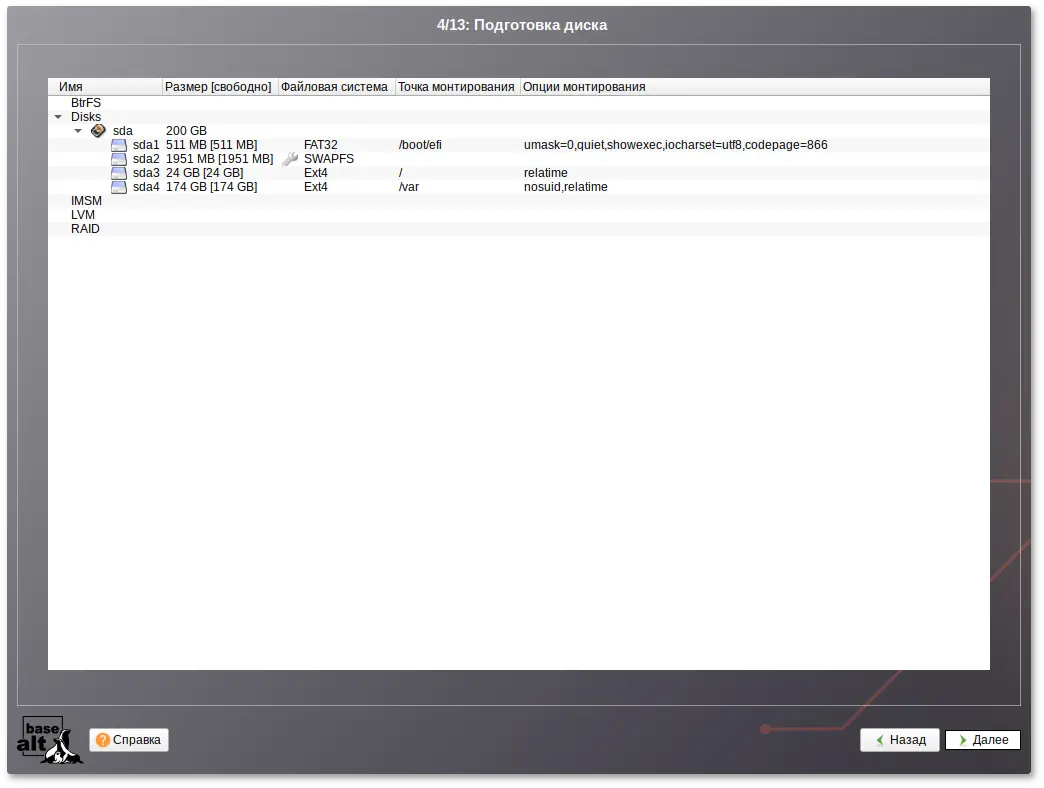

/var.

Примечание

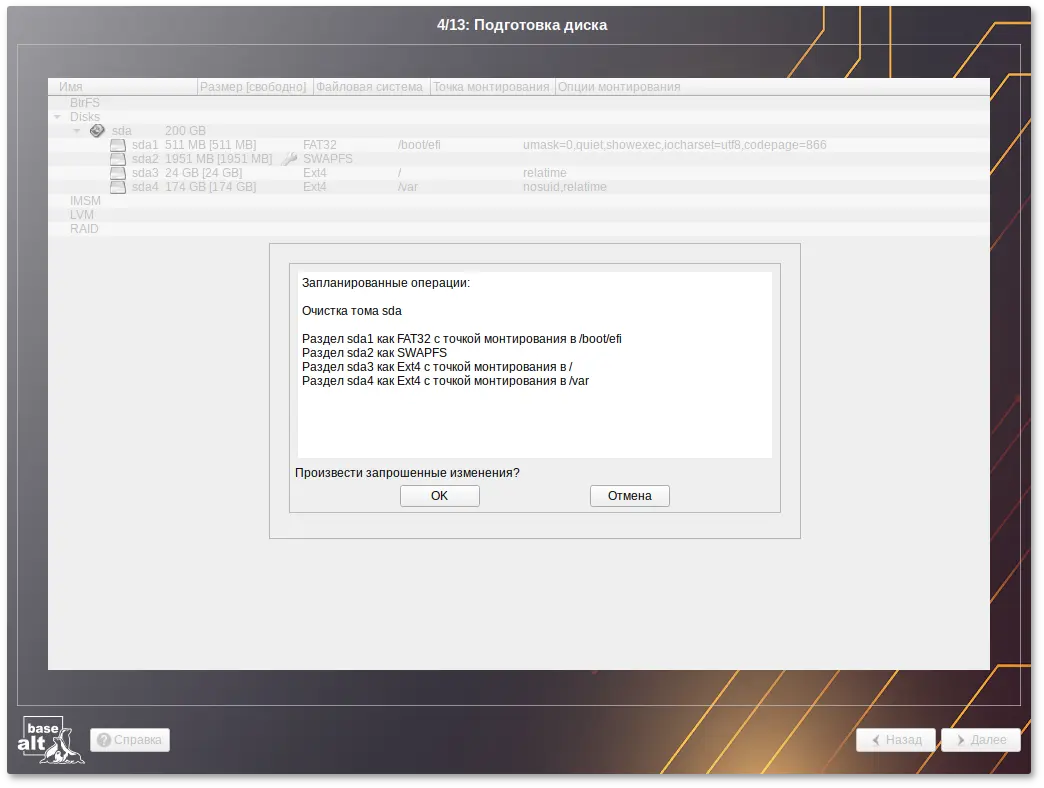

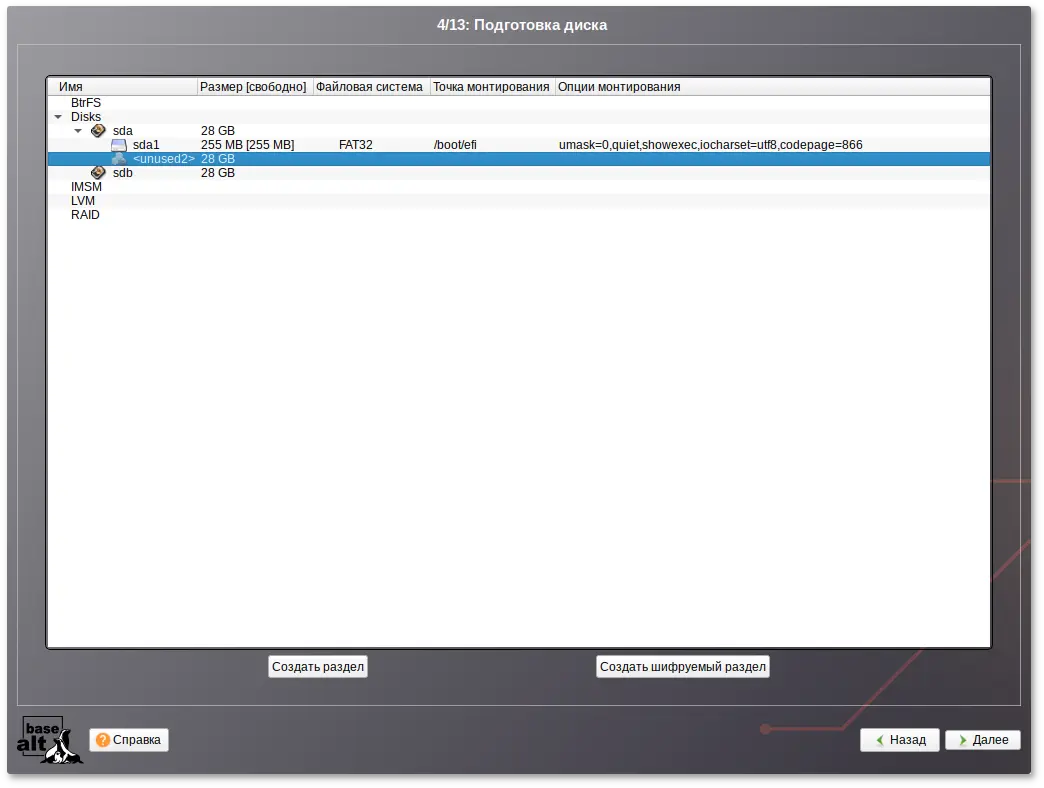

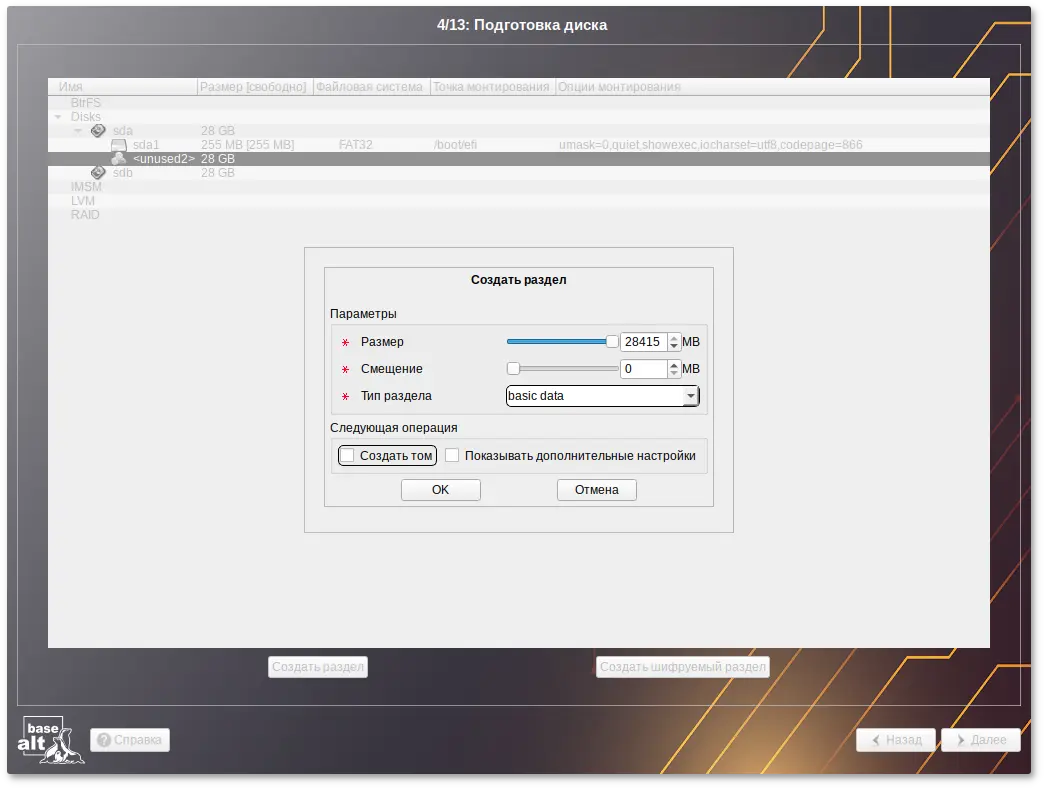

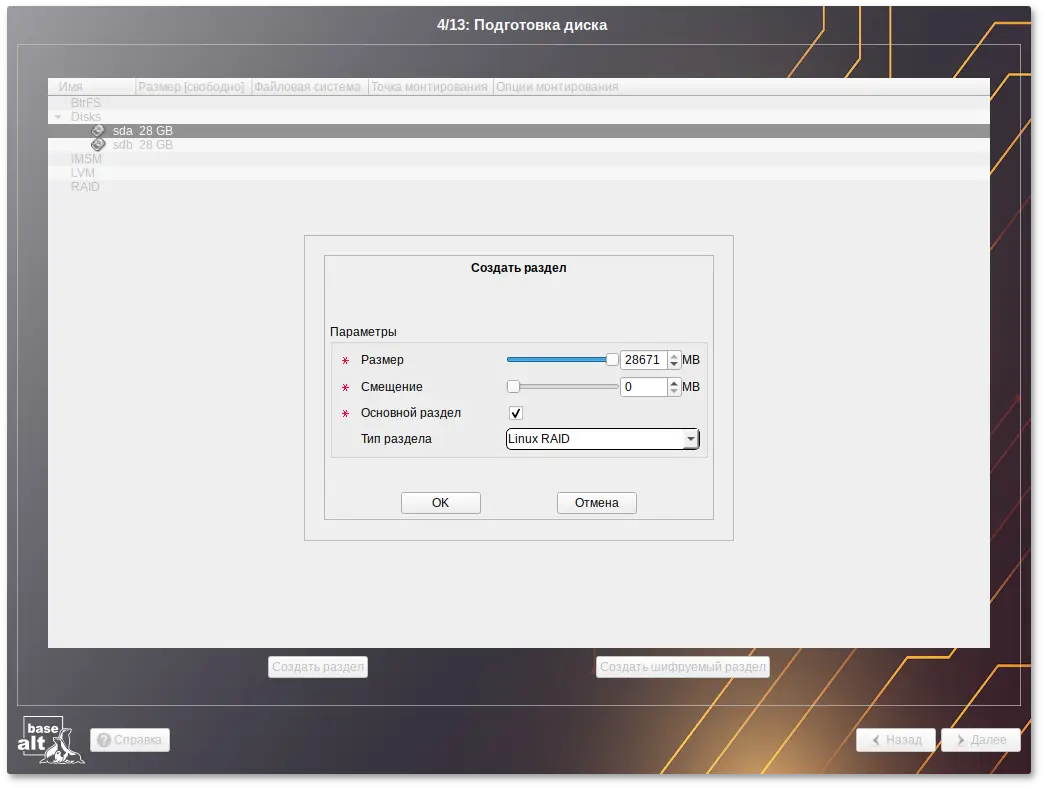

Предупреждение

/home) или с другими операционными системами. С другой стороны, отформатировать можно любой раздел, который вы хотите «очистить» (удалить все данные).

Предупреждение

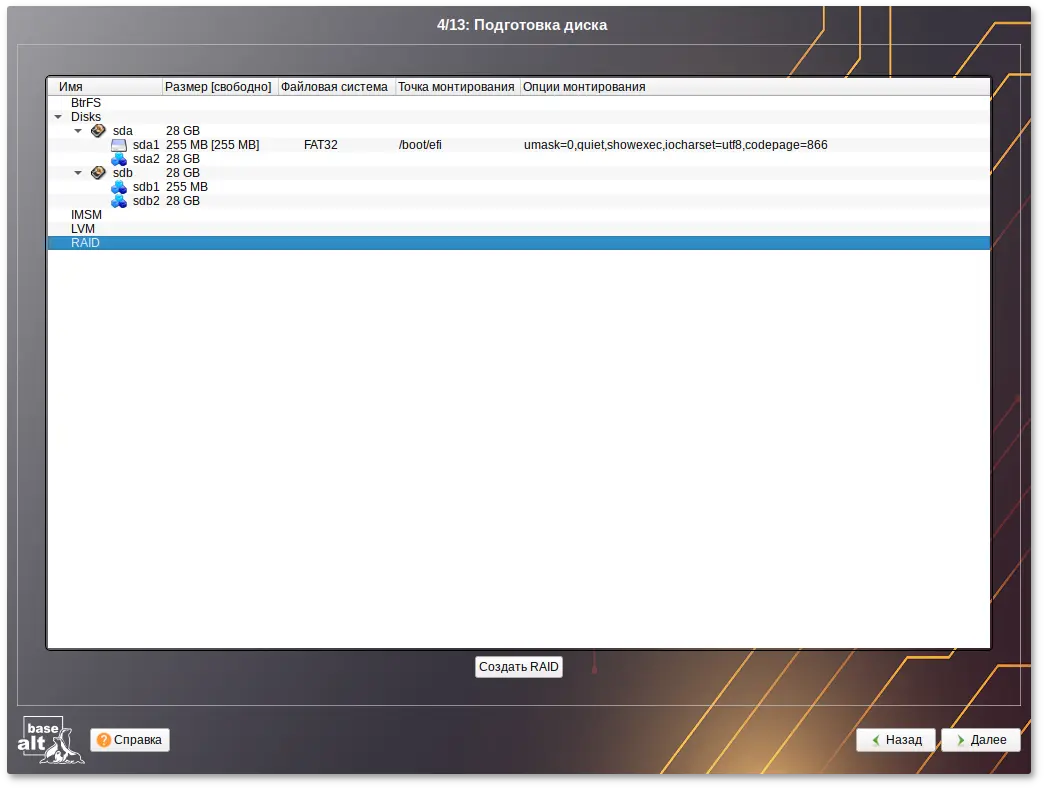

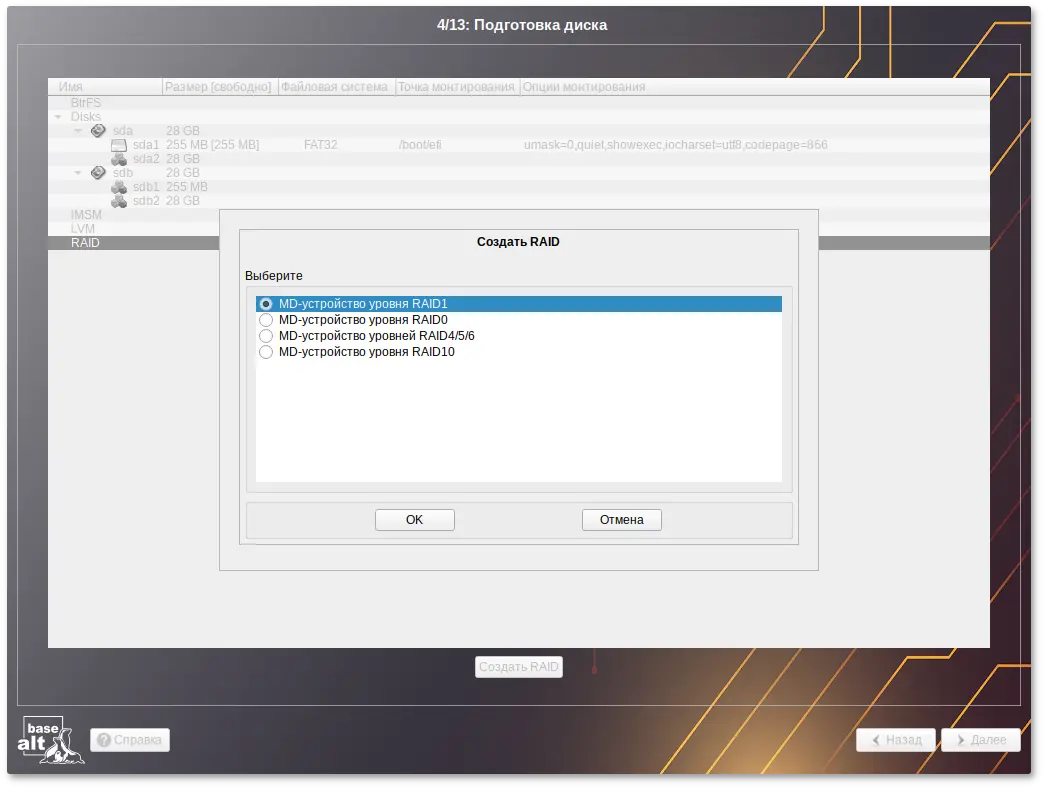

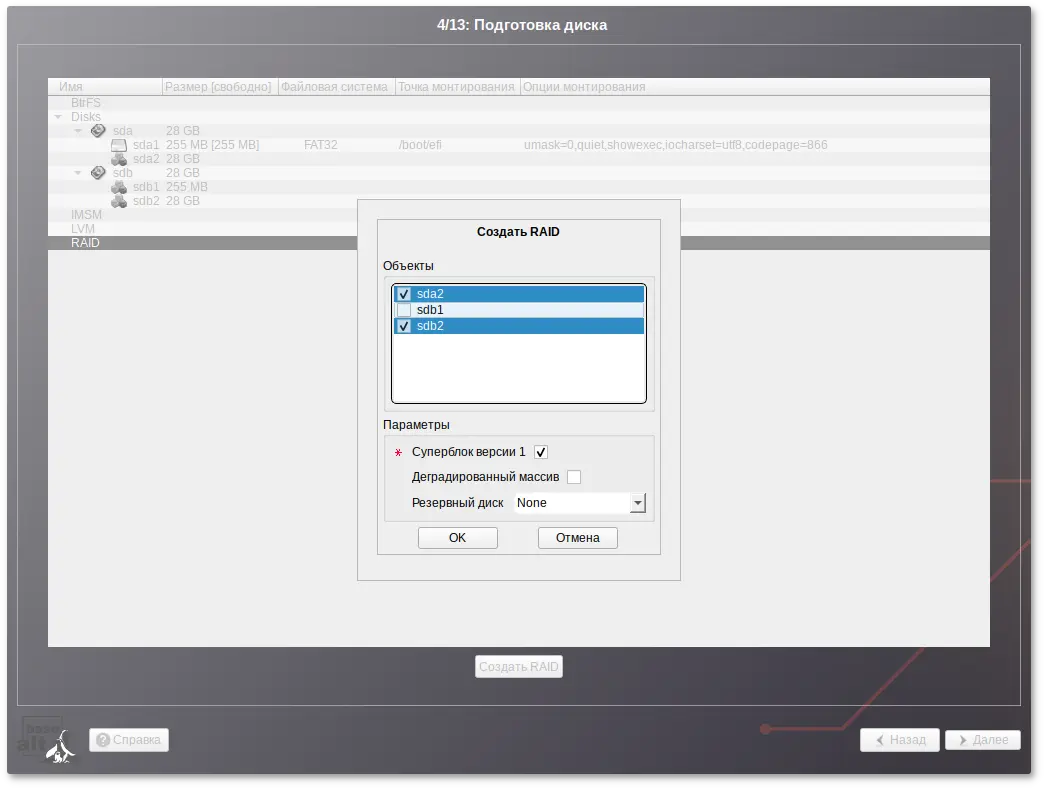

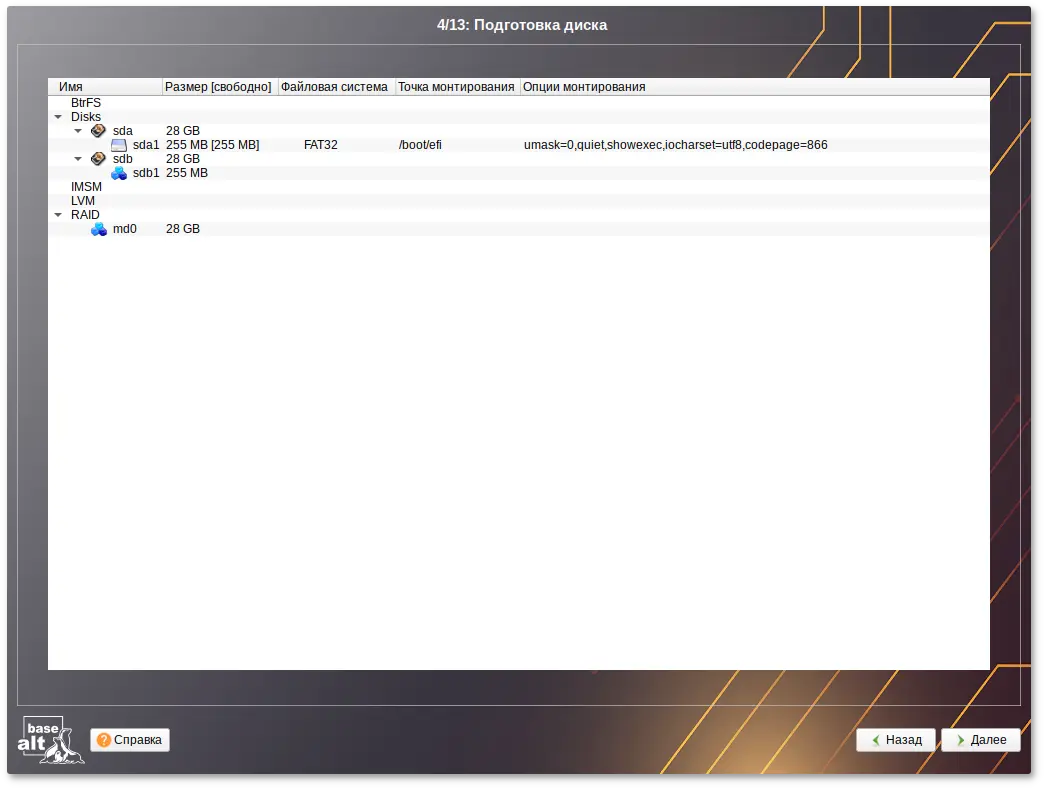

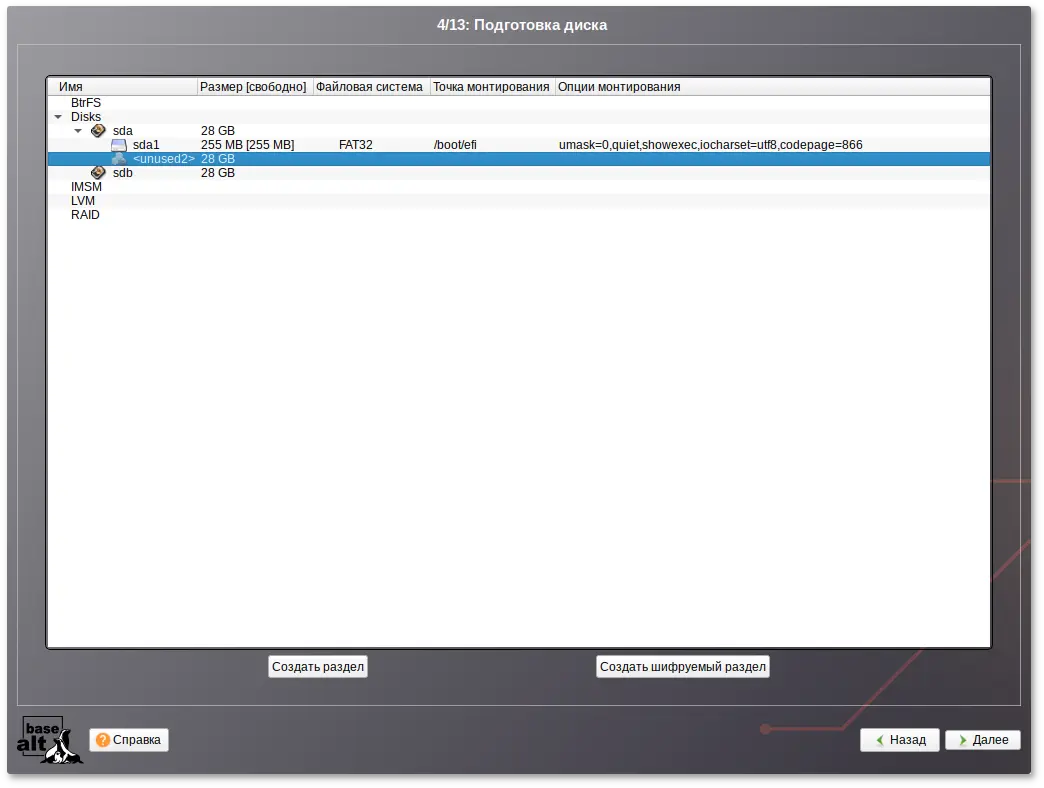

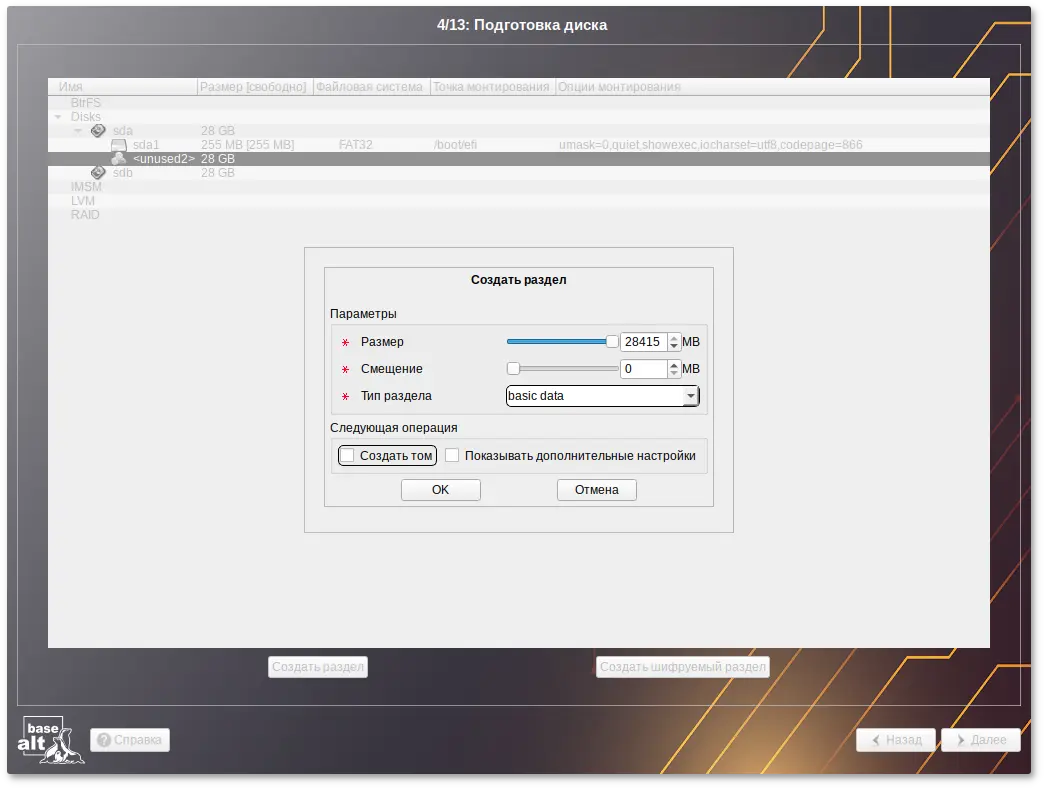

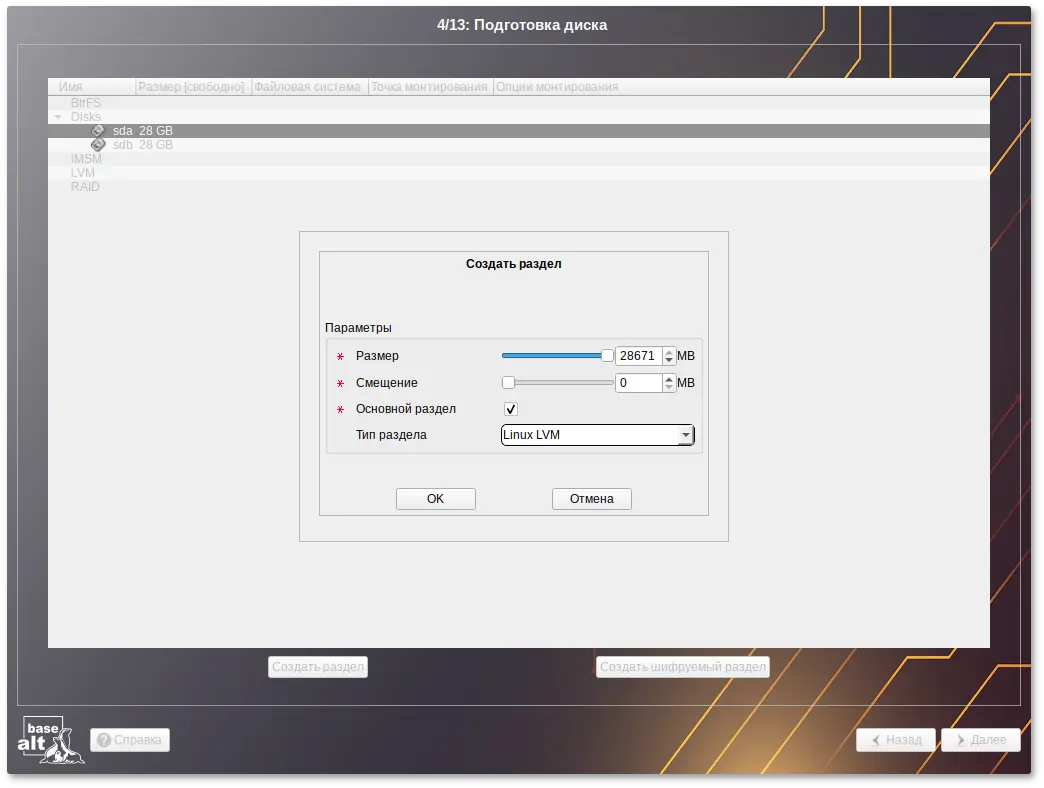

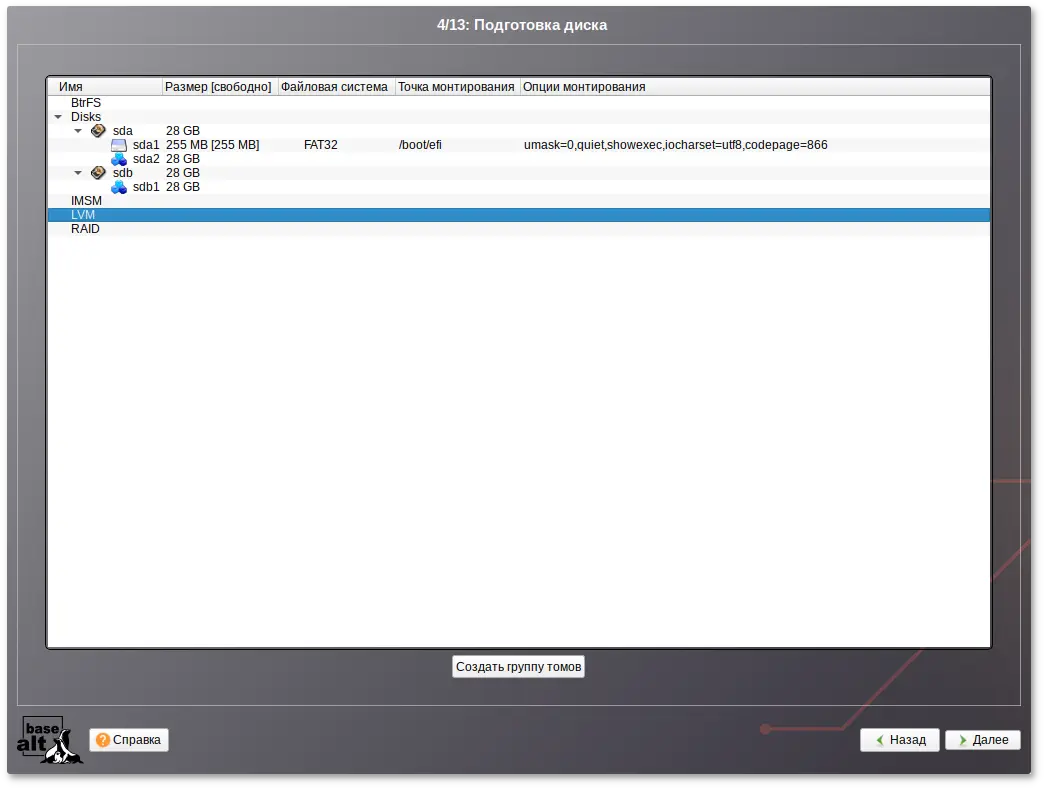

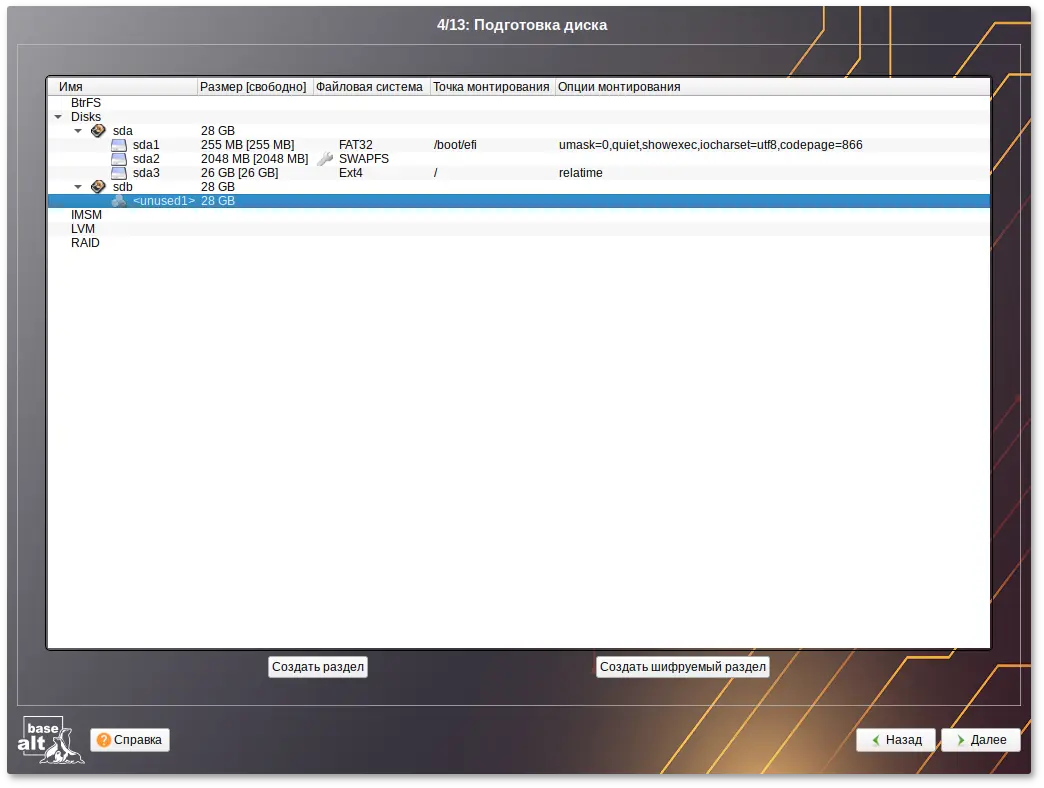

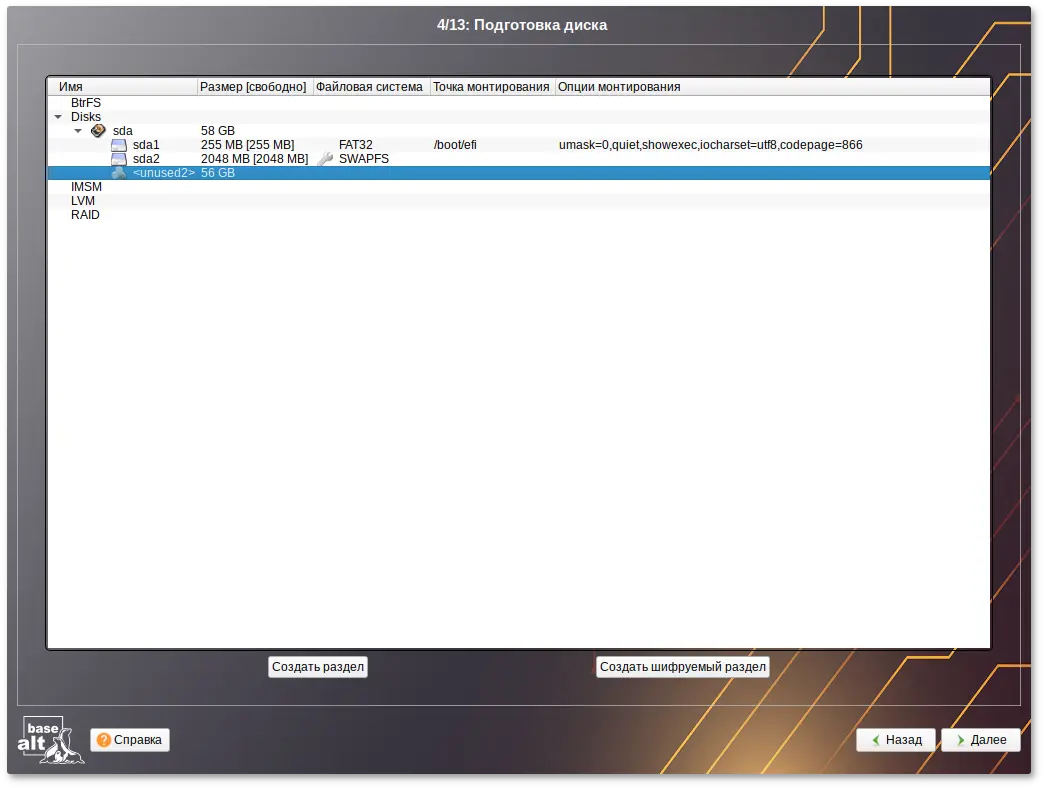

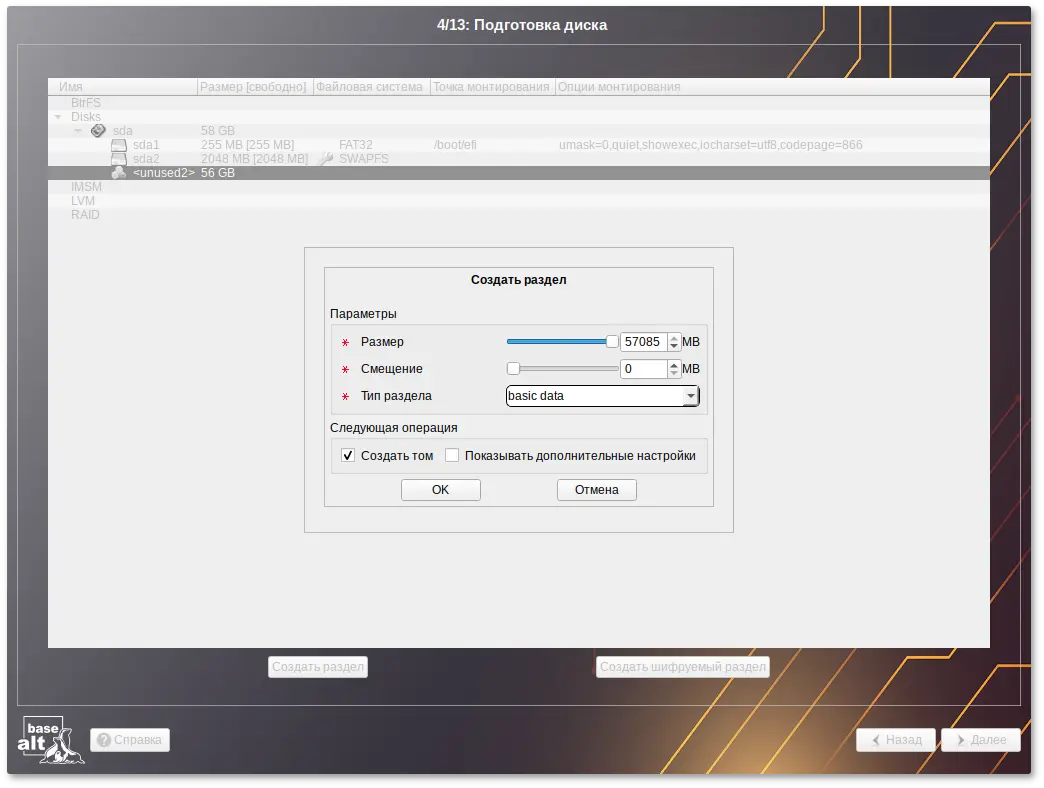

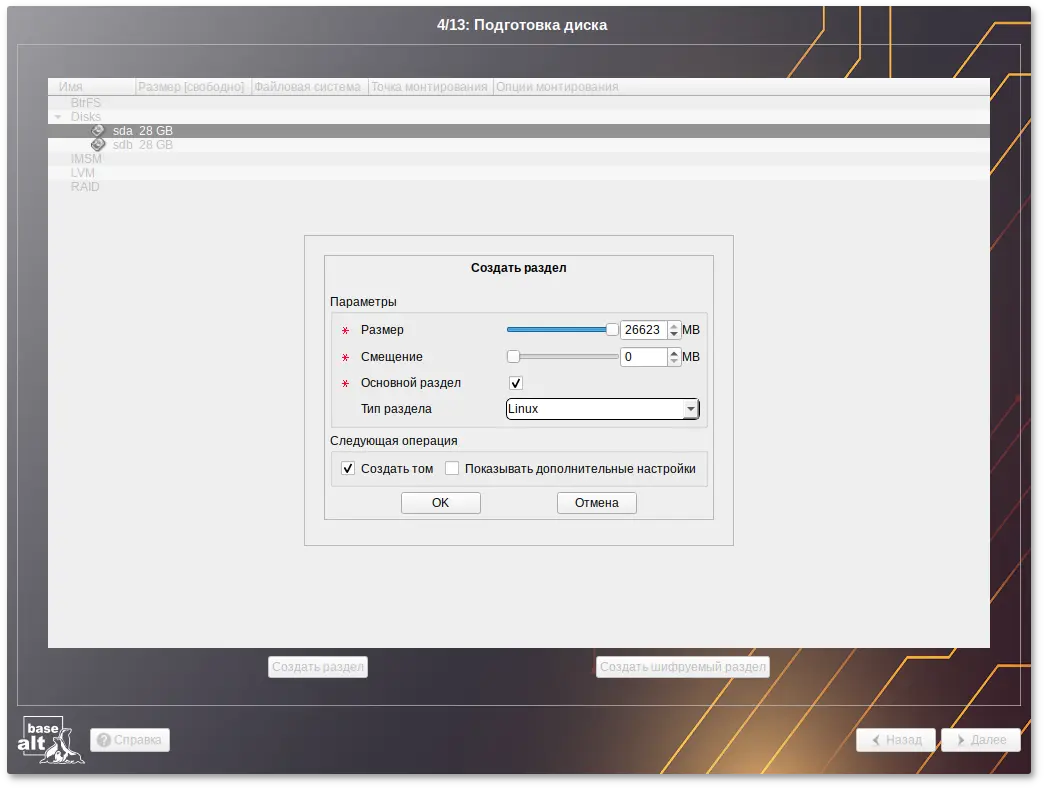

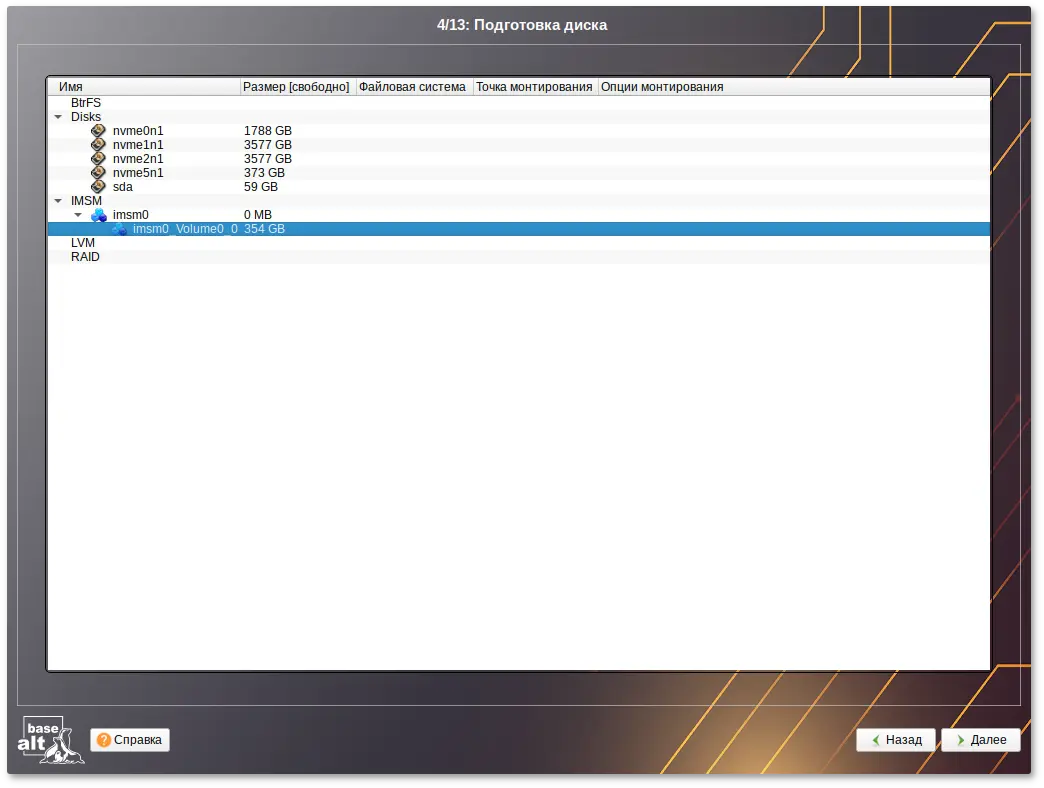

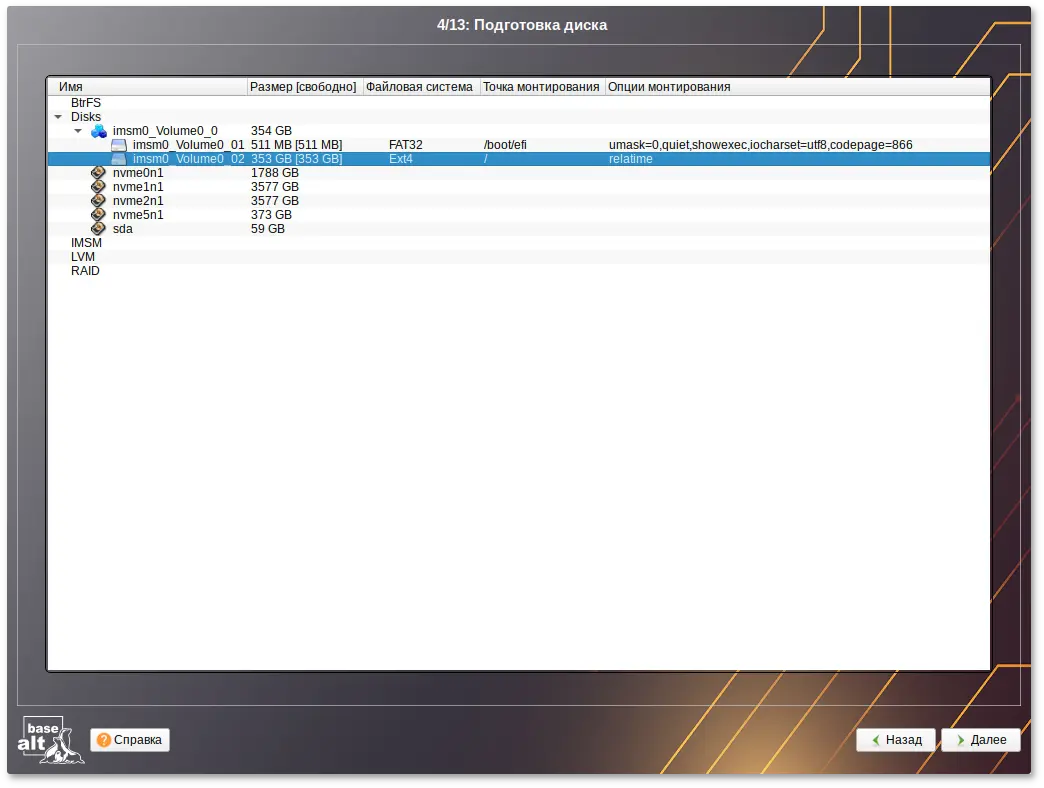

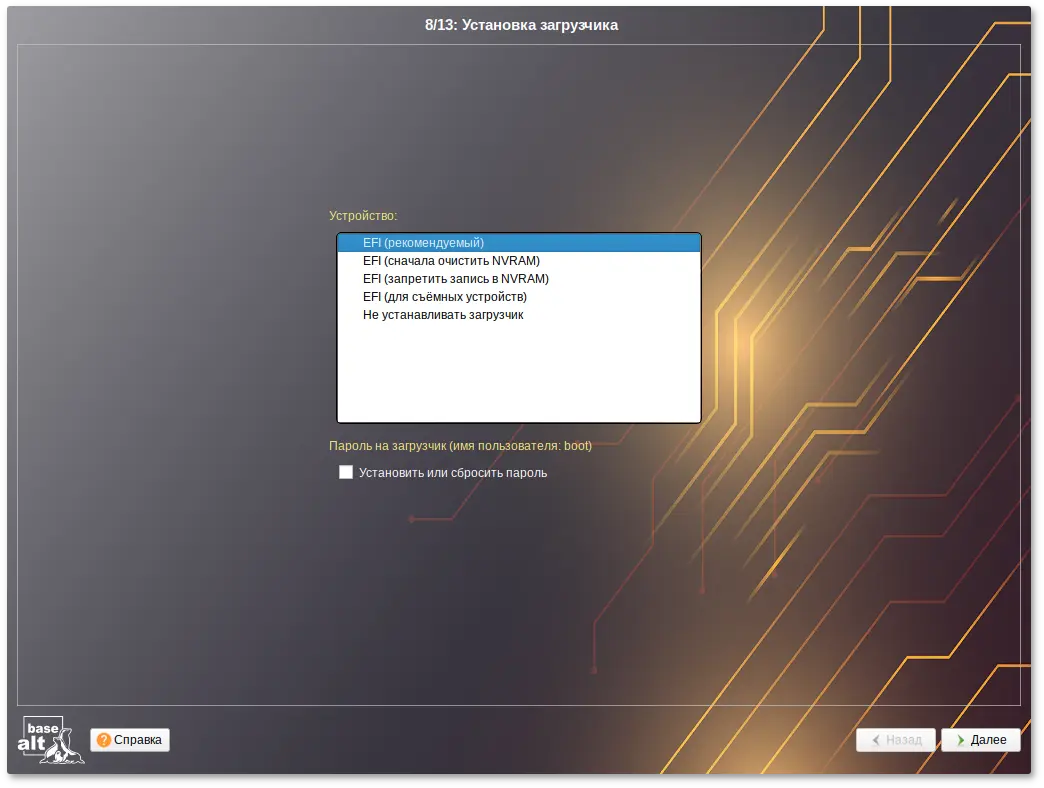

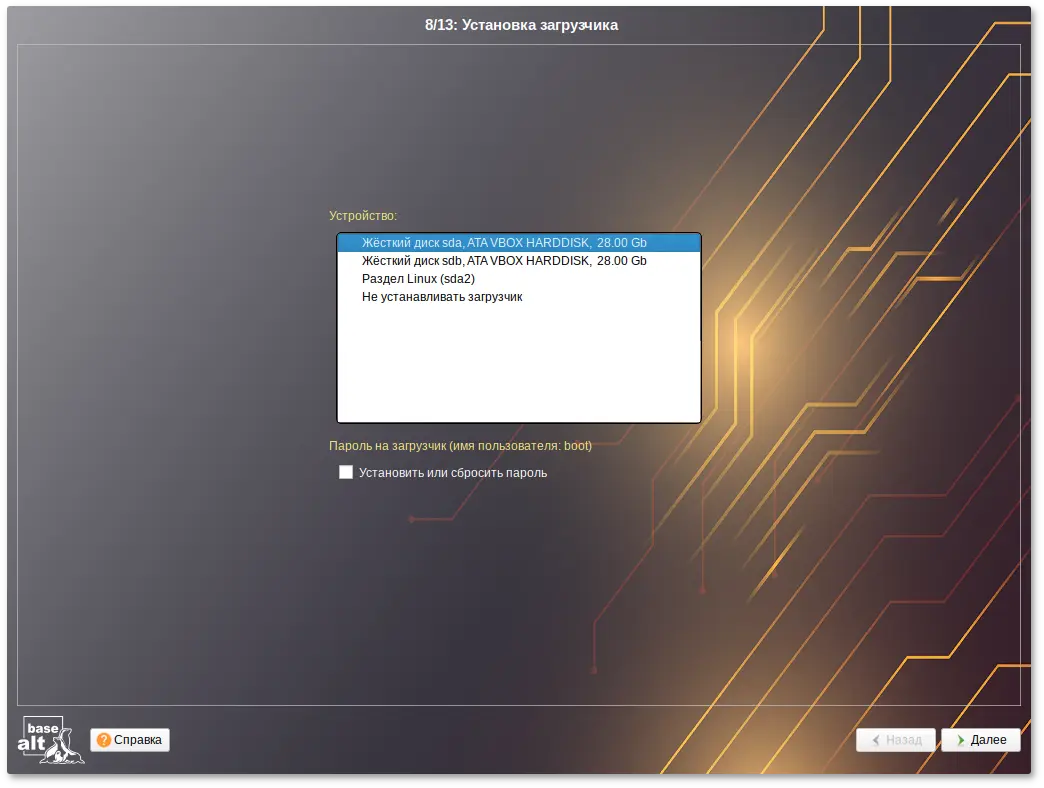

/boot/efi, в которую нужно смонтировать vfat раздел с загрузочными записями. Если такого раздела нет, то его надо создать вручную. При разбивке жёсткого диска в автоматическом режиме такой раздел создаёт сам установщик. Особенности разбиения диска в UEFI-режиме:

/boot/efi);

Примечание

Важно

Важно

Примечание

Примечание

Примечание

/boot/efi).

Важно

Важно

Примечание

Примечание

Предупреждение

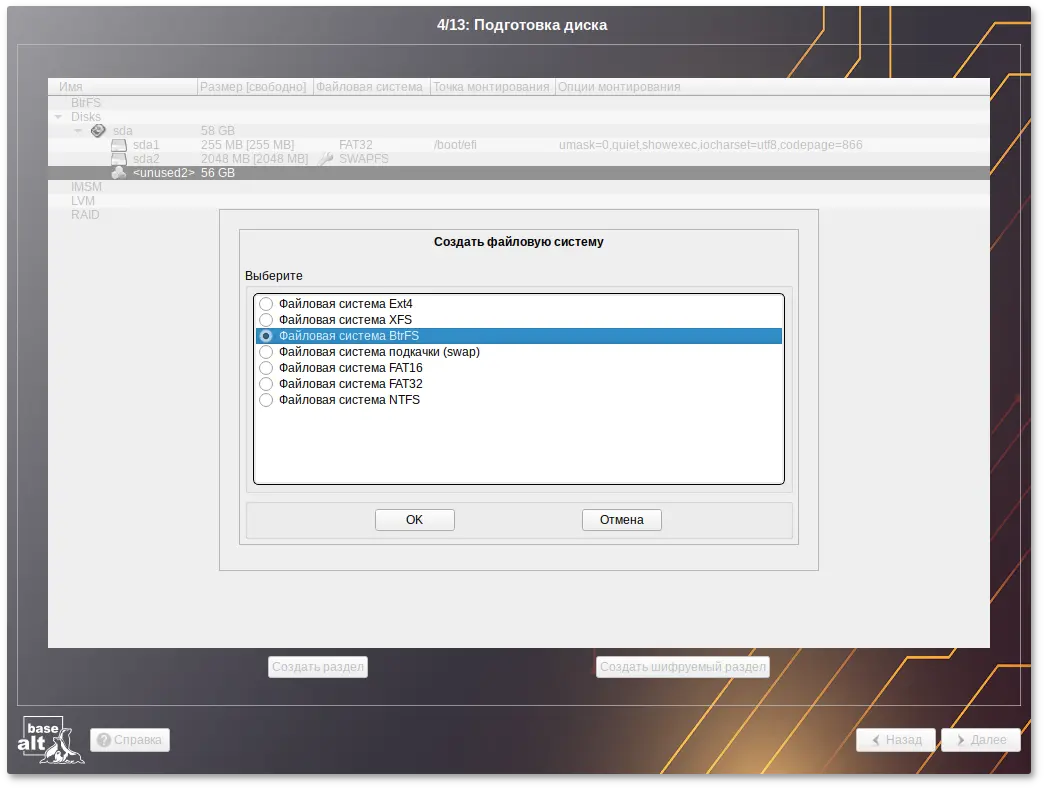

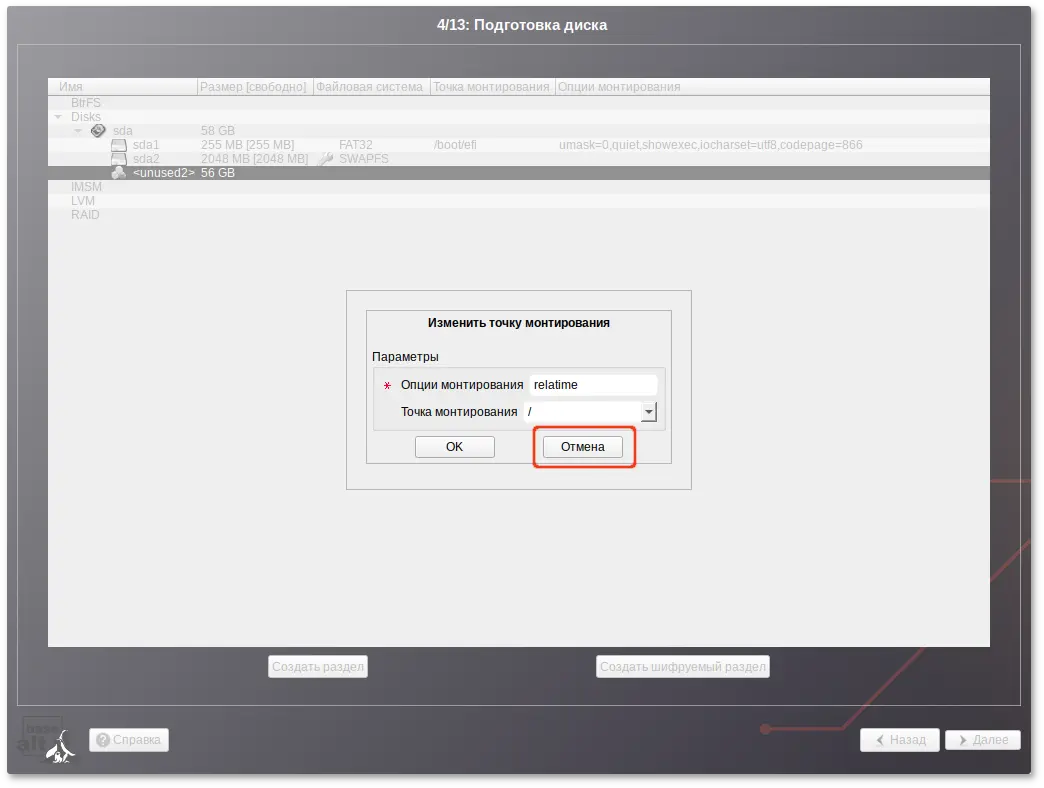

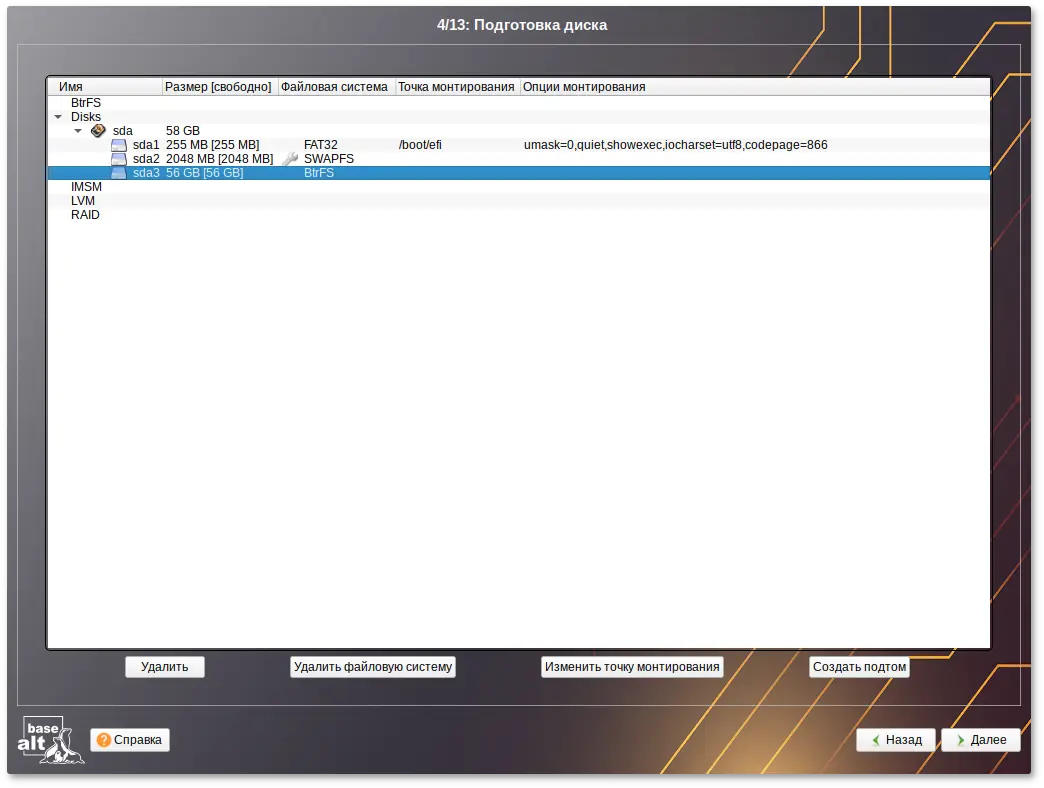

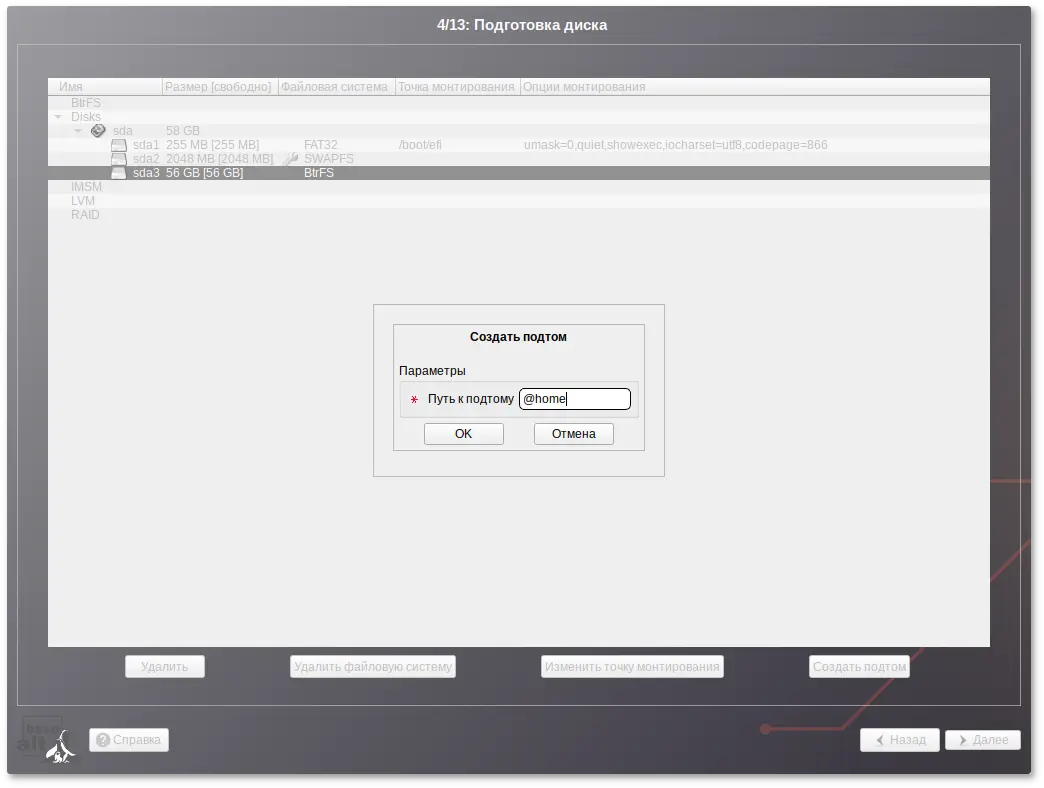

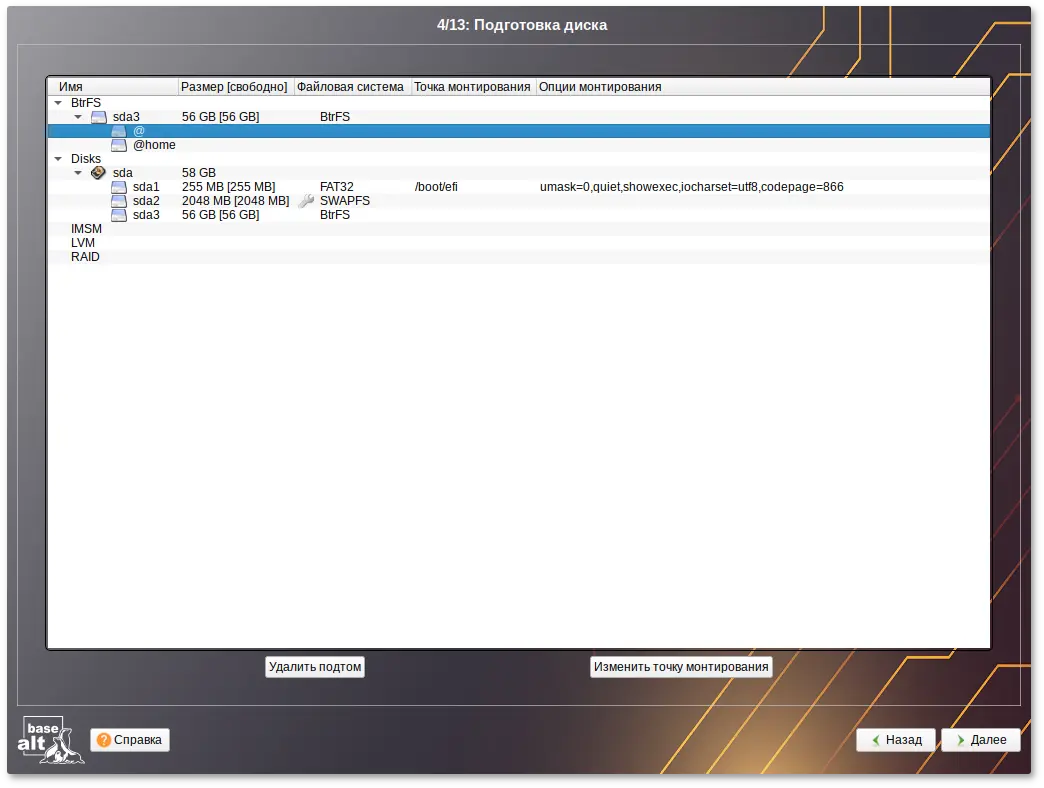

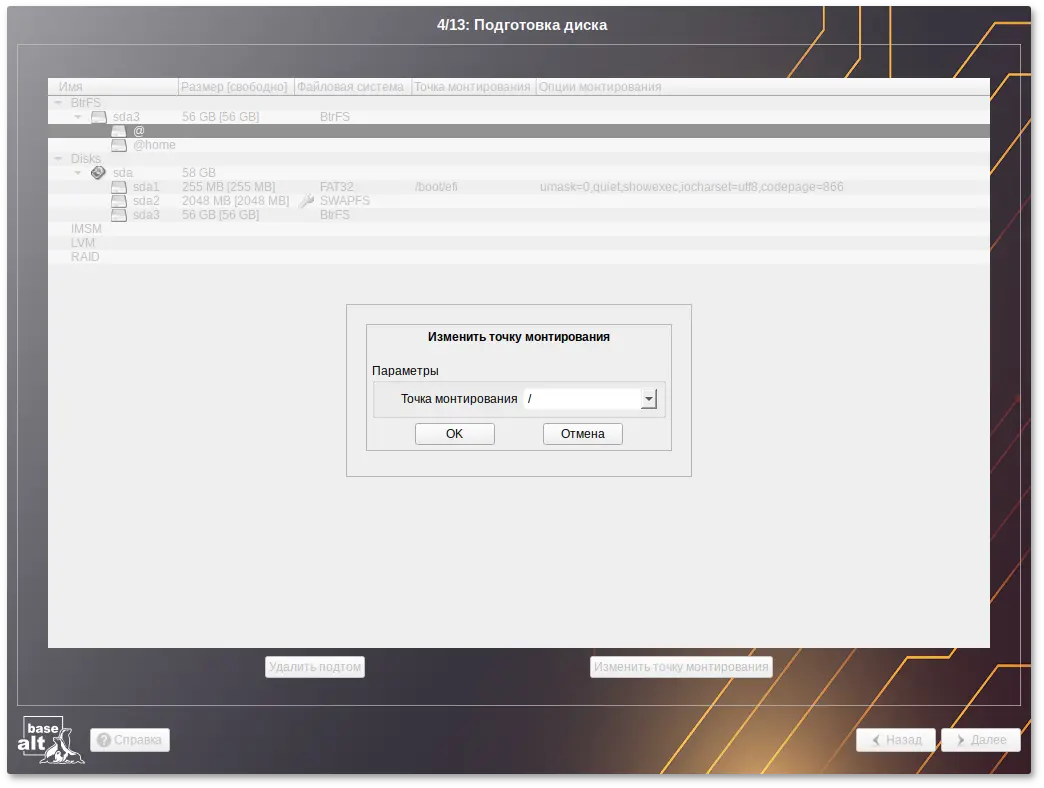

/ и /home создаются подтома с именами @ и @home. Это означает, что для монтирования подтомов необходимы определенные параметры вместо корня системы BtrFS по умолчанию:

/ с помощью опции subvol=@;

/home с помощью параметра монтирования subvol=@home.

Примечание

Примечание

Примечание

Примечание

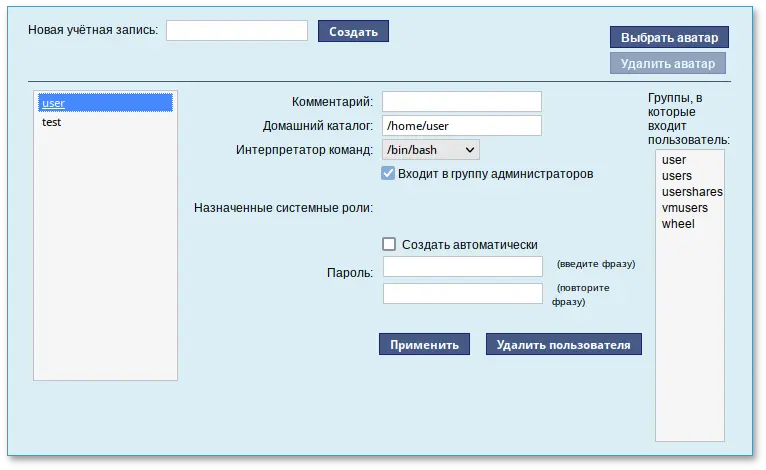

# builder-useradd <имя_пользователя>

и перелогиниться.

/etc/fstab).

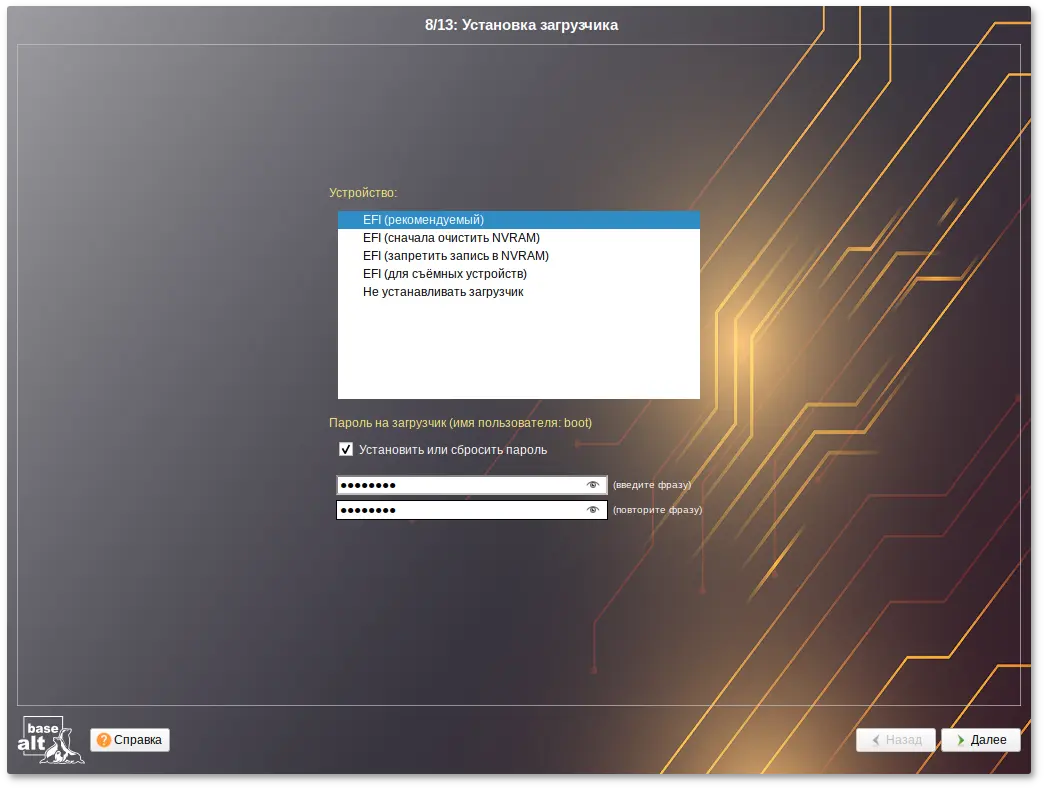

/root/.install-log, после чего из неё будут удалены все загрузочные записи, что приведёт к восстановлению полностью заполненной NVRAM и гарантирует загрузку вновь установленной ОС;

Примечание

Примечание

Примечание

Примечание

Примечание

Важно

Примечание

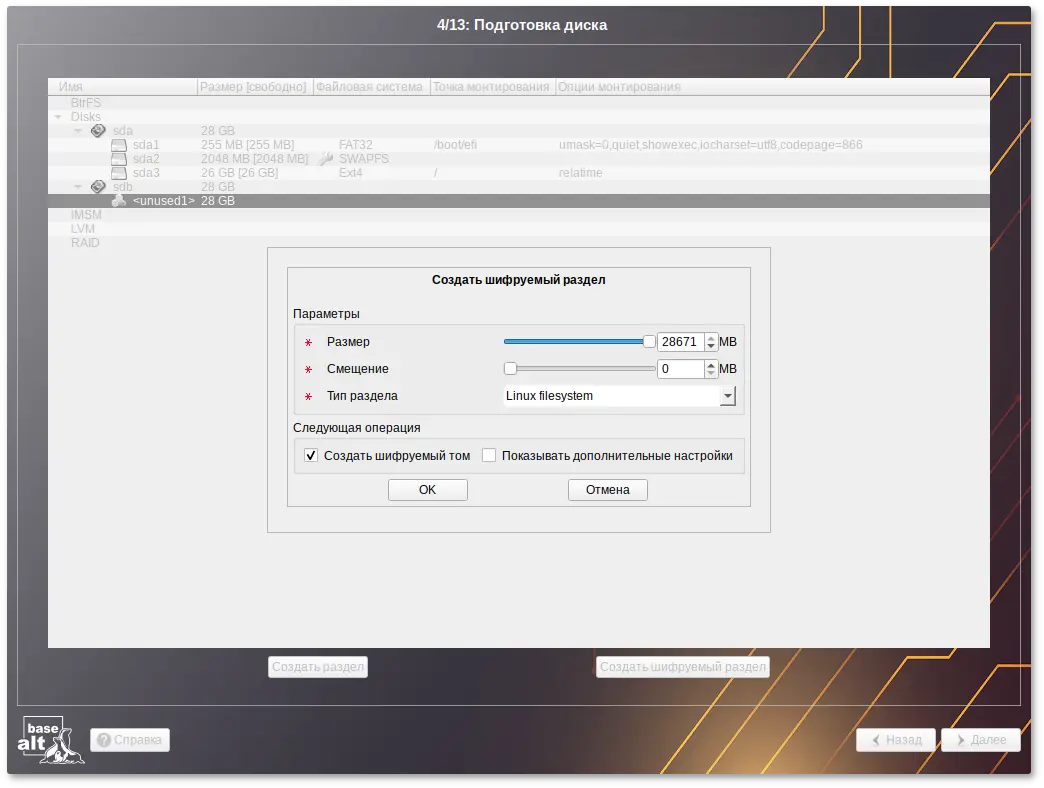

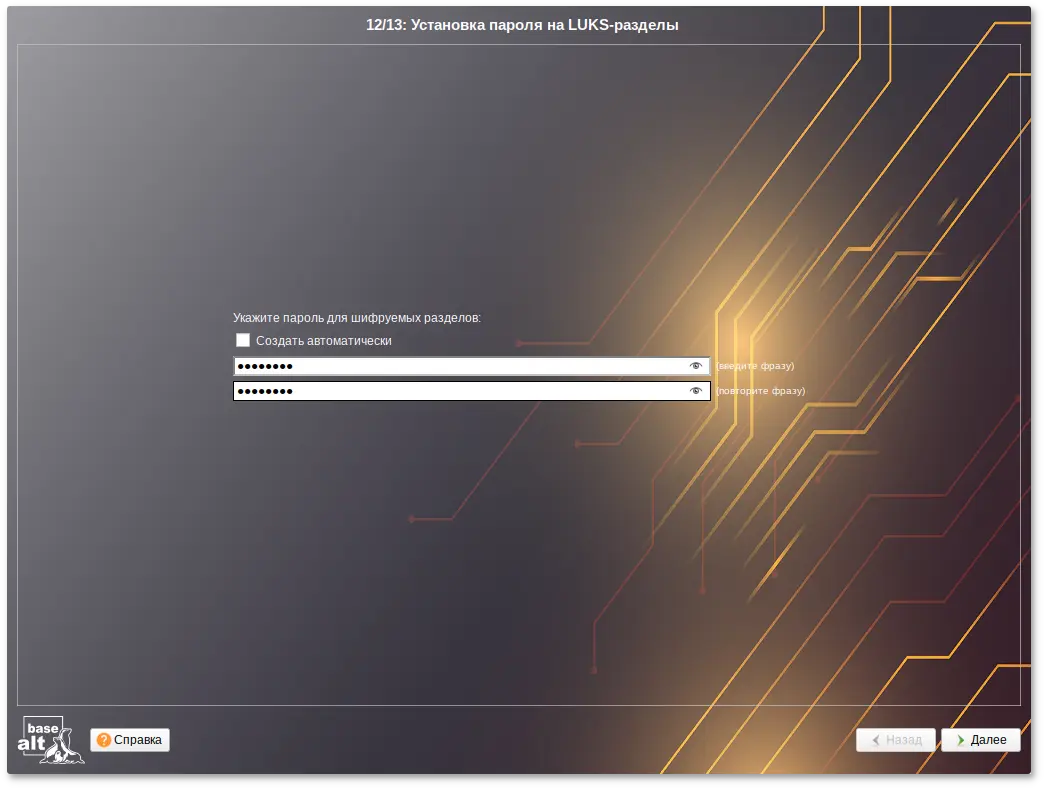

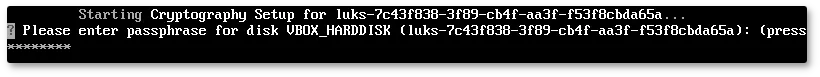

/home, то во время загрузки системы будет необходимо ввести пароль для этого раздела, иначе вы не сможете получить доступ в систему под своим именем пользователя.

Примечание

cryptsetup (см. Управление шифрованными разделами).

#apt-get update#apt-get dist-upgrade#update-kernel#apt-get clean#reboot

Примечание

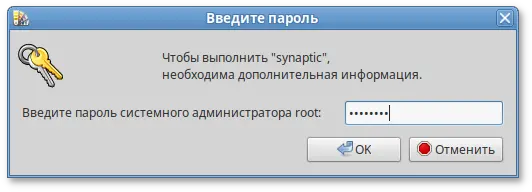

$ su -

или зарегистрировавшись в системе (например, на второй консоли Ctrl+Alt+F2) под именем root. Про режим суперпользователя можно почитать в главе Режим суперпользователя.

Примечание

Примечание

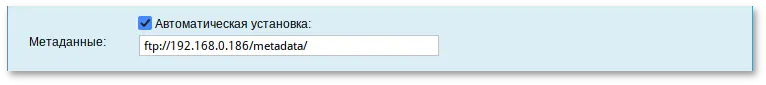

pkg-groups.tar — архив, содержащий дополнительные к базовой системе группы пакетов;

autoinstall.scm — сценарий автоматической установки на языке Scheme;

vm-profile.scm — различные варианты автоматической разбивки жёсткого диска на языке Scheme;

install-scripts.tar — архив, содержащий дополнительные скрипты для preinstall.d и postinstall.d в одноимённых каталогах. Скрипты должны быть исполняемыми. Скрипты из архива заменяют одноимённые скрипты инсталлятора.

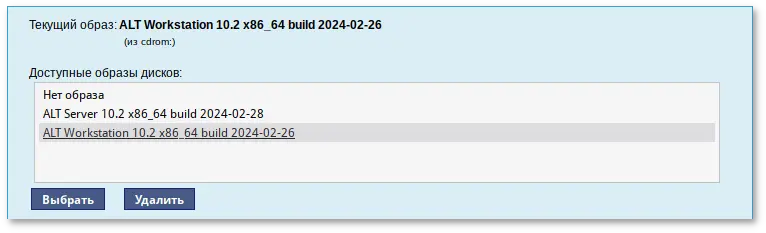

metadata), доступный по сети по протоколам HTTP или FTP.

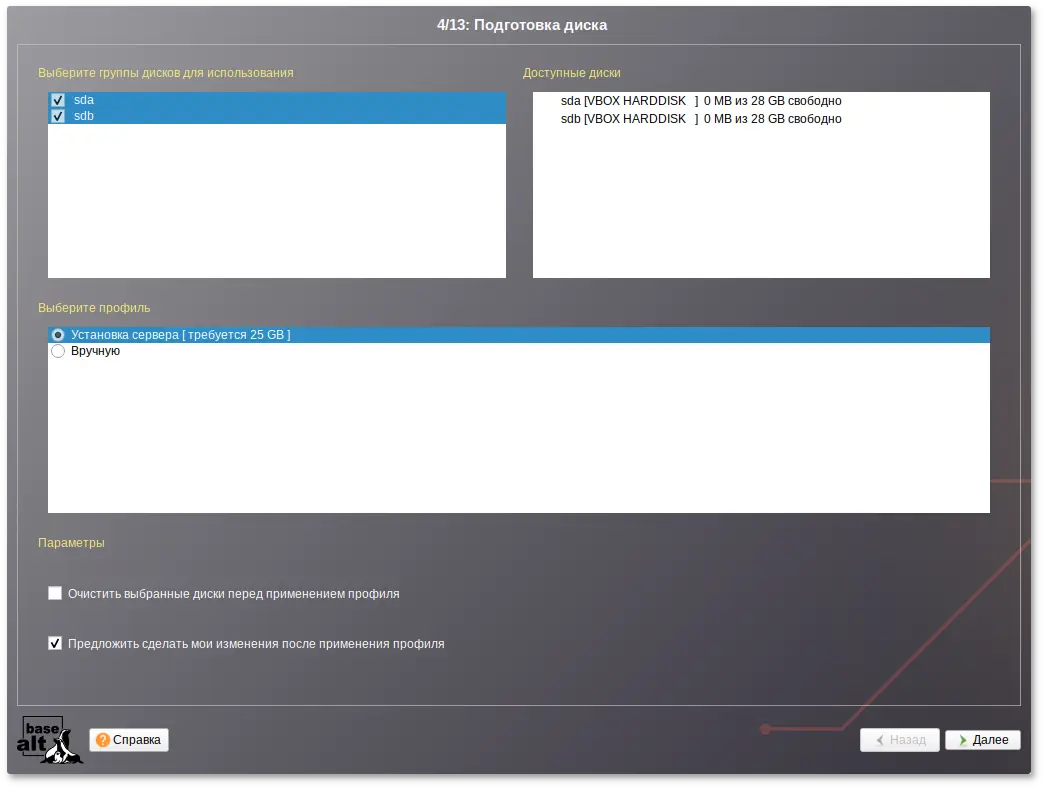

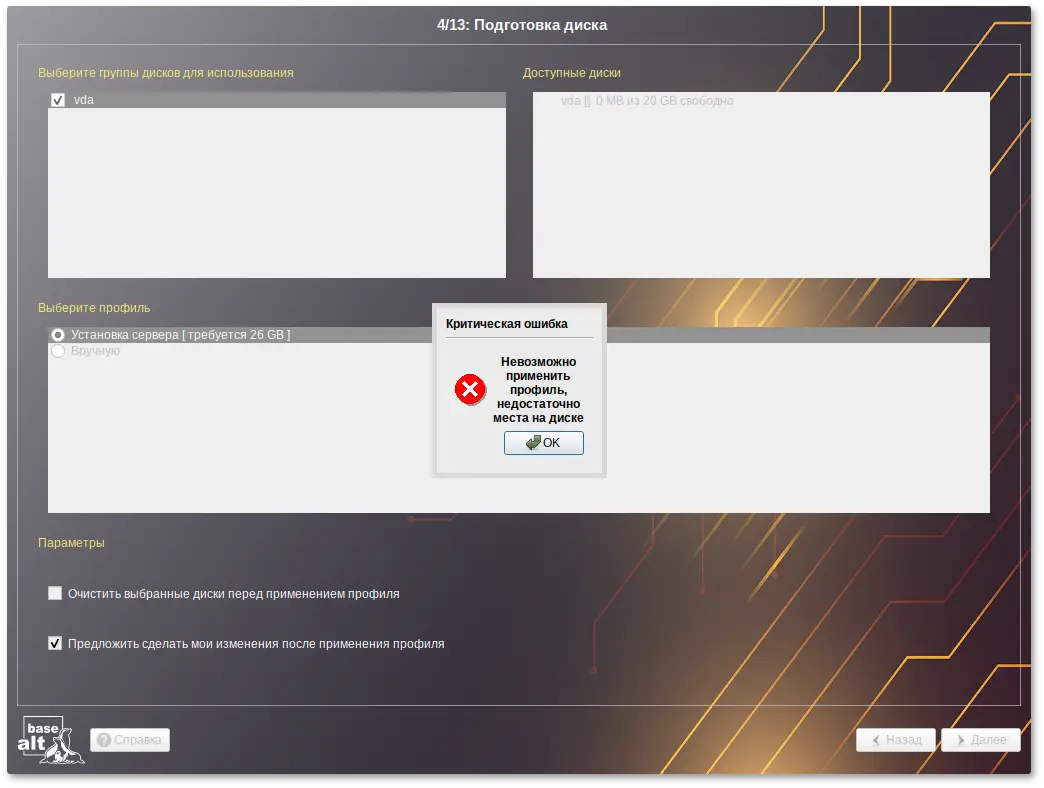

vm-profile.scm содержит сценарий на языке Scheme, описывающий формат автоматической разбивки жёсткого диска.

vm-profile.scm с одним профилем (server) разбивки жёсткого диска:

((server

(title . "Setup for server")

(action . trivial)

(actiondata ("swap" (size 2048000 . 2048000) (fsim . "SWAPFS") (methods plain))

("/" (size 16384000 . 16384000 ) (fsim . "Ext4") (methods plain))

("/var" (size 4096000 . #t ) (fsim . "Ext4") (methods plain))))

)

В примере указана разбивка:

Примечание

vm-profile.scm указываются в виде 512-байтных блоков, поэтому чтобы получить размер в байтах, нужно умножить значения на 512.

Примечание

/boot/efi не требуется — установщик добавит её сам.

vm-profile.scm с тремя профилями разбивки жёсткого диска:

((server

(title . "Setup for server")

(action . trivial)

(actiondata ("swap" (size 2048000 . 2048000) (fsim . "SWAPFS") (methods plain))

("/" (size 16384000 . 16384000 ) (fsim . "Ext4") (methods plain))

("/var" (size 4096000 . #t ) (fsim . "Ext4") (methods plain))))

(server_lvm

(title . "Setup for server LVM")

(action . trivial)

(actiondata ("swap" (size 2048000 . 2048000) (fsim . "SWAPFS") (methods lvm))

("/" (size 16384000 . 16384000 ) (fsim . "Ext4") (methods lvm))

("/var" (size 4096000 . #t ) (fsim . "Ext4") (methods lvm))))

(timeshift

(title . "Timeshift-compatible setup")

(action . trivial)

(actiondata ("swap" (size 2048000 . 2048000) (fsim . "SWAPFS") (methods plain))

("" (size 40632320 . #t) (fsim . "BtrFS") (methods plain) (subvols ("@" . "/") ("@home" . "/home")))))

)

В примере указаны профили:

/var;

/var в томе LVM;

autoinstall.scm:

("/evms/profiles/server_lvm" action apply commit #f clearall #t exclude ())

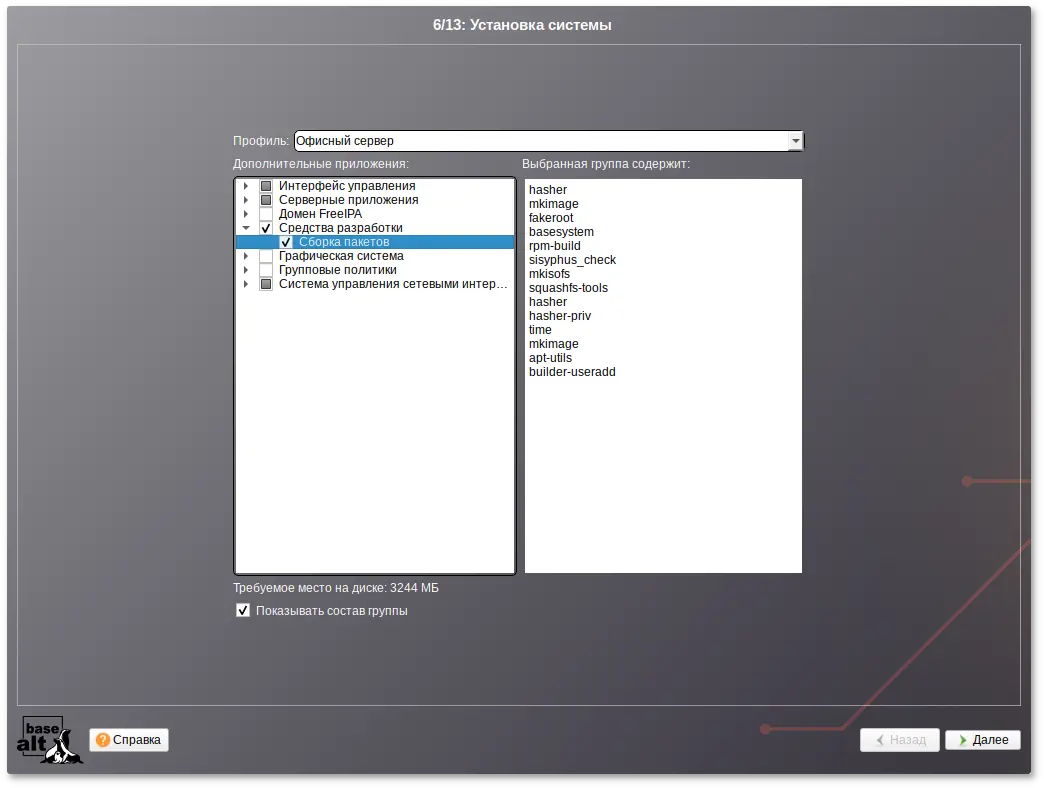

pkg-groups.tar представляет собой tar-архив с двумя подкаталогами:

groups — содержит описание групп программного обеспечения в файлах *.directory;

lists — содержит файлы со списками пакетов для каждой группы и скрытый файл .base, содержащий список пакетов «базовой системы» (то есть те пакеты, которые устанавливаются в любом случае).

pkg-groups.tar проще всего взять из установочного ISO-образа из каталога /Metadata/ и доработать, если необходимо.

$ tar xf pkg-groups.tar

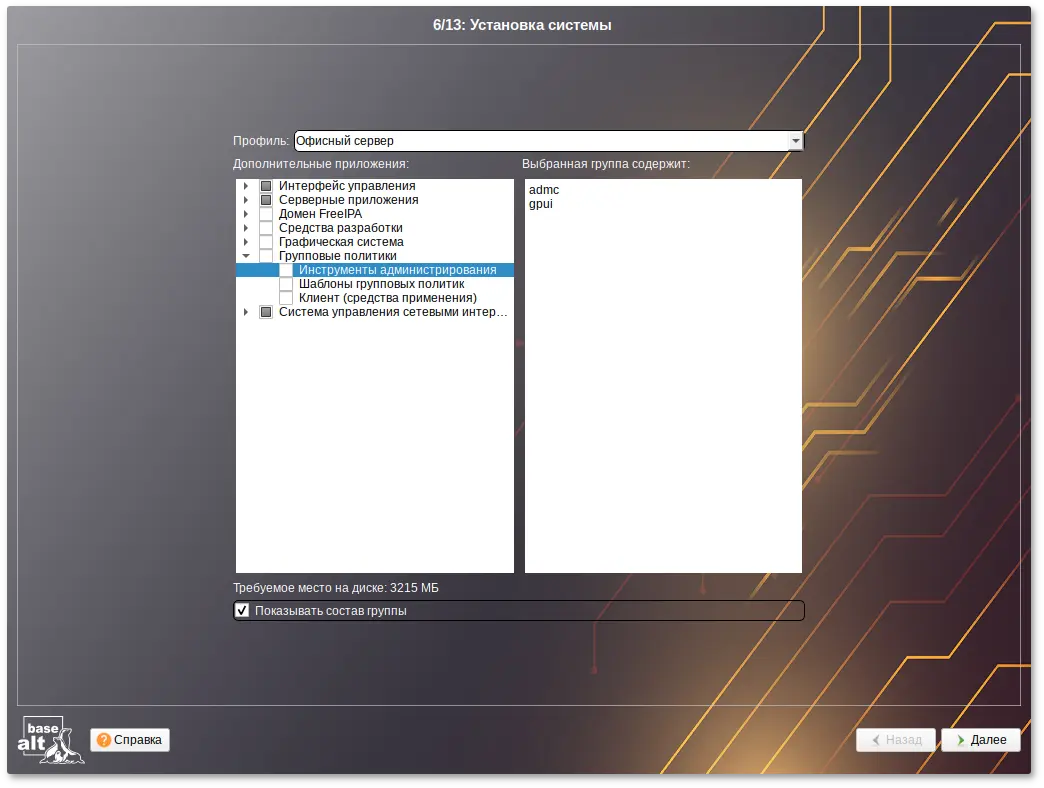

lists и добавить или изменить файл группы. Имена пакетов указываются по одному в каждой строке, например, содержимое файла admc:

admc alterator-gpupdate gpupdate local-policy admx-basealt samba-dc-common admx-firefox admx-chromium gpui

$ tar cf pkg-groups.tar groups lists

autoinstall.scm:

(("pkg-install") action "write" lists "group-1 group-2" auto #t)

где group-1 и group-2 — имена файлов со списками пакетов из подкаталога lists.

Важно

autoinstall.scm представляет собой командный скрипт для программы установки, написанный с использованием языка программирования Scheme. Каждая строка скрипта — команда для модуля программы установки.

autoinstall.scm:

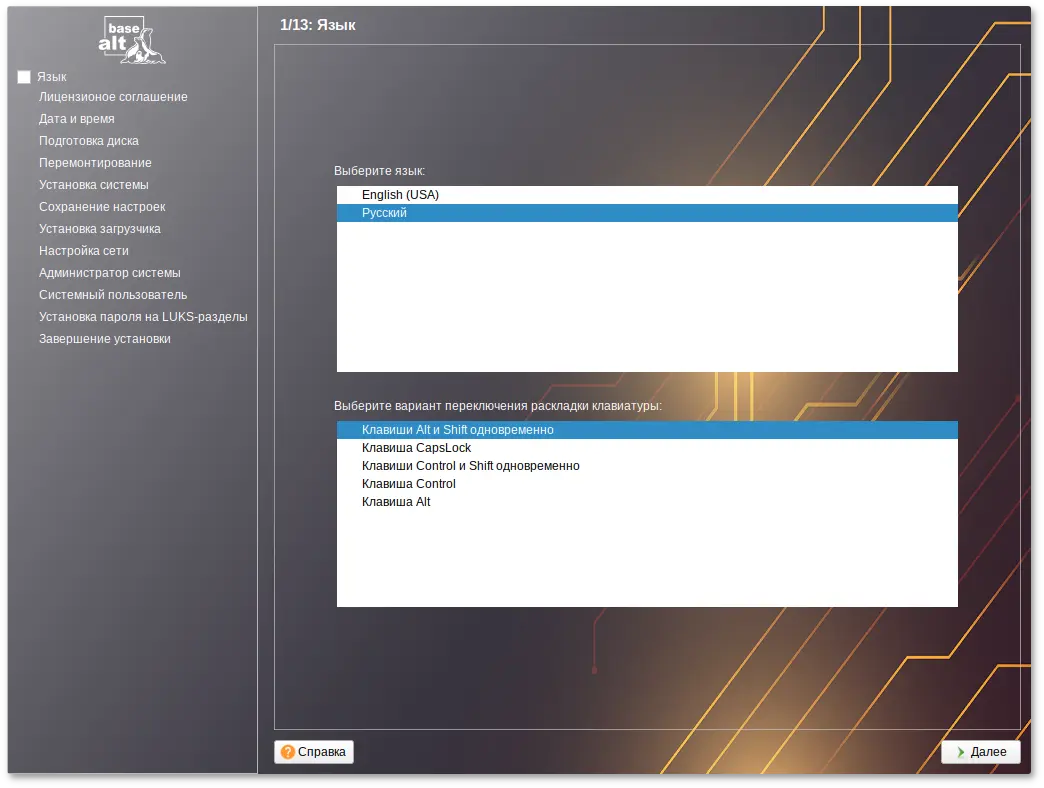

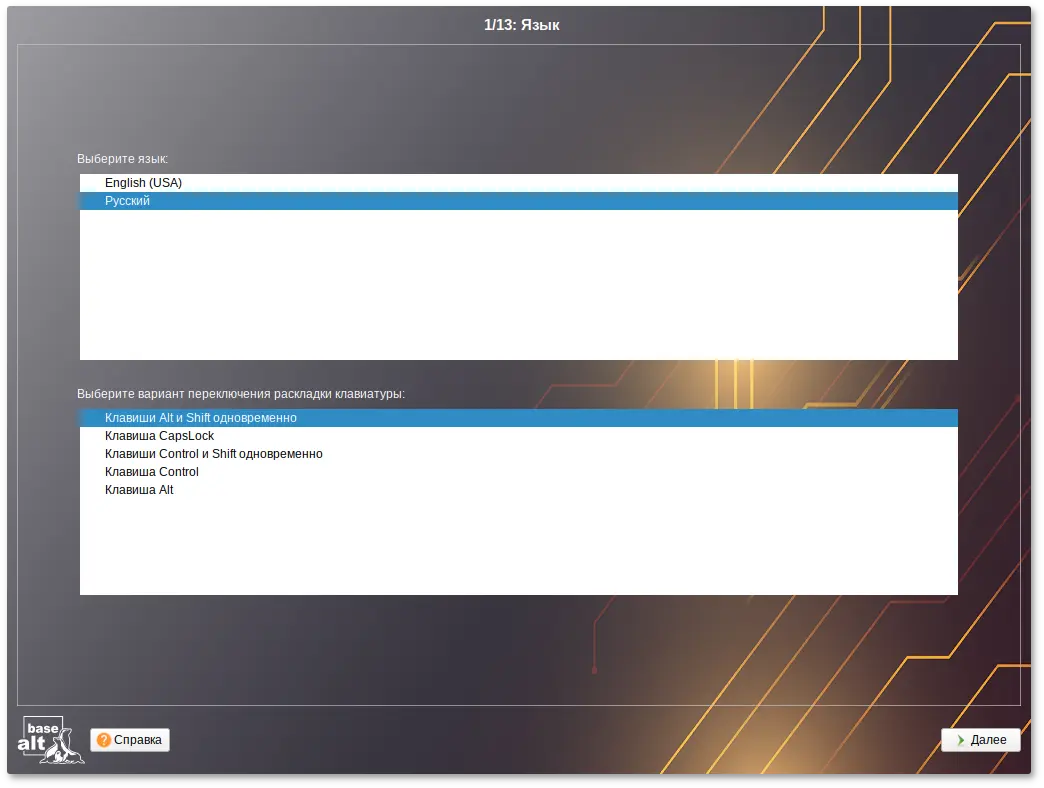

; установка языка операционной системы (ru_RU)

("/sysconfig-base/language" action "write" lang ("ru_RU"))

; установка переключателя раскладки клавиатуры на Ctrl+Shift

("/sysconfig-base/kbd" language ("ru_RU") action "write" layout "ctrl_shift_toggle")

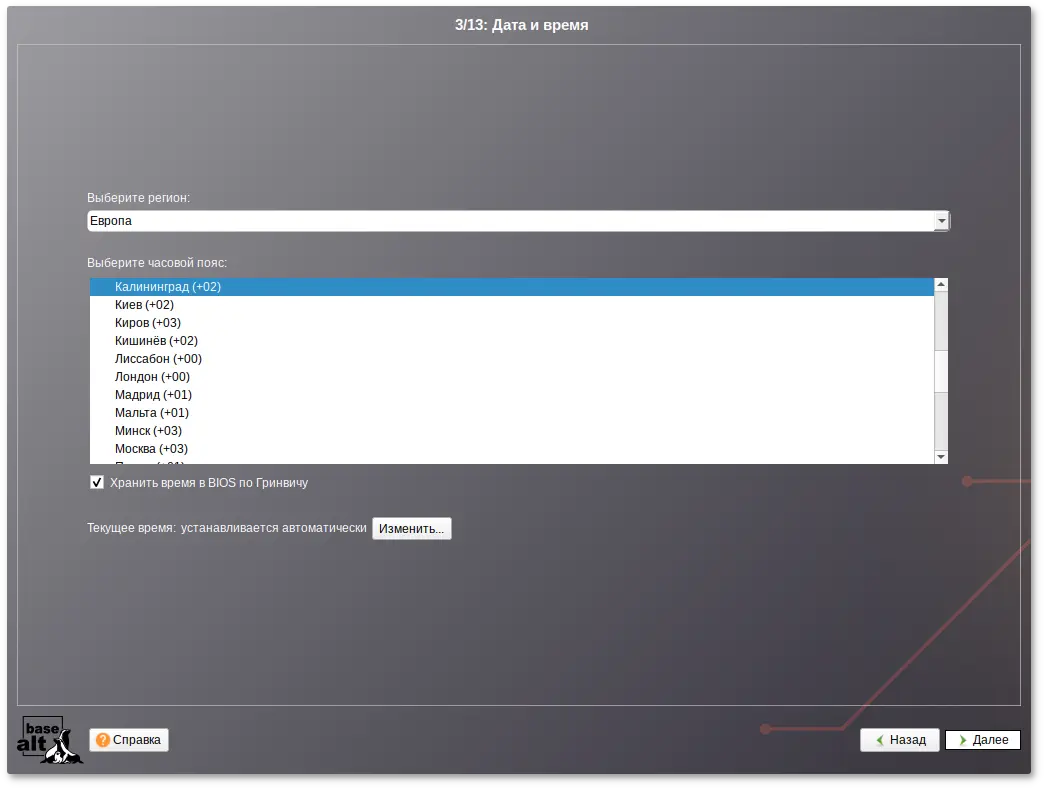

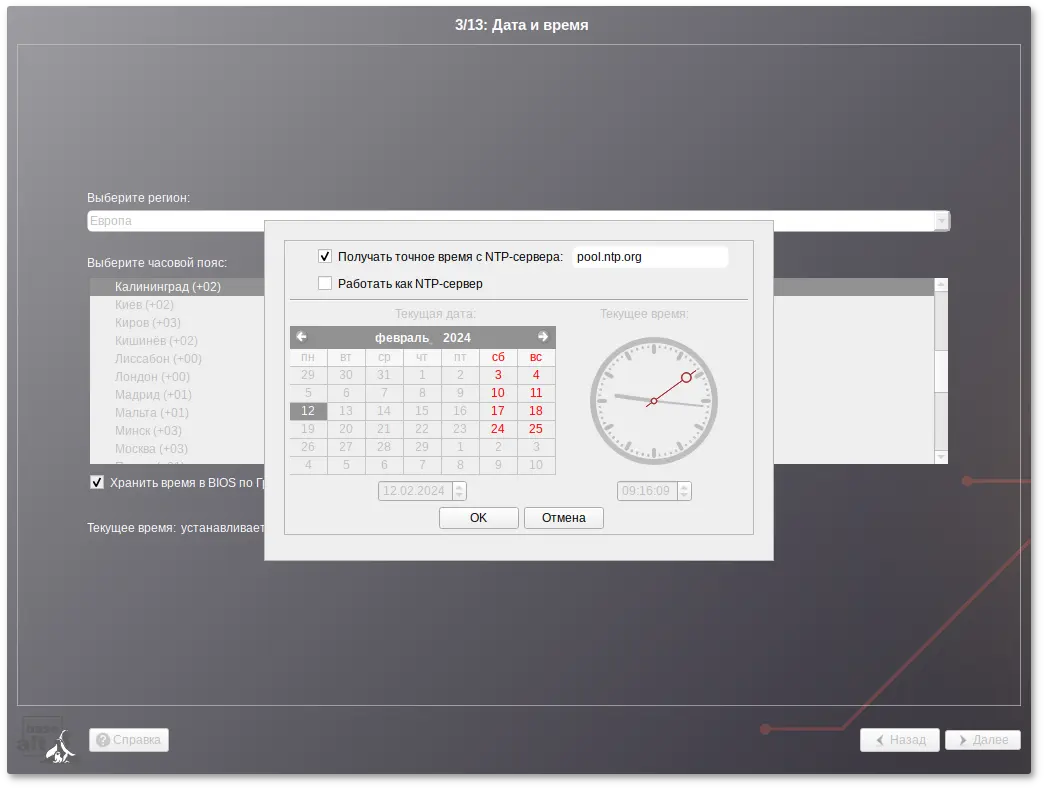

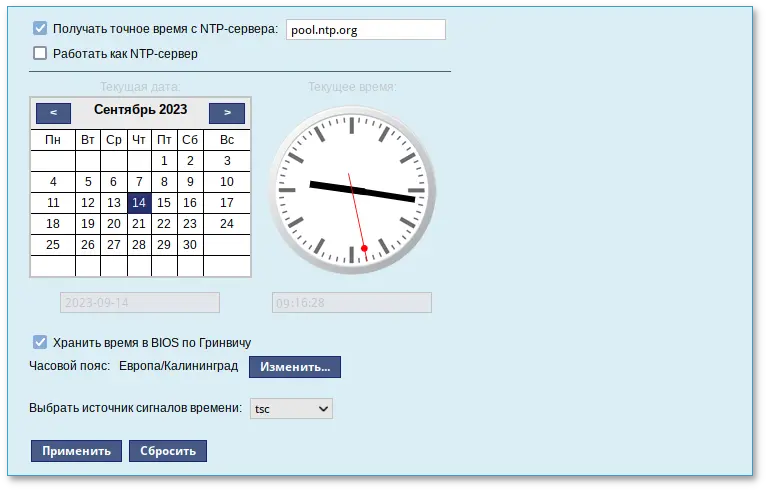

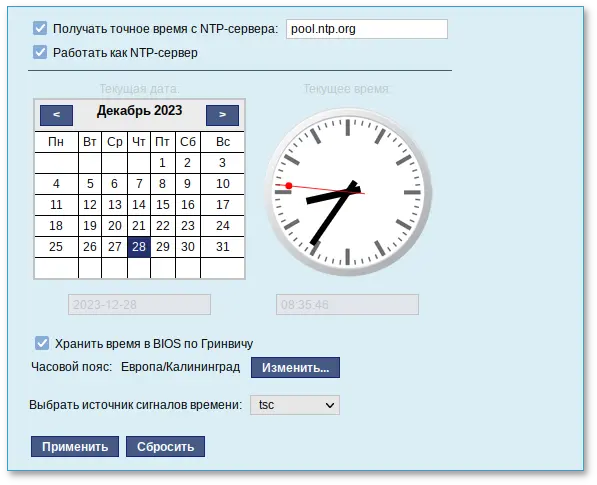

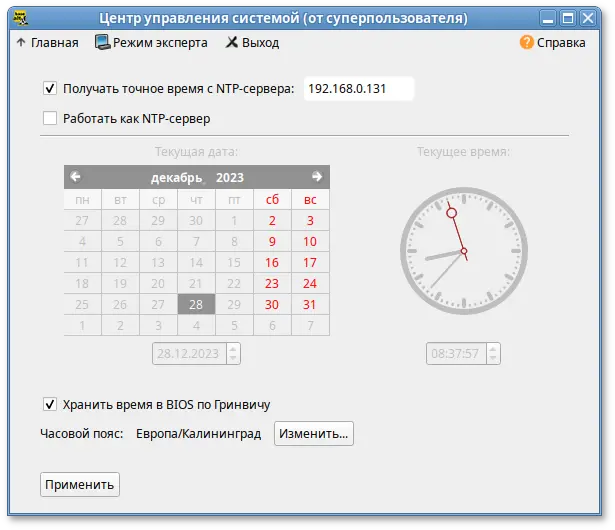

; установка часового пояса в Europe/Moscow, время в BIOS будет храниться в UTC

("/datetime-installer" action "write" commit #t name "RU" zone "Europe/Moscow" utc #t)

; автоматическая разбивка жёсткого диска в профиле server_lvm

("/evms/control" action "write" control open installer #t)

("/evms/control" action "write" control update)

("/evms/profiles/server_lvm" action apply commit #f clearall #t exclude ())

("/evms/control" action "write" control commit)

("/evms/control" action "write" control close)

; перемонтирование

("/remount-destination" action "write")

; установка пакетов операционной системы

("pkg-init" action "write")

; установка только базовой системы (дополнительные группы пакетов из pkg-groups.tar указываются по именам через пробел)

("/pkg-install" action "write" lists "" auto #t)

("/preinstall" action "write")

; установка загрузчика GRUB в efi

("/grub" action "write" device "efi" passwd #f passwd_1 "*" passwd_2 "*")

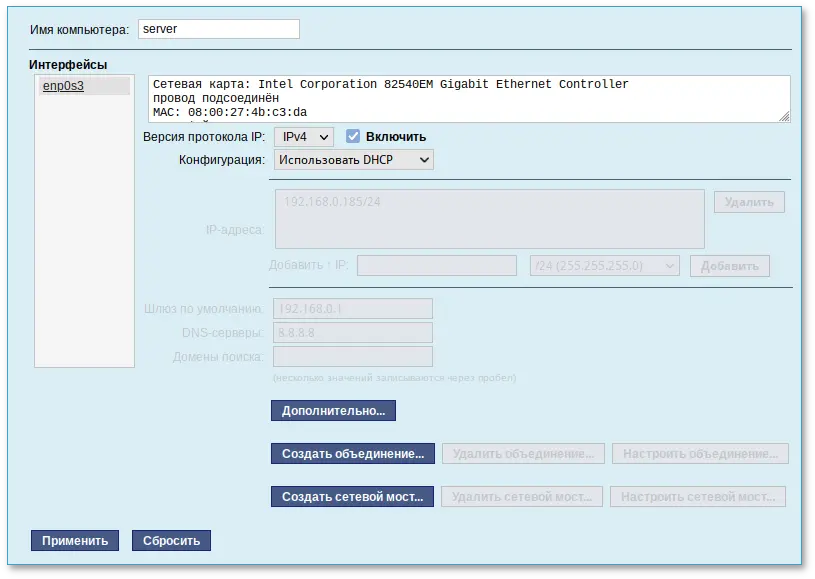

; настройка сетевого интерфейса на получение адреса по DHCP

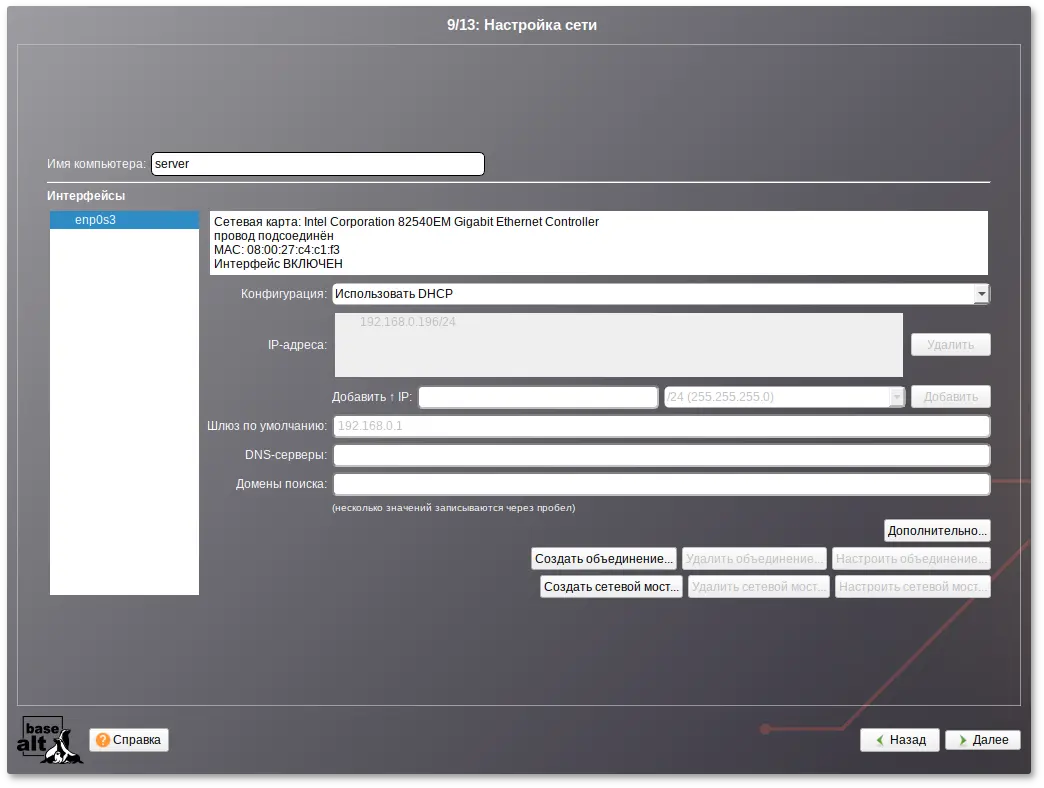

("/net-eth" action "write" reset #t)

("/net-eth" action "write" name "enp0s3" ipv "4" configuration "dhcp" default "" search "" dns "" computer_name "newhost" ipv_enabled #t)

("/net-eth" action "write" commit #t)

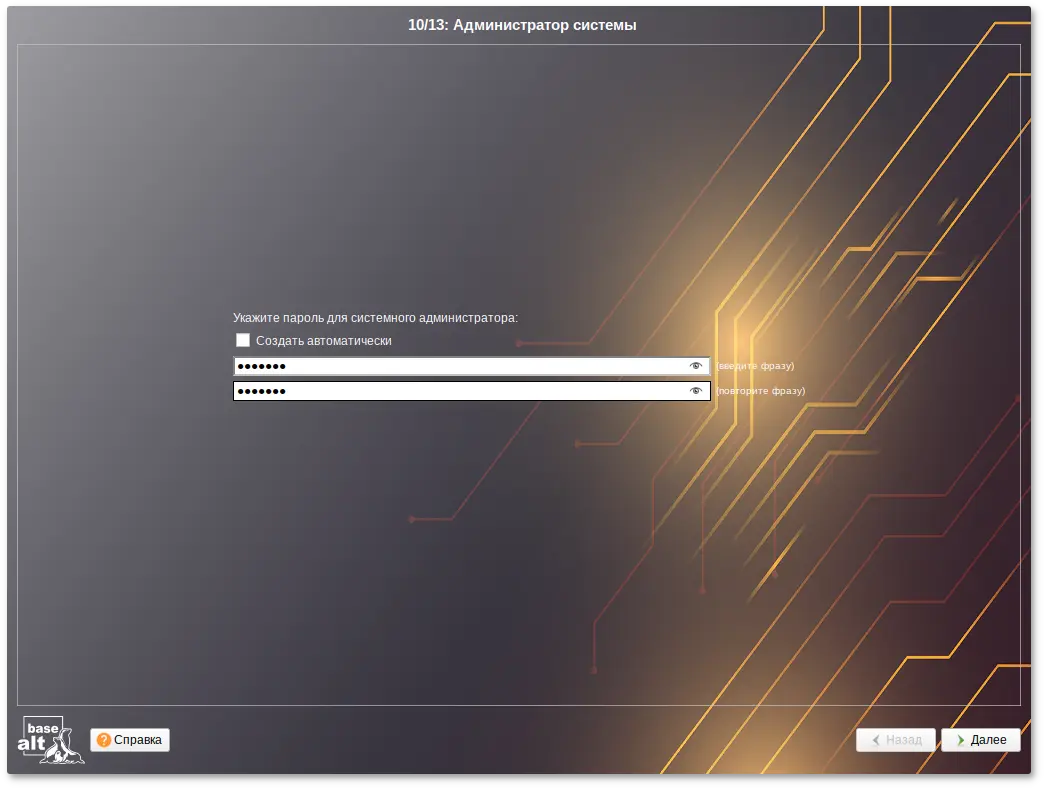

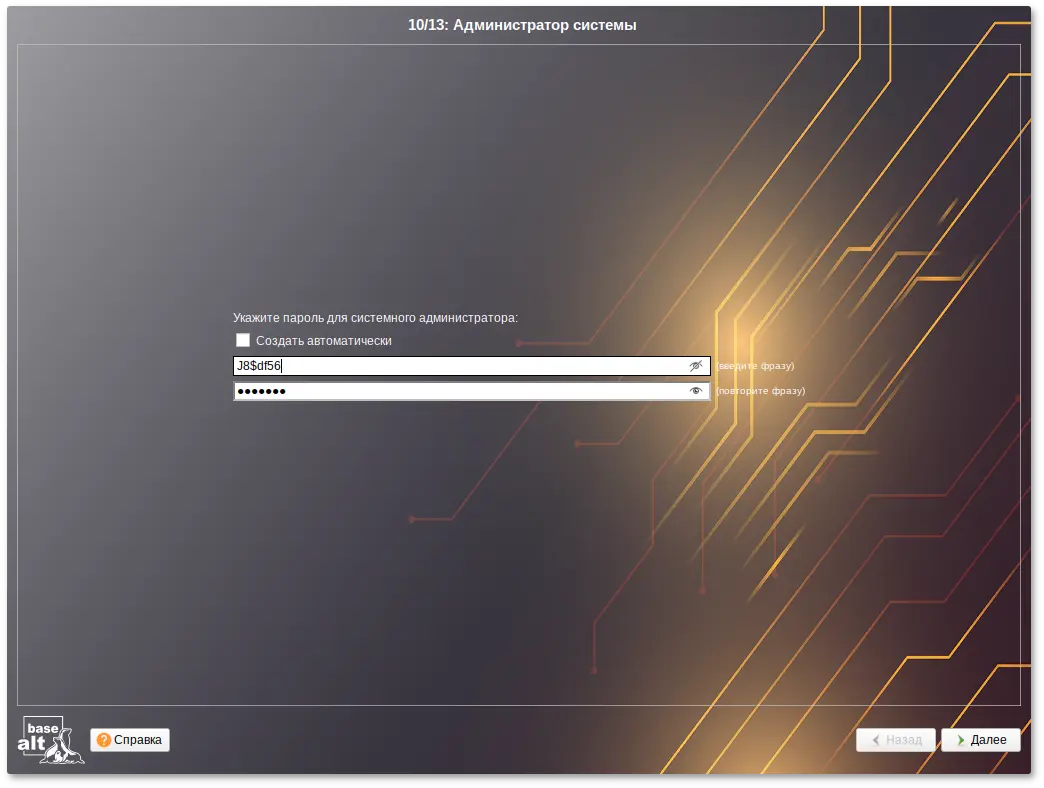

; установка пароля суперпользователя root '123'

("/root/change_password" passwd_2 "123" passwd_1 "123")

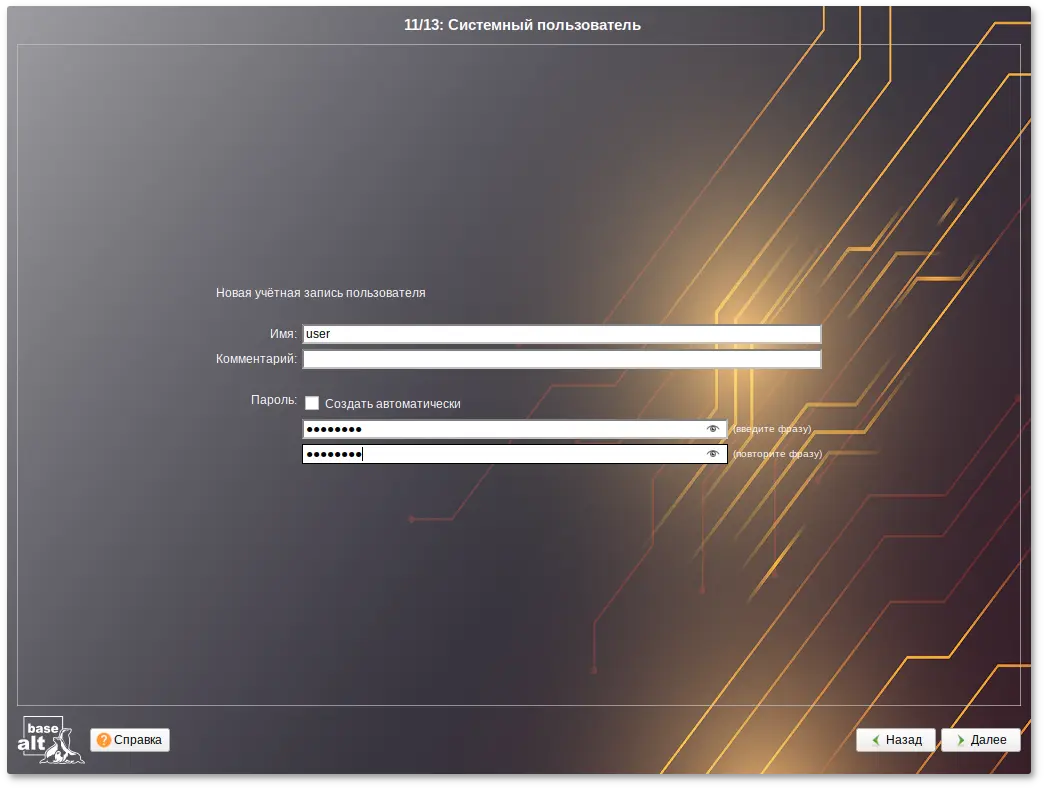

; задание первого пользователя 'user' с паролем '123'

("/users/create_account" new_name "user" gecos "user" allow_su #t auto #f passwd_1 "123" passwd_2 "123" autologin #f)

;("/postinstall/firsttime" script "ftp://192.168.0.123/metadata/update.sh")

("/pkg-install" action "write" lists "centaurus/mate" auto #t)

("/grub" action "write" device "efi" passwd #t passwd_1 "123" passwd_2 "123")

Если установка происходит в режиме Legacy, то загрузчик GRUB необходимо установить на первый жёсткий диск, например:

("/grub" action "write" device "/dev/sda" passwd #f passwd_1 "*" passwd_2 "*")

("/net-eth" action "write" reset #t)

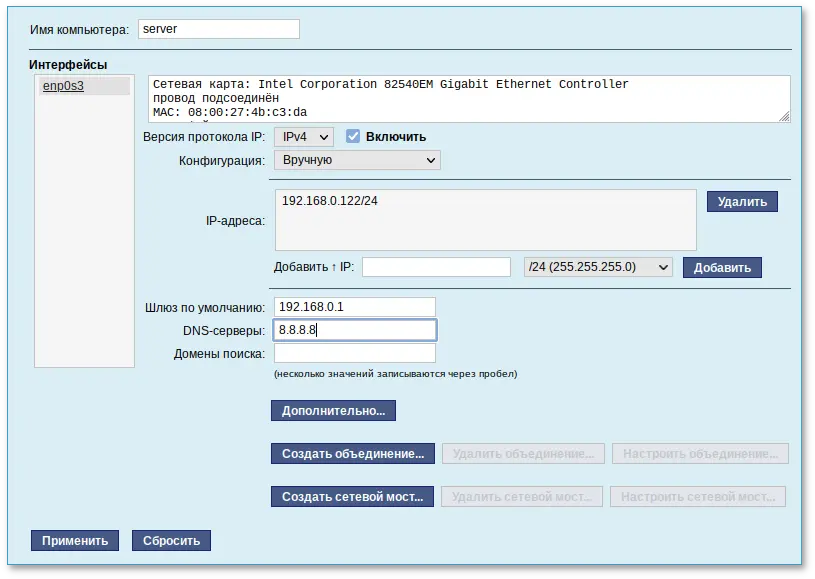

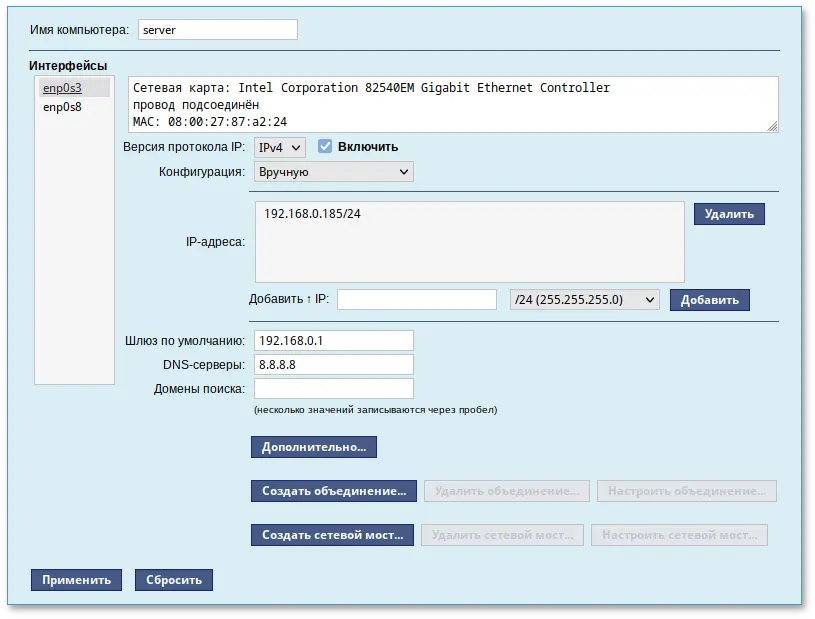

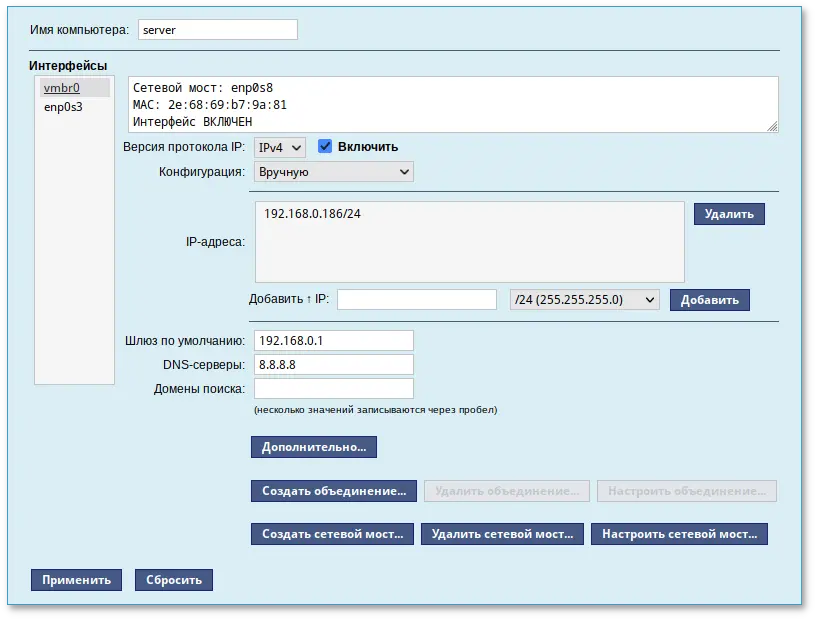

("/net-eth" action "write" name "enp0s3" ipv "4" configuration "static" default "192.168.0.1" search "" dns "8.8.8.8" computer_name "newhost" ipv_enabled #t)

("/net-eth" action "add_iface_address" name "enp0s3" addip "192.168.0.25" addmask "24" ipv "4")

("/net-eth" action "write" commit #t)

где:

addip "192.168.0.25" — IP-адрес;

default "192.168.0.1" — шлюз по умолчанию;

dns "8.8.8.8" — DNS-сервер;

computer_name "newhost" — имя хоста.

autoinstall.scm можно добавить шаг /postinstall, который позволяет в конце установки или при первом запуске ОС выполнить команду или скрипт. Например:

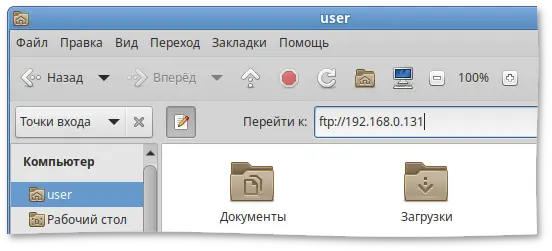

("/postinstall/firsttime" script "ftp://192.168.0.123/metadata/update.sh")

laststate — скрипт запускается перед перезагрузкой после установки ОС;

firsttime — скрипт запускается во время первого запуска ОС.

script — скрипт скачивается с сервера и выполняется;

run — выполняется заданная команда или набор команд (возможно указание перенаправления).

("/postinstall/firsttime" script "http://server/script.sh")

("/postinstall/firsttime" run "curl --silent --insecure http://server/finish")

("/postinstall/laststate" script "http://server/script.sh")

("/postinstall/laststate" run "curl --silent --insecure http://server/gotoreboot")

Примечание

laststate для работы с установленной системой требуется указывать пути с $destdir или выполнять команды через run_chroot:

#!/bin/sh a= . install2-init-functions run_chroot sh -c "date > /root/STAMP_1" date > $destdir/root/STAMP_2

install-scripts.tar представляет собой tar-архив содержащий дополнительные скрипты.

preinstall.d, скрипты postinstall.d — в каталог postinstall.d. Упаковать архив можно, например, выполнив команду:

$ tar cf install-scripts.tar preinstall.d postinstall.d

Примечание

$destdir или выполнять команды через run_chroot:

#!/bin/sh a= . install2-init-functions run_chroot sh -c "date > /root/STAMP_1" date > $destdir/root/STAMP_2

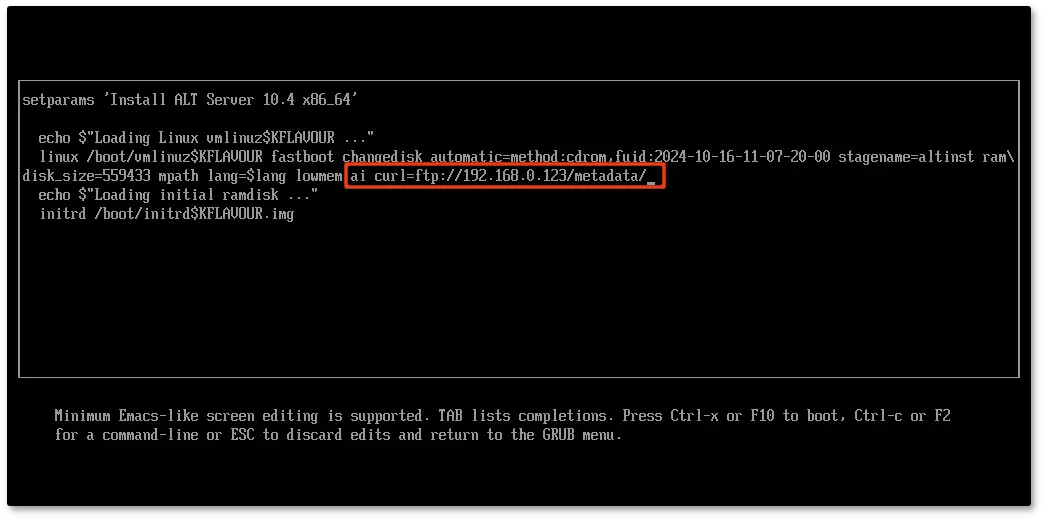

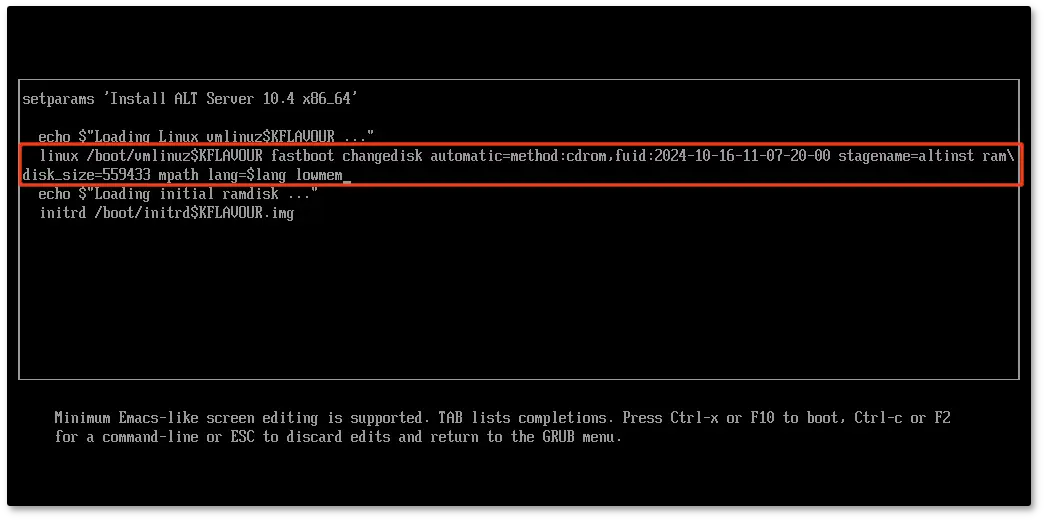

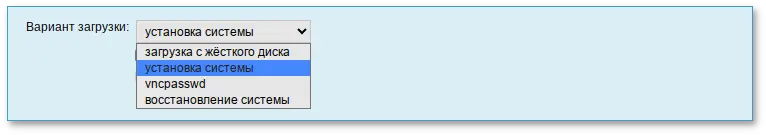

ai (без значения) и параметр curl с указанием каталога с установочными файлами. Формат адреса в curl должен быть представлен в виде URL:

ai curl=ftp://<IP-адрес>/metadata/

/Metadata/.

/usr/share/install2/metadata/.

Важно

Важно

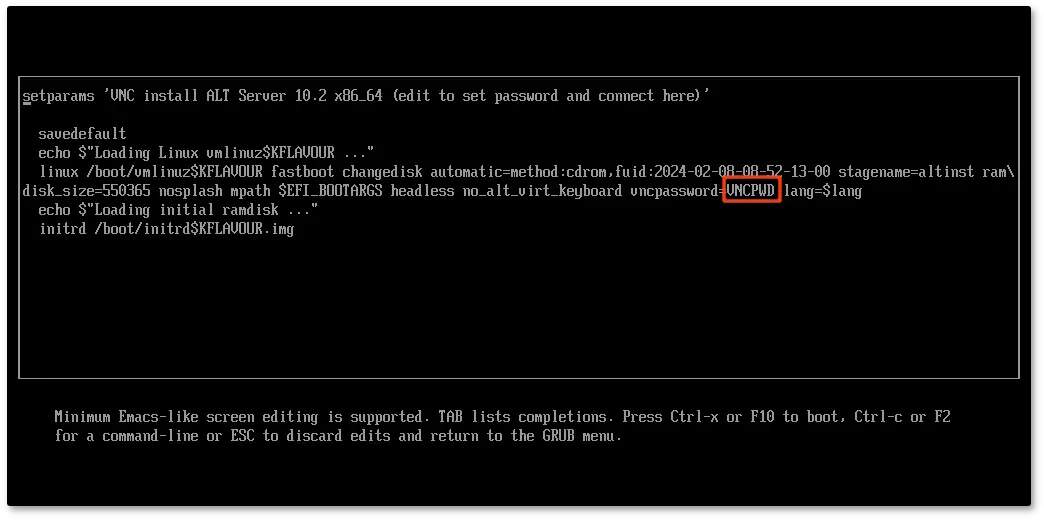

nomodeset — не использовать modeset-драйверы для видеокарты;

vga=normal — отключить графический экран загрузки установщика;

xdriver=vesa — явно использовать видеодрайвер vesa. Данным параметром можно явно указать нужный вариант драйвера;

acpi=off noapic — отключение ACPI (управление питанием), если система не поддерживает ACPI полностью.

apm=off acpi=off mce=off barrier=off vga=normal). В безопасном режиме отключаются все параметры ядра, которые могут вызвать проблемы при загрузке. В этом режиме установка будет произведена без поддержки APIC. Возможно, у вас какое-то новое или нестандартное оборудование, но может оказаться, что оно отлично настраивается со старыми драйверами.

[root@localhost /]#. Начиная с этого момента, система готова к вводу команд.

fixmbr без параметров. Программа попытается переустановить загрузчик в автоматическом режиме.

Важно

/home, то для того, чтобы войти в систему под своим именем пользователя, вам потребуется ввести пароль этого раздела и затем нажать Enter.

Важно

Примечание

Важно

Содержание

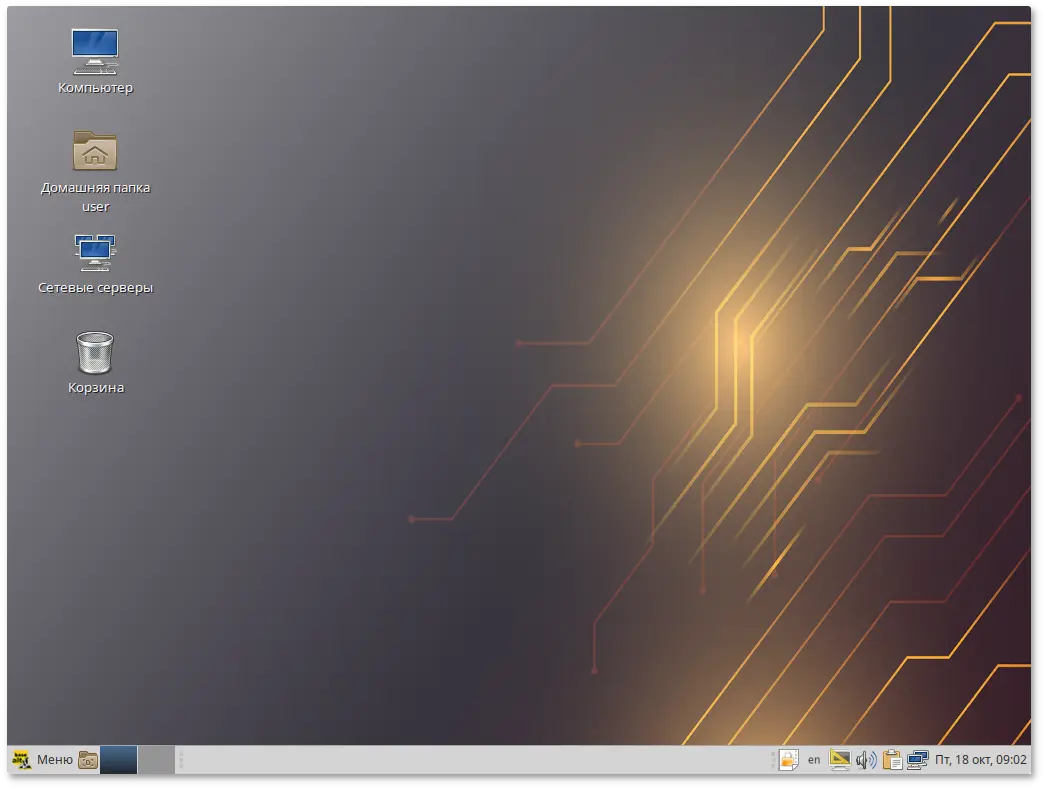

/home/<имя пользователя>. В этой папке по умолчанию хранятся пользовательские файлы (например, аудиозаписи, видеозаписи, документы). Домашняя папка есть у каждого пользователя системы, и по умолчанию содержащиеся в ней файлы недоступны для других пользователей (даже для чтения);

Примечание

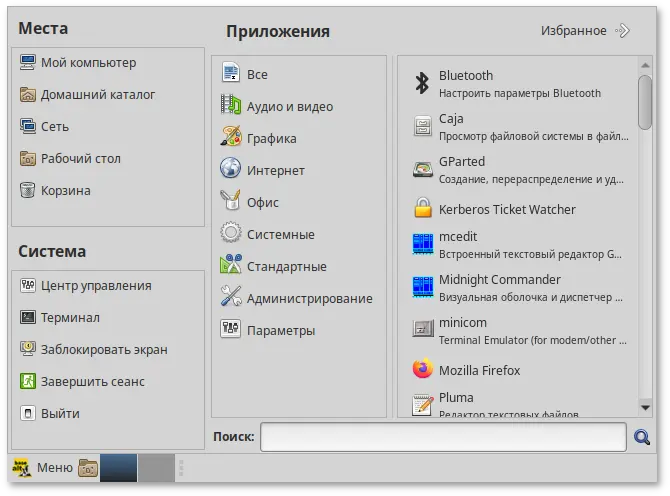

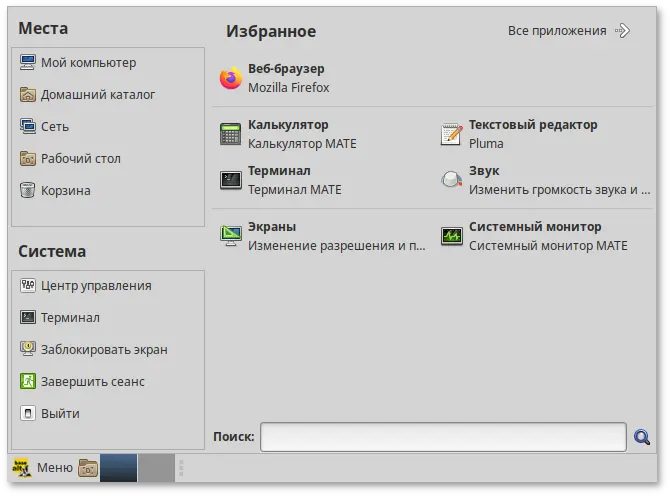

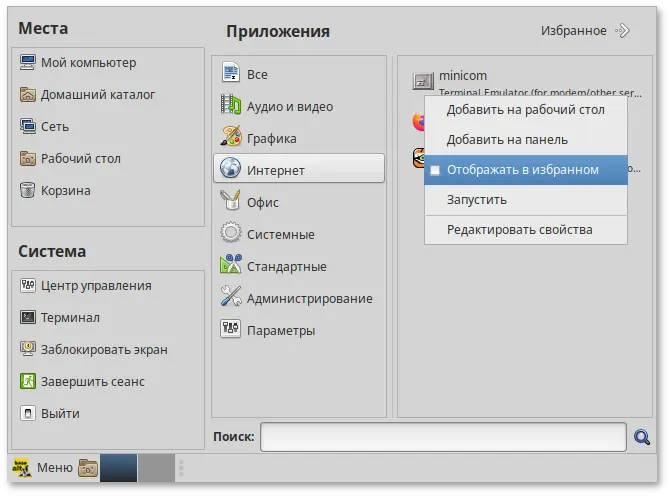

Свернуть все окна — кнопка позволяет свернуть (развернуть) все открытые окна на текущем рабочем месте;

Свернуть все окна — кнопка позволяет свернуть (развернуть) все открытые окна на текущем рабочем месте;

Переключатель рабочих мест — это группа квадратов в правом нижнем углу экрана. Они позволяют вам переключать рабочие места. Каждое рабочее место предоставляет отдельный рабочий стол, на котором можно расположить приложения. По умолчанию активно два рабочих места. Можно изменить это число, нажав правой кнопкой мыши на переключателе рабочих мест и выбрав в контекстном меню пункт .

Переключатель рабочих мест — это группа квадратов в правом нижнем углу экрана. Они позволяют вам переключать рабочие места. Каждое рабочее место предоставляет отдельный рабочий стол, на котором можно расположить приложения. По умолчанию активно два рабочих места. Можно изменить это число, нажав правой кнопкой мыши на переключателе рабочих мест и выбрав в контекстном меню пункт .

Примечание

Примечание

Примечание

Предупреждение

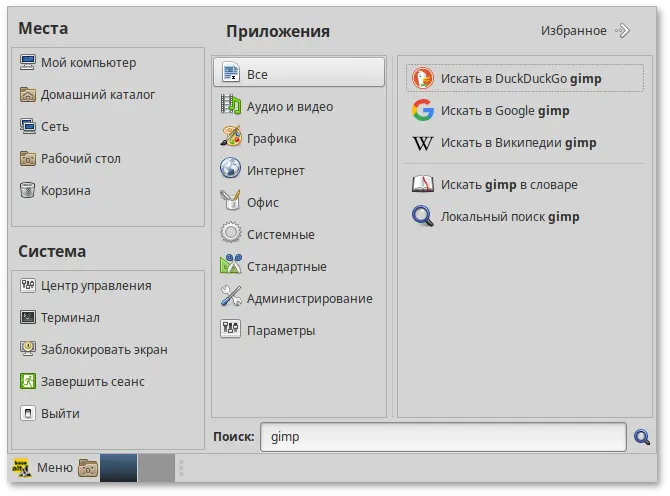

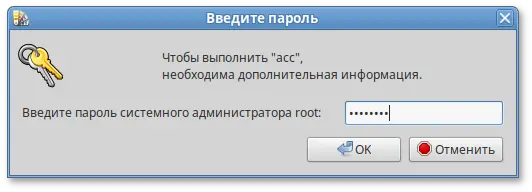

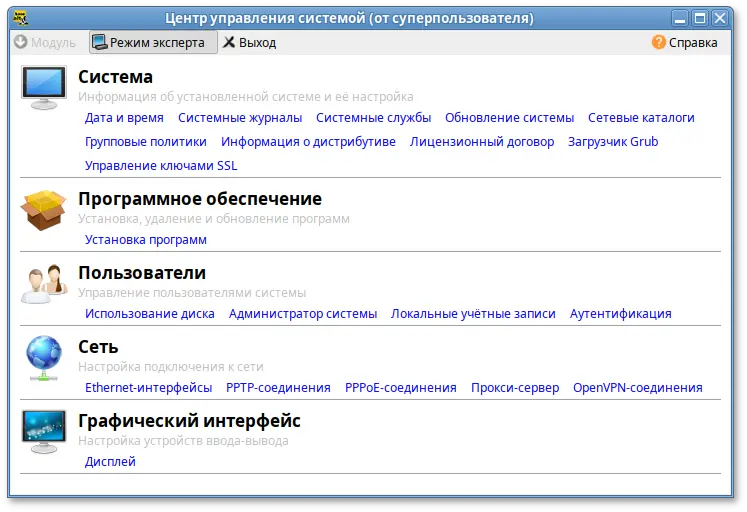

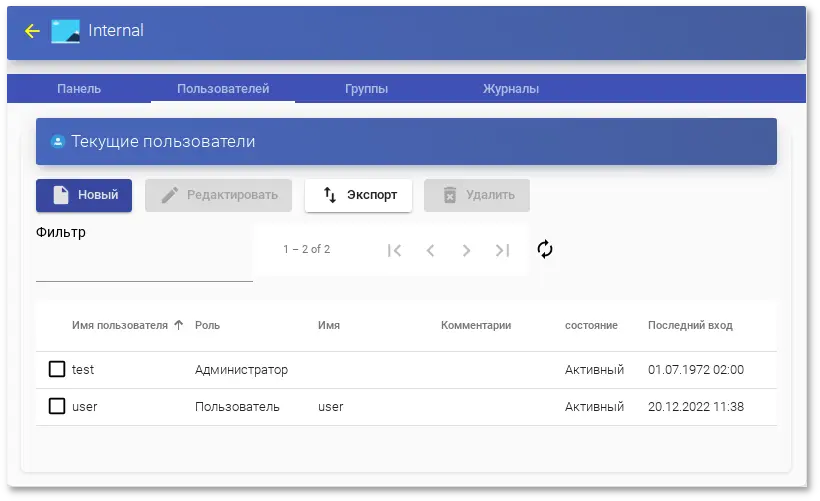

acc.

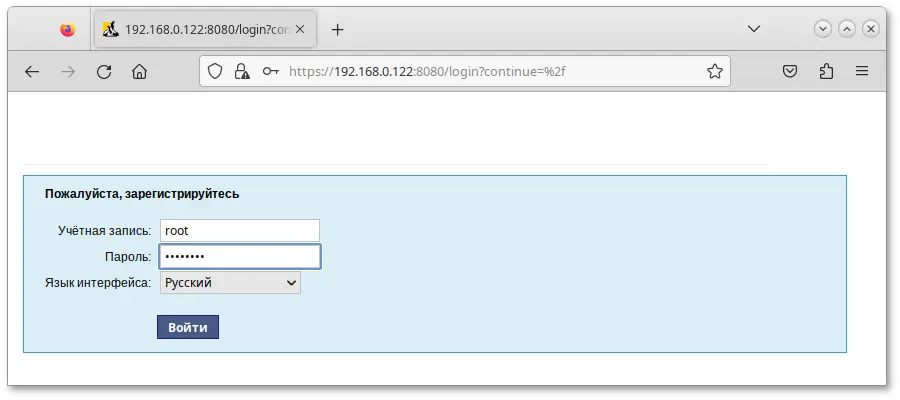

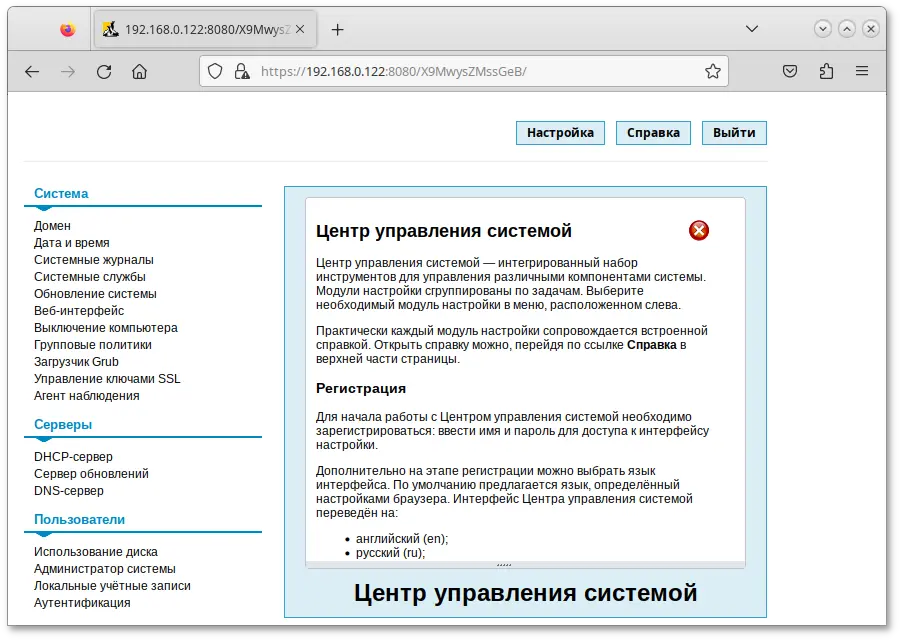

https://ip-адрес:8080/.

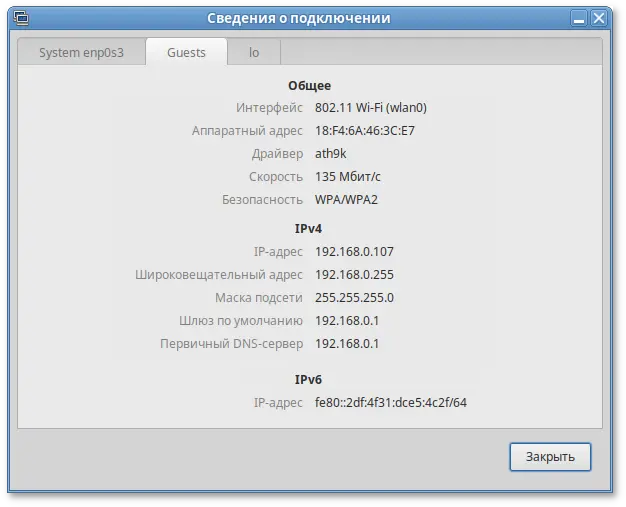

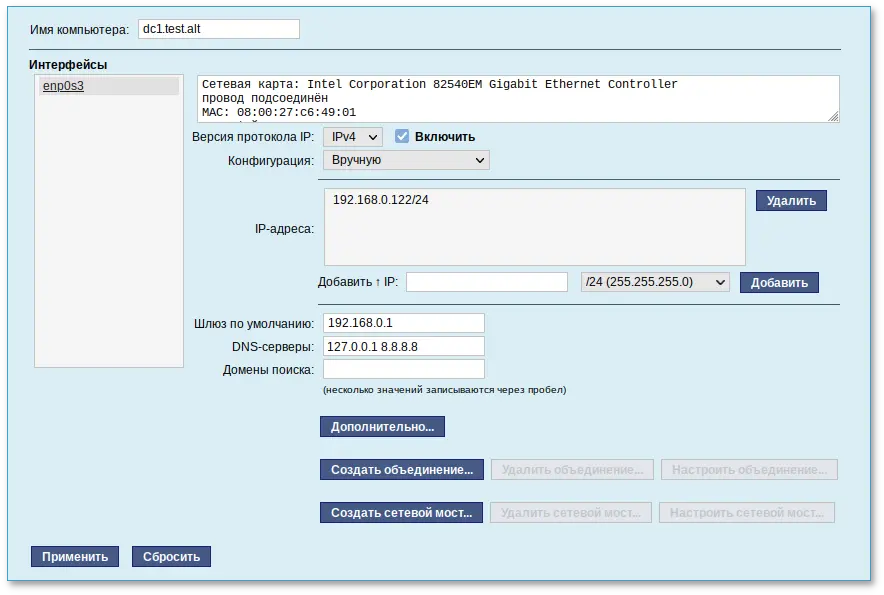

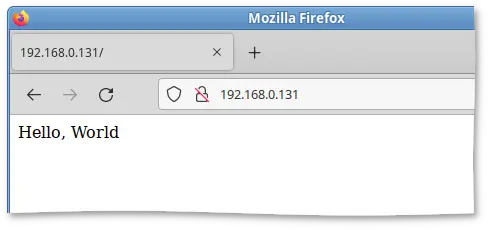

192.168.0.122. В таком случае:

https://192.168.0.122:8080/;

https://192.168.0.122/.

Примечание

$ipaddr

inet:

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 16436 qdisc noqueue state UNKNOWN

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP qlen 1000

link/ether 60:eb:69:6c:ef:47 brd ff:ff:ff:ff:ff:ff

inet 192.168.0.122/24 brd 192.168.0.255 scope global enp0s3

192.168.0.122.

Примечание

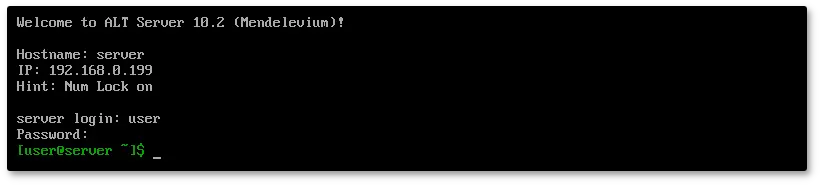

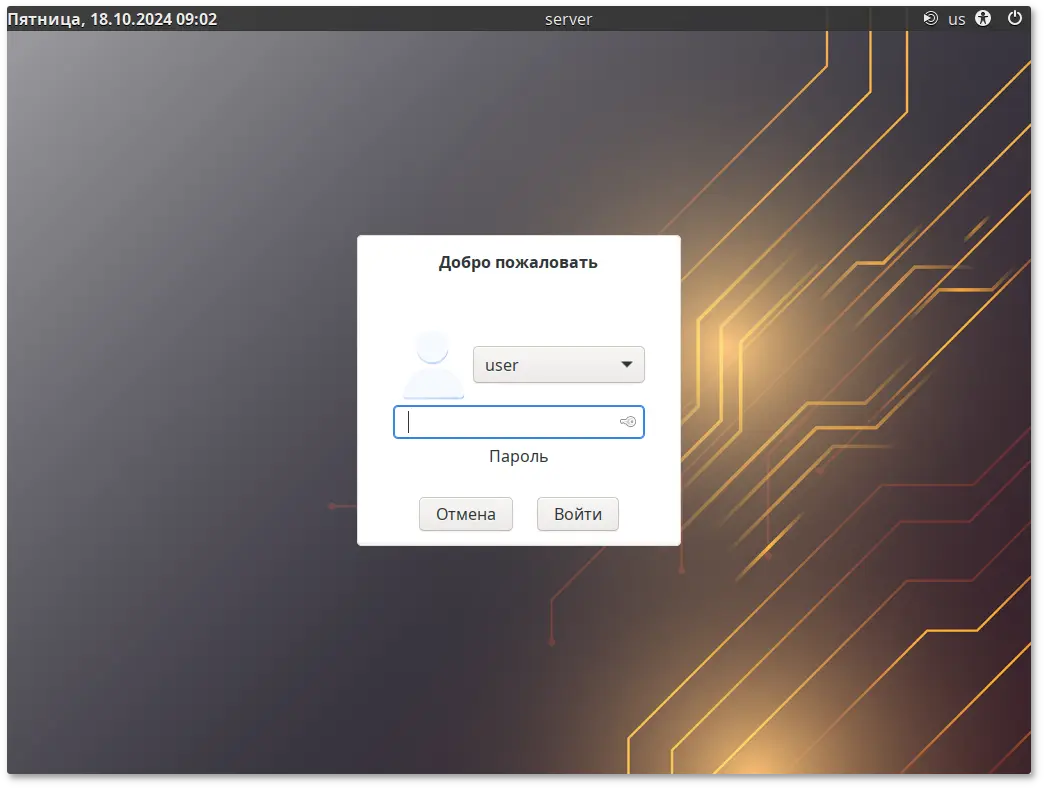

startx, предварительно войдя в консоль сервера, используя имя и пароль созданного при установке непривилегированного пользователя.

Предупреждение

Примечание

Примечание

Примечание

Примечание

Предупреждение

Предупреждение

Важно

Примечание

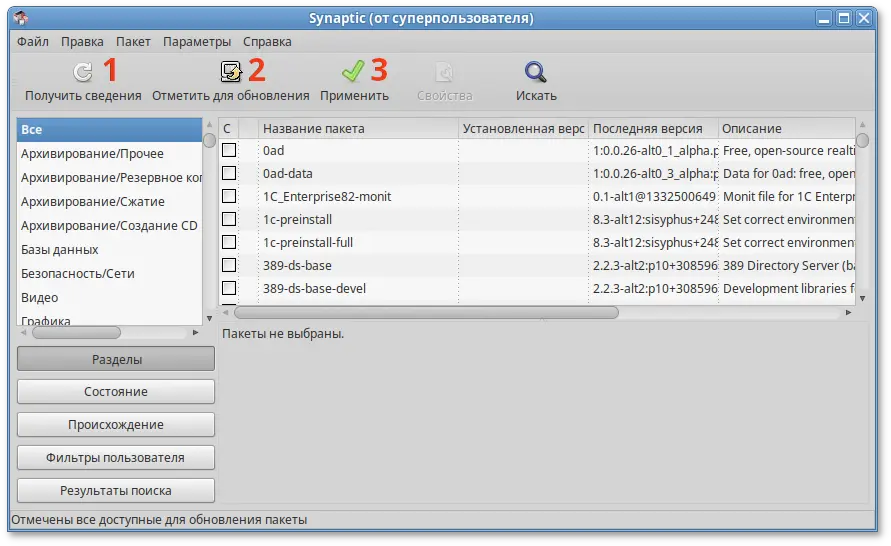

apt-get dist-upgrade.

Важно

Содержание

Примечание

Примечание

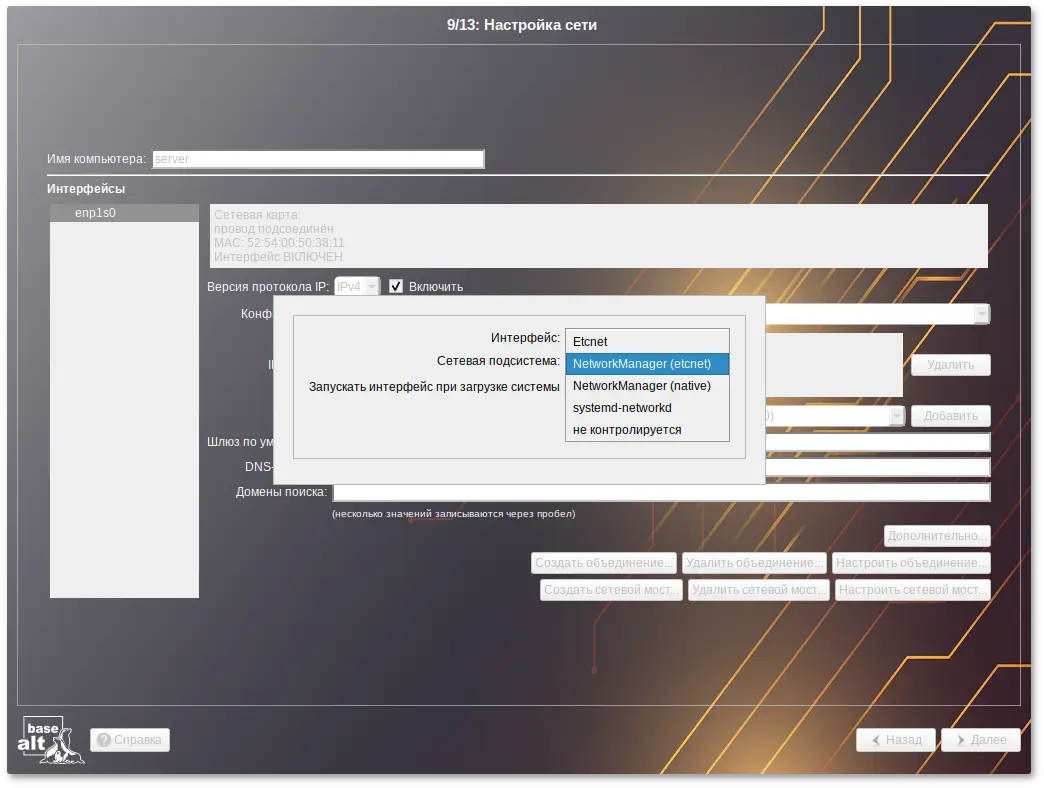

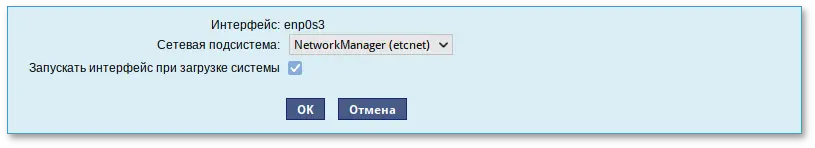

/etc/net/ifaces/<интерфейс>. Настройки сети могут изменяться либо в ЦУС в данном модуле, либо напрямую через редактирование файлов /etc/net/ifaces/<интерфейс>.

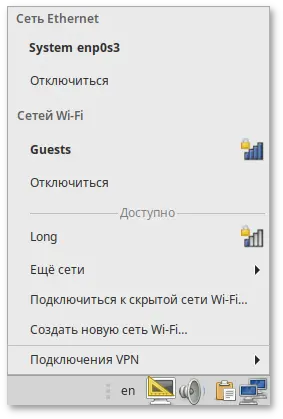

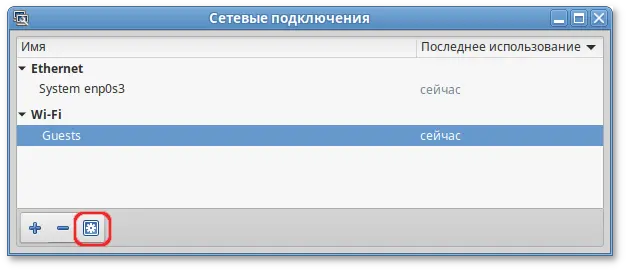

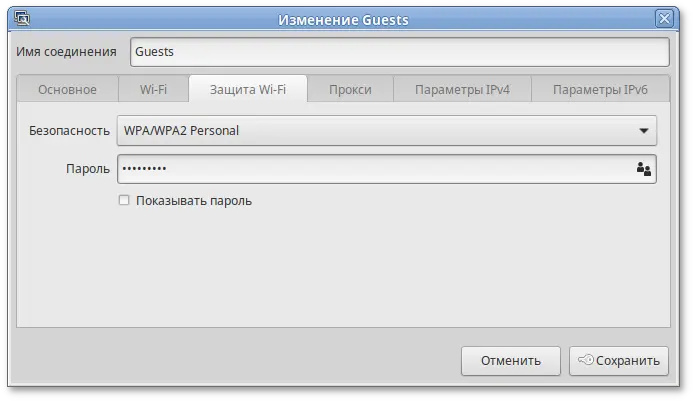

/etc/net/ifaces/<интерфейс>. В этом режиме можно просмотреть настройки сети, например, полученный по DHCP IP-адрес, через графический интерфейс NetworkManager.

/etc/NetworkManager/system-connections. Этот режим особенно актуален для задач настройки сети на клиенте, когда IP-адрес необходимо получать динамически с помощью DHCP, а DNS-сервер указать явно. Через ЦУС так настроить невозможно, так как при включении DHCP отключаются настройки, которые можно задавать вручную.

/etc/systemd/network/<имя_файла>.network, /etc/systemd/network/<имя_файла>.netdev, /etc/systemd/network/<имя_файла>.link. Данный режим доступен, если установлен пакет systemd-networkd;

Примечание

# systemctl disable --now network && systemctl enable --now systemd-networkd

И, наоборот, при смене с systemd-networkd на Etcnet отключить службу systemd-networkd и включить network:

# systemctl disable --now systemd-networkd && systemctl enable --now network

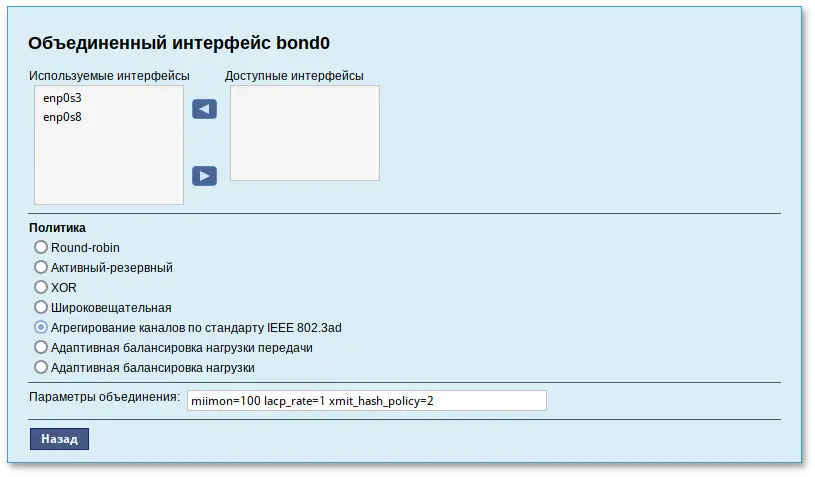

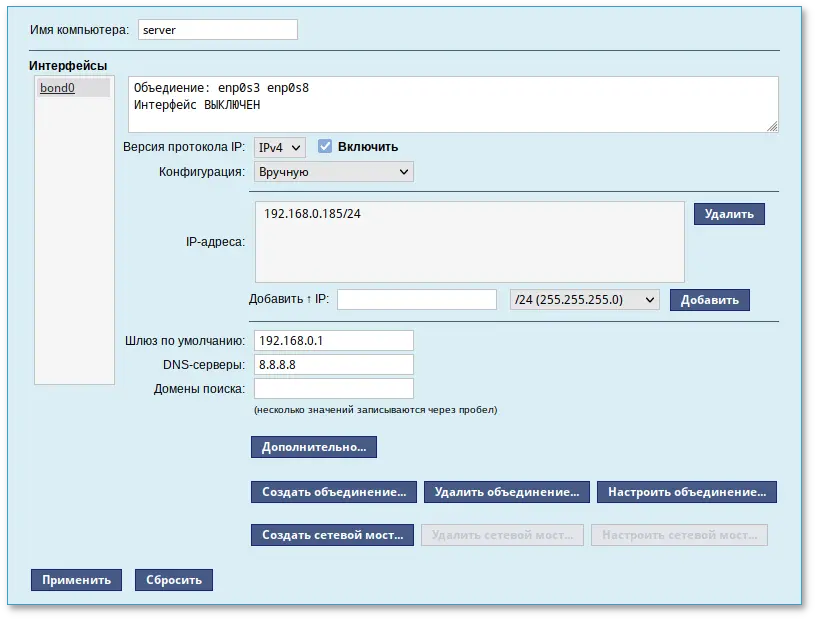

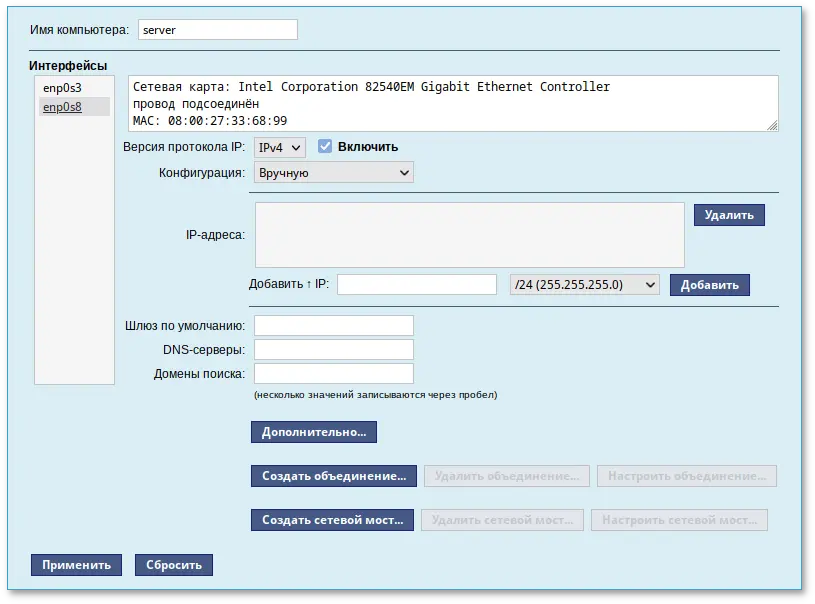

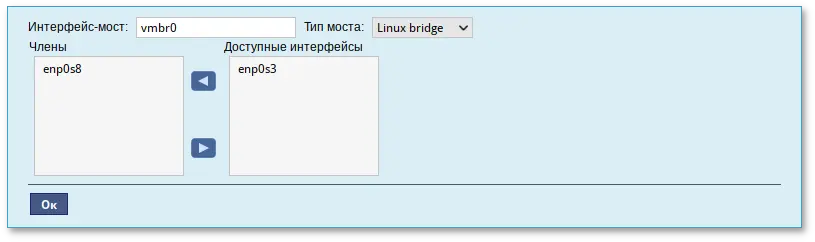

/proc/net/bonding/bond0.

Предупреждение

Примечание

Примечание

Примечание

/var/lib/tftpboot должен быть доступен клиенту через TFTP, каталог /srv/public/netinst должен быть доступен клиенту через NFS.

Примечание

/tmp/alt-workstation-10.2-x86_64.iso). Можно также использовать URL вида http://ftp.altlinux.org/pub/distributions/ALTLinux/images/p10/workstation/x86_64/alt-workstation-10.2-x86_64.iso.

Примечание

Примечание

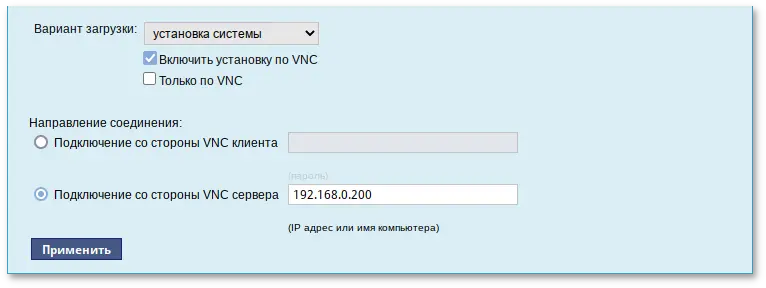

/var/lib/tftpboot/pxelinux.cfg/default следует дописать параметр загрузки ai (без значения) и параметр curl с указанием каталога с установочными файлами, например:

label linux kernel syslinux//boot/vmlinuz append initrd=syslinux//boot/initrd.img fastboot changedisk stagename=altinst ramdisk_size=648701 showopts vga=normal quiet splash automatic=method:nfs,network:dhcp tz=Europe/Kaliningrad lang=ru_RU vnc vncpassword=123 ai curl=ftp://192.168.0.186/metadata/

vncviewer -listen.

Предупреждение

Примечание

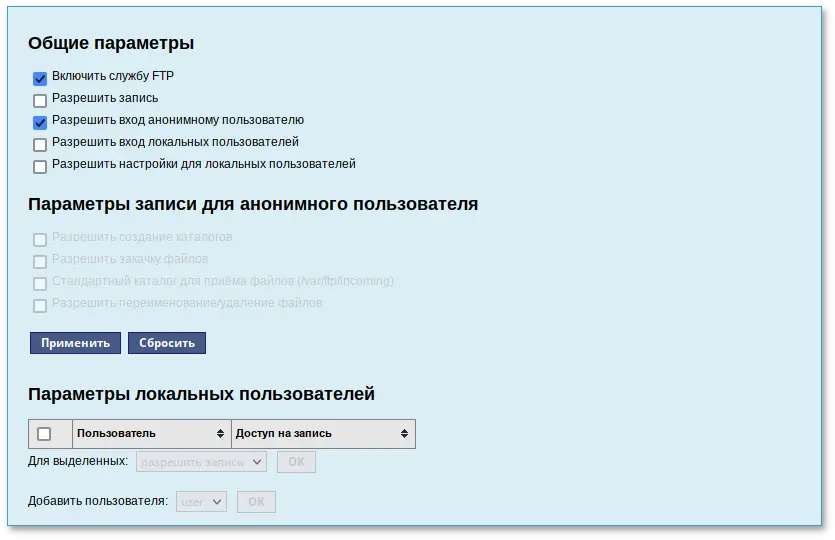

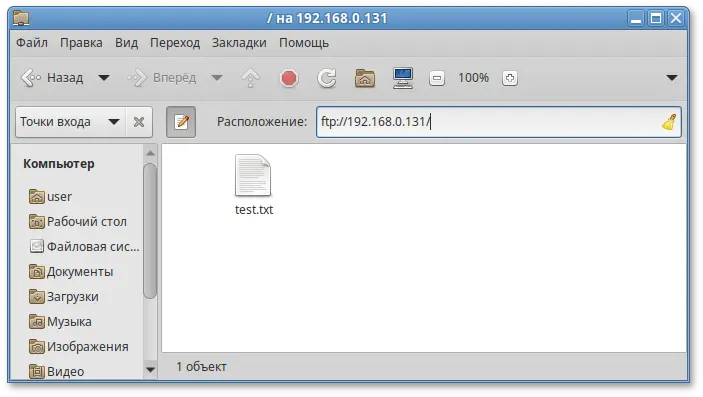

/var/ftp с необходимыми правами доступа. Владельцем этого каталога является пользователь root, а не псевдопользователь, от имени которого работает vsftpd. Это сделано для обеспечения безопасности FTP-сервера и системы в целом. Группой-владельцем каталога является специальная группа ftpadmin, предназначенная для администраторов FTP-сервера.

Примечание

Примечание

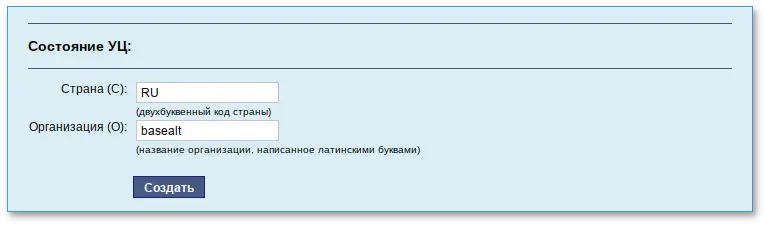

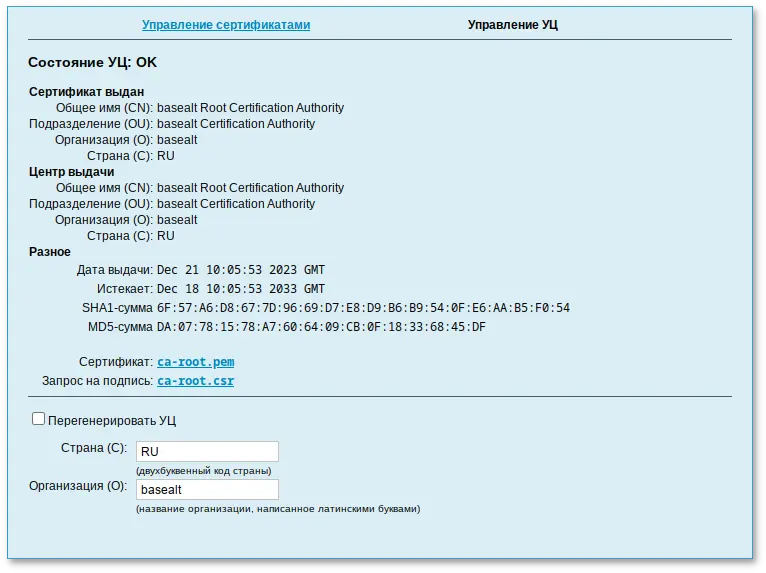

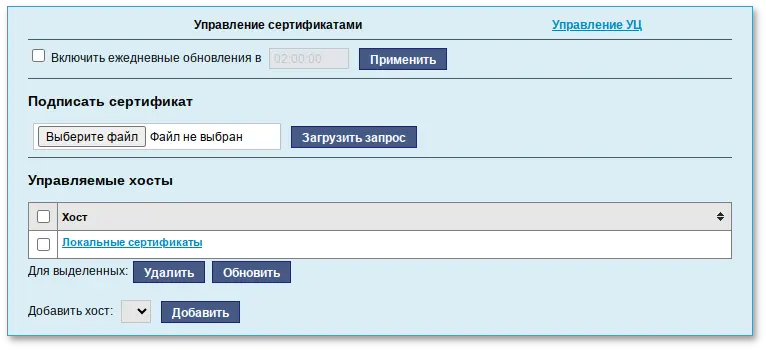

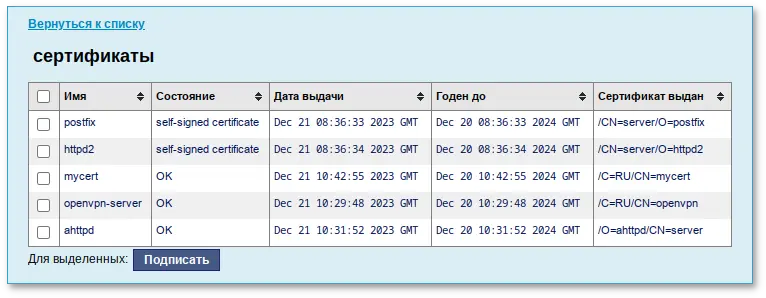

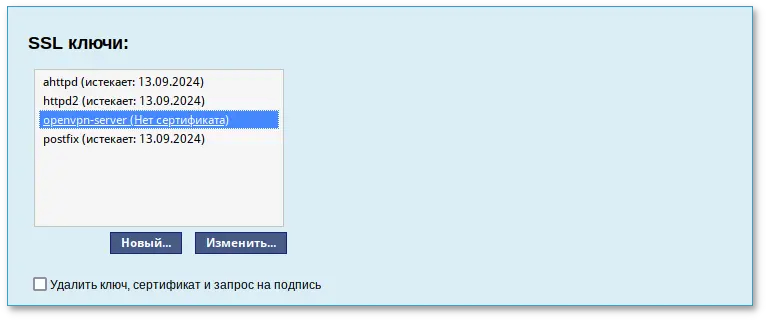

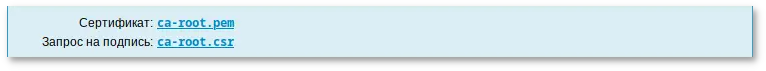

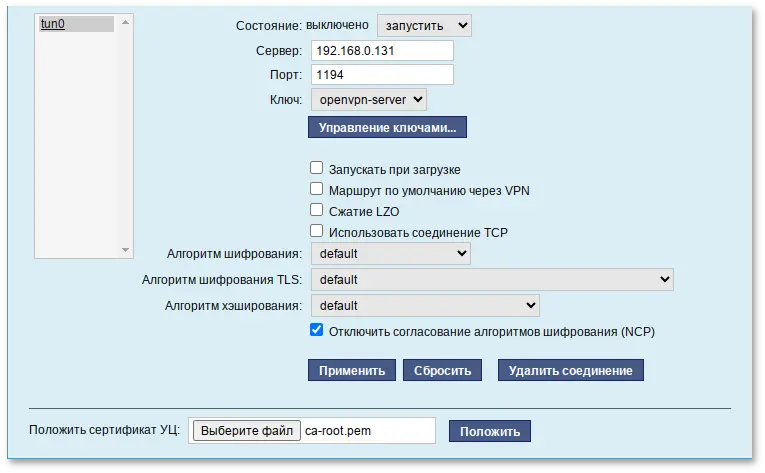

ca-root.pem). Этот файл можно будет добавить к списку УЦ, используемому клиентским ПО, после чего все сертификаты, подписанные данным УЦ будут приниматься автоматически;

ca-root.csr). Этот запрос можно подписать сторонним УЦ;

output.pem) будет загружен в каталог загрузок.

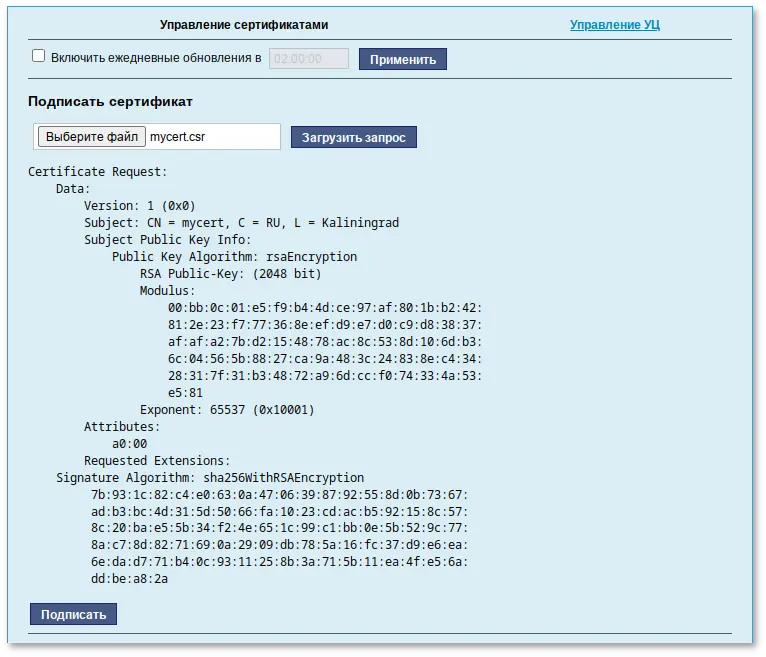

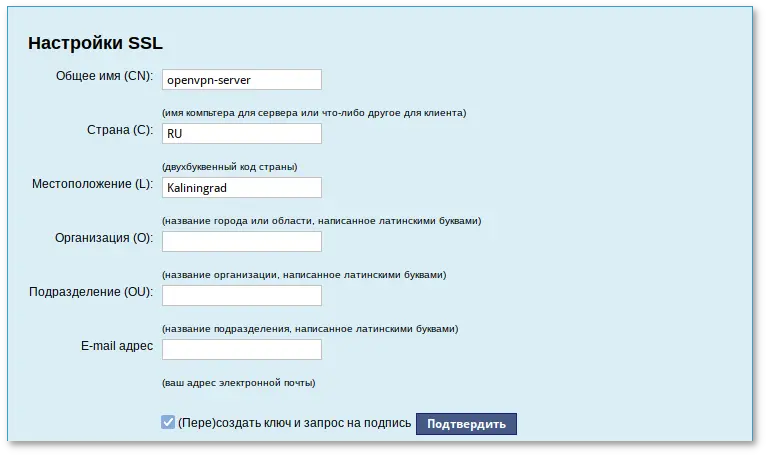

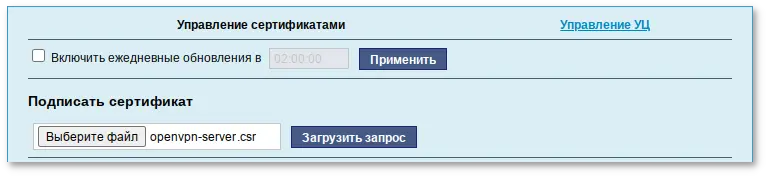

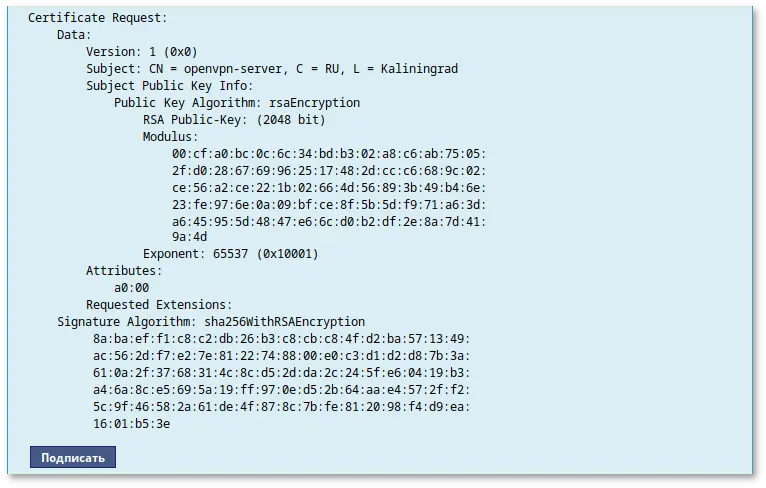

openvpn-server.csr. Необходимо сохранить этот файл на диске.

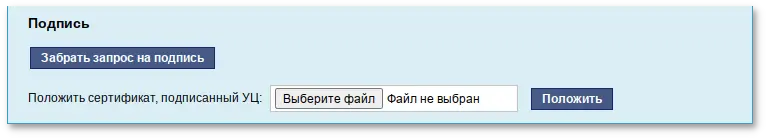

openvpn-server.csr и загрузить запрос:

output.pem (подписанный сертификат).

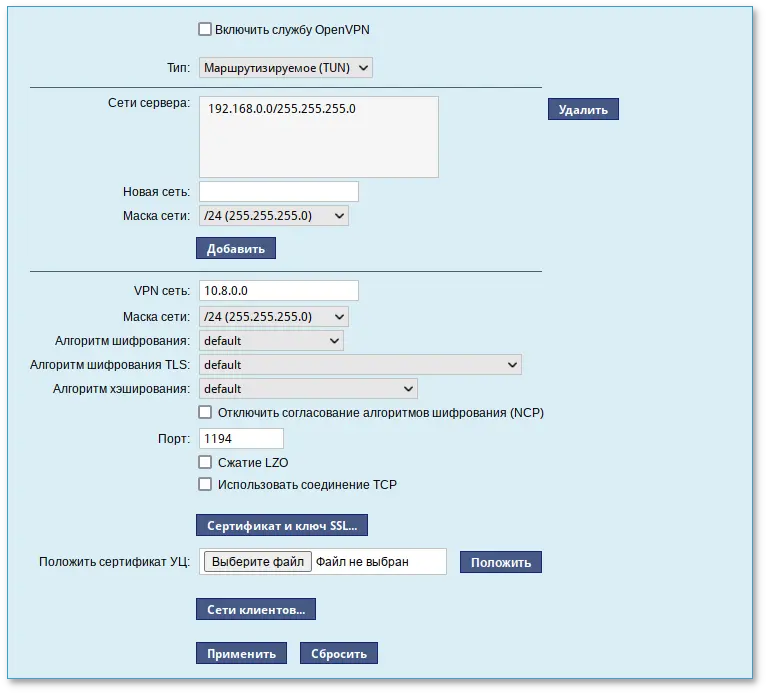

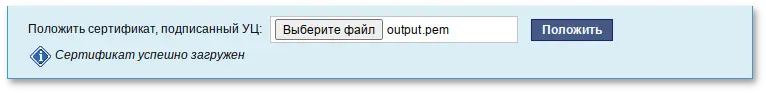

output.pem и нажать кнопку :

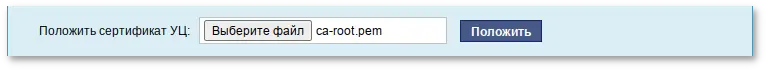

ca-root.pem и нажать кнопку :

$ ip addr

должно появиться новое соединение tun0. При обычных настройках это может выглядеть так:

tun0: <POINTOPOINT,MULTICAST,NOARP,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UNKNOWN group default qlen 500 link/none inet 10.8.0.6 peer 10.8.0.5/32 scope global tun0

Примечание

Примечание

Примечание

Примечание

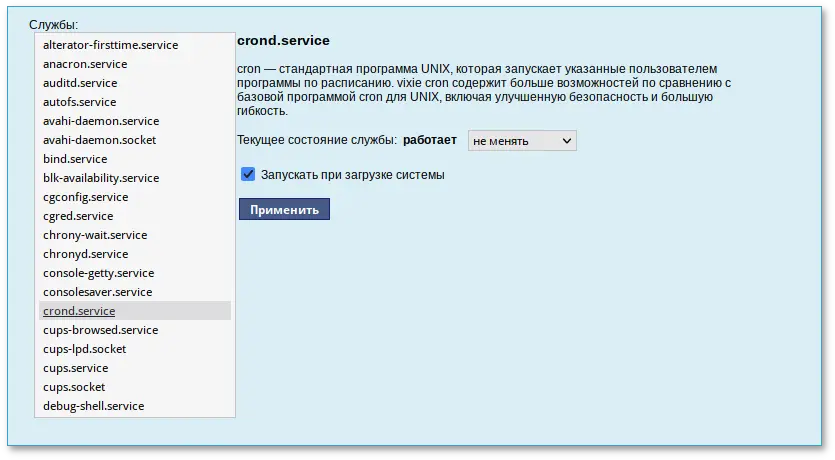

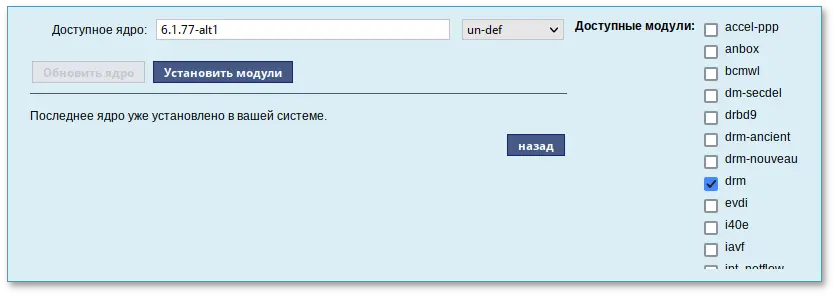

update-kernel. Данный модуль предоставляет возможность:

Примечание

Примечание

Примечание

Важно

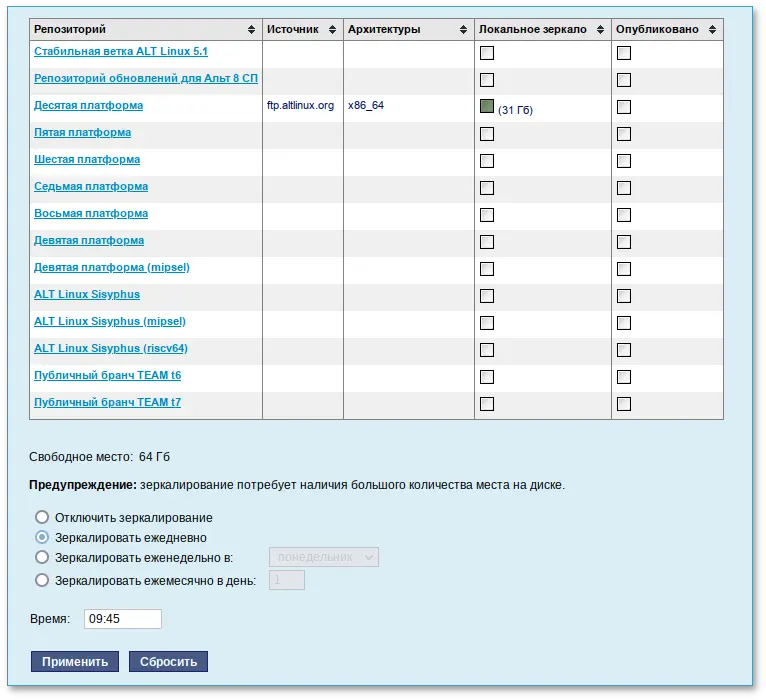

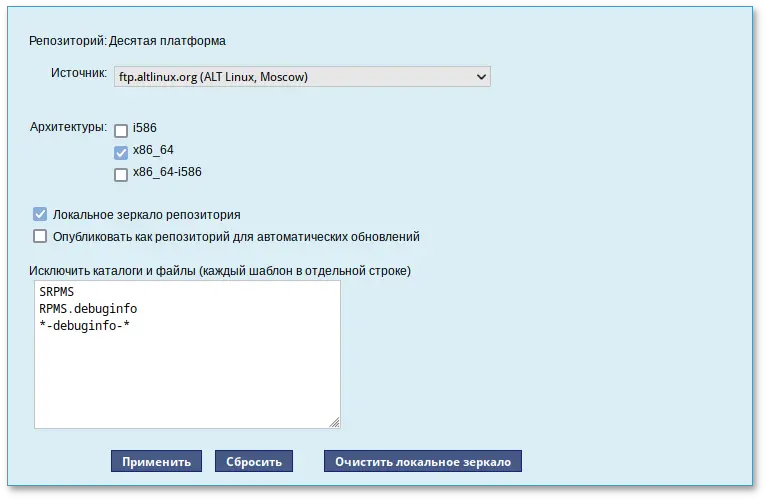

SRPMS *-debuginfo-*Шаблоны указываются по одному в отдельной строке. Символ «*» используется для подстановки любого количества символов.

Примечание

/srv/public/mirror. Для того чтобы зеркалирование происходило в другую папку, необходимо эту папку примонтировать в папку /srv/public/mirror. Для этого в файл /etc/fstab следует вписать строку:

/media/disk/localrepo /srv/public/mirror none rw,bind,auto 0 0где

/media/disk/localrepo — папка-хранилище локального репозитория.

Примечание

/srv/public/mirror/<репозиторий>/branch/<архитектура>/base/. нет файлов pkglist.* значит зеркалирование не закончено (т.е. не все файлы загружены на ваш сервер).

# apt-get install nginx

/etc/nginx/sites-available.d/repo.conf:

server {

listen 80;

server_name localhost .local <ваш ip>;

access_log /var/log/nginx/repo-access.log;

error_log /var/log/nginx/repo-error.log;

location /mirror {

root /srv/public;

autoindex on;

}

}

/etc/nginx/sites-enabled.d/:

# ln -s /etc/nginx/sites-available.d/repo.conf /etc/nginx/sites-enabled.d/repo.conf

# systemctl enable --now nginx

#Проверить правильность настройки репозиториев:apt-repo rm all#apt-repo add http://<ip сервера>/mirror/p10/branch

# apt-repo

rpm http://192.168.0.185/mirror p10/branch/x86_64 classic

rpm http://192.168.0.185/mirror p10/branch/noarch classic

# apt-get install vsftpd lftp

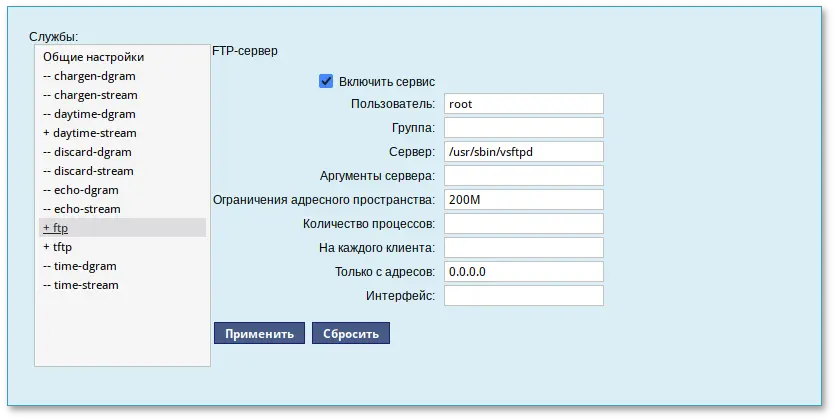

/etc/xinetd.d/vsftpd:

# default: off

# description: The vsftpd FTP server.

service ftp

{

disable = no # включает службу

socket_type = stream

protocol = tcp

wait = no

user = root

nice = 10

rlimit_as = 200M

server = /usr/sbin/vsftpd

only_from = 0.0.0.0 # предоставить доступ для всех IP

}

# systemctl restart xinetd

/etc/vsftpd/conf:

local_enable=YES

/var/ftp/mirror:

# mkdir -p /var/ftp/mirror

Примонтировать каталог /srv/public/mirror в /var/ftp/mirror с опцией --bind:

# mount --bind /srv/public/mirror /var/ftp/mirror

Примечание

/srv/public/mirror при загрузке системы необходимо добавить следующую строку в файл /etc/fstab:

/srv/public/mirror /var/ftp/mirror none defaults,bind 0 0

#apt-repo rm all#apt-repo add ftp://<ip сервера>/mirror/p10/branch#apt-reporpm ftp://192.168.0.185/mirror p10/branch/x86_64 classic rpm ftp://192.168.0.185/mirror p10/branch/noarch classic

Примечание

Примечание

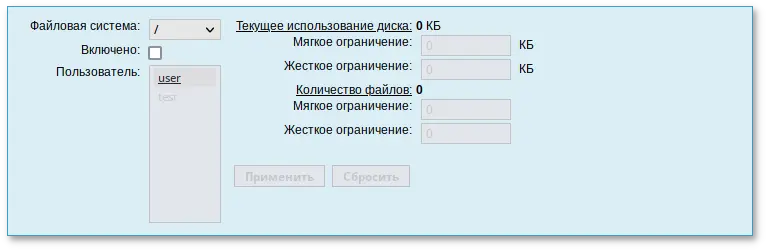

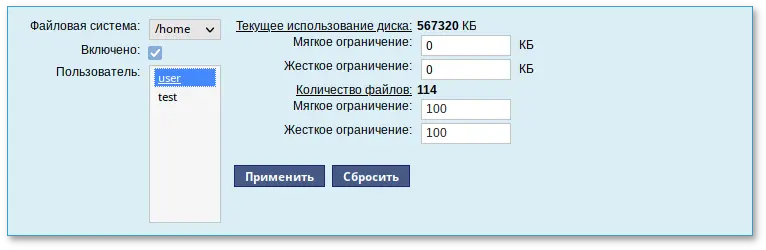

usrquota, grpquota. Для этого следует выбрать нужный раздел в списке Файловая система и установить отметку в поле Включено:

Примечание

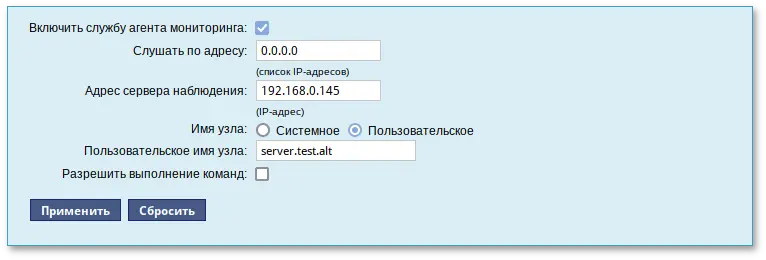

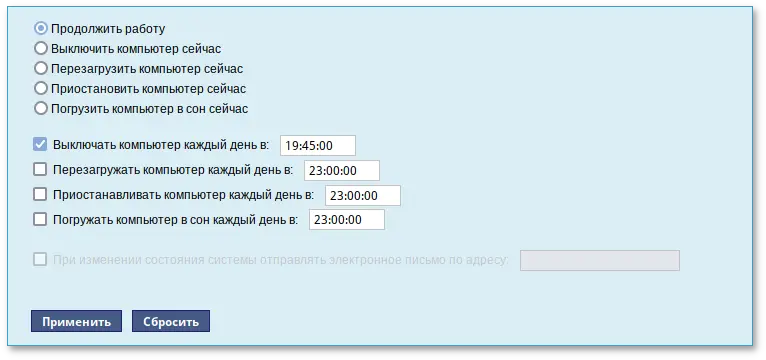

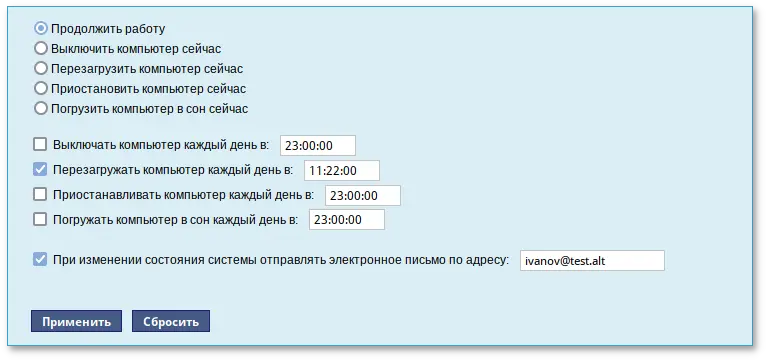

# apt-get install state-change-notify-postfix

Thu Sep 14 11:46:59 EET 2023: The server.test.alt is about to start.При выключении:

Thu Sep 14 12:27:02 EET 2023: The server.test.alt is about to shutdown.

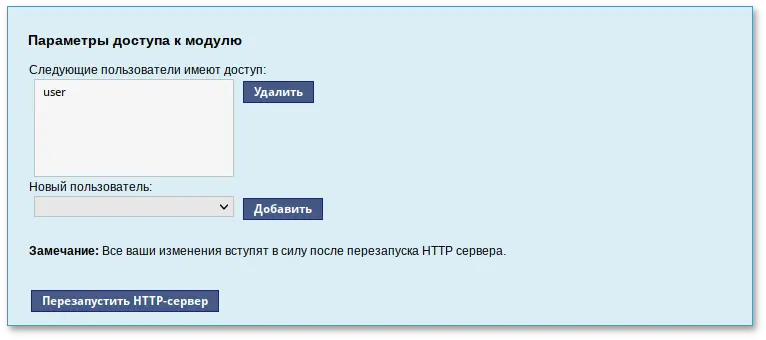

rpm -qa | grep alterator*

Прочие пакеты для ЦУС можно найти, выполнив команду:

apt-cache search alterator*

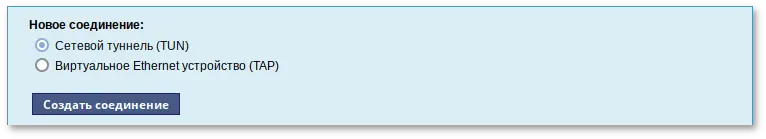

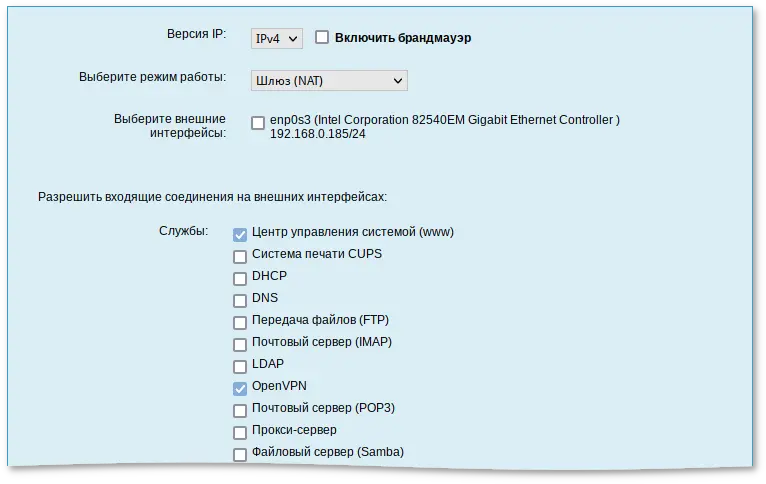

#apt-get install alterator-net-openvpn#apt-get remove alterator-net-openvpn

# systemctl restart ahttpd

Содержание

Предупреждение

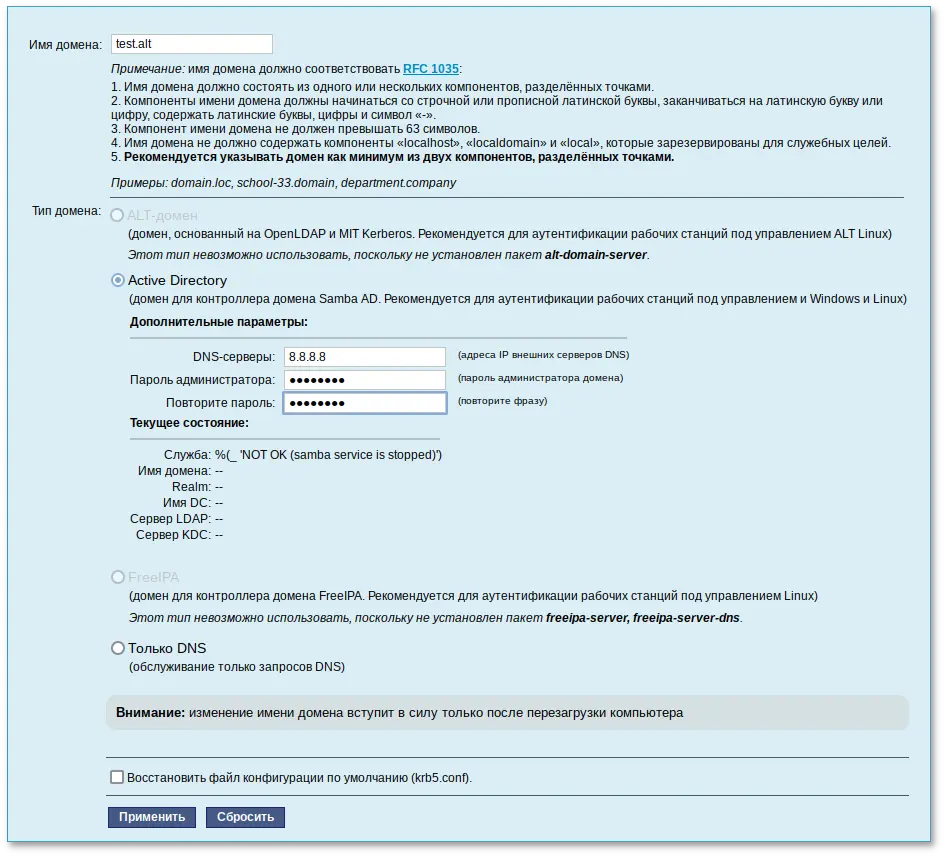

# apt-get install task-samba-dc

# for service in smb nmb krb5kdc slapd bind; do systemctl disable $service; systemctl stop $service; done

#rm -f /etc/samba/smb.conf#rm -rf /var/lib/samba#rm -rf /var/cache/samba#mkdir -p /var/lib/samba/sysvol

Предупреждение

/etc/samba/smb.conf перед созданием домена: rm -f /etc/samba/smb.conf

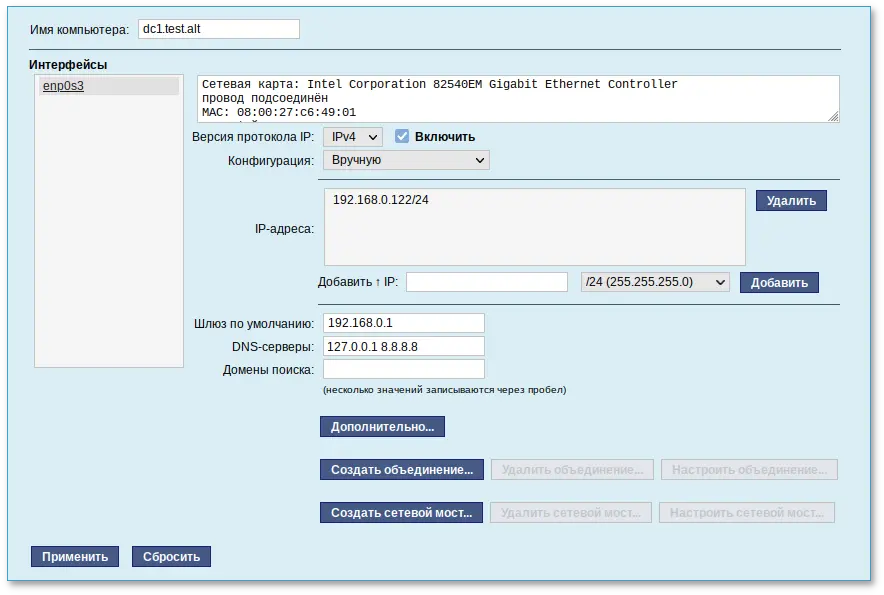

/etc/sysconfig/network

# hostnamectl set-hostname dc1.test.alt

# domainname test.alt

Примечание

Предупреждение

Примечание

# samba-tool domain provision --realm=test.alt --domain=test --adminpass='Pa$$word' --dns-backend=SAMBA_INTERNAL --option="dns forwarder=8.8.8.8" --server-role=dc

где

Примечание

--use-rfc2307 позволяет поддерживать расширенные атрибуты типа UID и GID в схеме LDAP и ACL на файловой системе Linux.

# samba-tool domain provision --realm=test.alt --domain=test --adminpass='Pa$$word' --dns-backend=SAMBA_INTERNAL --option="dns forwarder=8.8.8.8" --option="ad dc functional level = 2016" --server-role=dc --function-level=2016

Примечание

Примечание

# samba-tool domain provision

Realm [TEST.ALT]:

Domain [TEST]:

Server Role (dc, member, standalone) [dc]:

DNS backend (SAMBA_INTERNAL, BIND9_FLATFILE, BIND9_DLZ, NONE) [SAMBA_INTERNAL]:

DNS forwarder IP address (write 'none' to disable forwarding) [127.0.0.1]: 8.8.8.8

Administrator password:

Retype password:

Looking up IPv4 addresses

More than one IPv4 address found. Using 192.168.0.122

Looking up IPv6 addresses

No IPv6 address will be assigned

Setting up share.ldb

Setting up secrets.ldb

Setting up the registry

Setting up the privileges database

Setting up idmap db

Setting up SAM db

Setting up sam.ldb partitions and settings

Setting up sam.ldb rootDSE

Pre-loading the Samba 4 and AD schema

Adding DomainDN: DC=test,DC=alt

Adding configuration container

Setting up sam.ldb schema

Setting up sam.ldb configuration data

Setting up display specifiers

Modifying display specifiers

Adding users container

Modifying users container

Adding computers container

Modifying computers container

Setting up sam.ldb data

Setting up well known security principals

Setting up sam.ldb users and groups

Setting up self join

Adding DNS accounts

Creating CN=MicrosoftDNS,CN=System,DC=test,DC=alt

Creating DomainDnsZones and ForestDnsZones partitions

Populating DomainDnsZones and ForestDnsZones partitions

Setting up sam.ldb rootDSE marking as synchronized

Fixing provision GUIDs

A Kerberos configuration suitable for Samba 4 has been generated at /var/lib/samba/private/krb5.conf

Merge the contents of this file with your system krb5.conf or replace it with this one. Do not create a symlink!

Once the above files are installed, your Samba4 server will be ready to use

Server Role: active directory domain controller

Hostname: dc1

NetBIOS Domain: TEST

DNS Domain: test.alt

DOMAIN SID: S-1-5-21-80639820-2350372464-3293631772

Примечание

/etc/resolvconf.conf добавить строку:

name_servers=127.0.0.1Обновить DNS адреса:

# resolvconf -u

# systemctl enable --now samba

/etc/krb5.conf. Следует раскомментировать строку default_realm и содержимое разделов realms и domain_realm и указать название домена (обратите внимание на регистр символов), в строке dns_lookup_realm должно быть установлено значение false:

includedir /etc/krb5.conf.d/

[logging]

# default = FILE:/var/log/krb5libs.log

# kdc = FILE:/var/log/krb5kdc.log

# admin_server = FILE:/var/log/kadmind.log

[libdefaults]

dns_lookup_kdc = true

dns_lookup_realm = false

ticket_lifetime = 24h

renew_lifetime = 7d

forwardable = true

rdns = false

default_realm = TEST.ALT

# default_ccache_name = KEYRING:persistent:%{uid}

[realms]

TEST.ALT = {

default_domain = test.alt

}

[domain_realm]

dc1 = TEST.ALT

Примечание

krb5.conf для домена в каталоге /var/lib/samba/private/. Можно просто заменить этим файлом файл, находящийся в каталоге /etc/:

# cp /var/lib/samba/private/krb5.conf /etc/krb5.conf

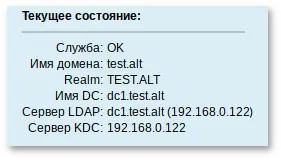

# samba-tool domain info 127.0.0.1

Forest : test.alt

Domain : test.alt

Netbios domain : TEST

DC name : dc1.test.alt

DC netbios name : DC

Server site : Default-First-Site-Name

Client site : Default-First-Site-Name

# smbclient -L localhost -Uadministrator

Password for [TEST\administrator]:

Sharename Type Comment

--------- ---- -------

sysvol Disk

netlogon Disk

IPC$ IPC IPC Service (Samba 4.19.7-alt4)

SMB1 disabled -- no workgroup available

Общие ресурсы netlogon и sysvol создаваемые по умолчанию нужны для функционирования сервера AD и создаются в smb.conf в процессе развертывания/модернизации.

/etc/resolv.conf:

#cat /etc/resolv.conf# Generated by resolvconf # Do not edit manually, use # /etc/net/ifaces/<interface>/resolv.conf instead. search test.alt nameserver 127.0.0.1 #host test.alttest.alt has address 192.168.0.122

#Если имена не находятся, проверьте выключение службы named.host -t SRV _kerberos._udp.test.alt._kerberos._udp.test.alt has SRV record 0 100 88 dc1.test.alt. #host -t SRV _ldap._tcp.test.alt._ldap._tcp.test.alt has SRV record 0 100 389 dc1.test.alt. #host -t A dc1.test.alt.dc1.test.alt has address 192.168.0.122

# kinit administrator@TEST.ALT

Password for administrator@TEST.ALT:

Просмотр полученного билета:

# klist

Ticket cache: FILE:/tmp/krb5cc_0

Default principal: administrator@TEST.ALT

Valid starting Expires Service principal

18.10.2024 11:23:18 18.10.2024 21:23:14 krbtgt/TEST.ALT@TEST.ALT

renew until 25.10.2024 11:23:10

ad dc functional level файла /etc/samba/smb.conf. Возможные значения: 2008_R2, 2012, 2012_R2, 2016.

# samba-tool domain schemaupgrade --schema=<SCHEMA>

где SCHEMA — схема, до которой необходимо выполнить обновление (по умолчанию 2019).

# samba-tool domain functionalprep --function-level=<FUNCTION_LEVEL>

где FUNCTION_LEVEL — функциональный уровень, к которому нужно подготовиться (по умолчанию 2016).

# samba-tool domain level raise --domain-level=<DOMAIN_LEVEL> --forest-level=<FOREST_LEVEL>

где:

Примечание

ad dc functional level в файле /etc/samba/smb.conf вручную, защита от несовпадения функций между контроллерами домена снижается. Поэтому на всех контроллерах домена должна использоваться одна и та же версия Samba, чтобы гарантировать, что поведение, наблюдаемое клиентом, будет одинаковым независимо от того, к какому контроллеру домена осуществляется соединение.

/etc/samba/smb.conf добавить строку:

ad dc functional level = 2016

# systemctl restart samba.service

# samba-tool domain schemaupgrade --schema=2019

# samba-tool domain functionalprep --function-level=2016

# samba-tool domain level raise --domain-level=2016 --forest-level=2016

Domain function level changed!

Forest function level changed!

All changes applied successfully!

# samba-tool domain level show

Domain and forest function level for domain 'DC=test,DC=alt'

Forest function level: (Windows) 2016

Domain function level: (Windows) 2016

Lowest function level of a DC: (Windows) 2016

samba-tool user create имя пользователяsamba-tool user setexpiry имя пользователя

samba-tool user delete имя пользователяsamba-tool user disable имя пользователяsamba-tool user enable имя пользователяsamba-tool user setpassword имя пользователя# samba-tool user list

#samba-tool user create ivanov --given-name='Иван Иванов' --mail-address='ivanov@test.alt'#samba-tool user setexpiry ivanov --noexpiry

Предупреждение

pdbedit -x -m имя

# apt-get install task-samba-dc

# for service in smb nmb krb5kdc slapd bind; do systemctl disable $service; systemctl stop $service; done

#rm -f /etc/samba/smb.conf#rm -rf /var/lib/samba#rm -rf /var/cache/samba#mkdir -p /var/lib/samba/sysvol

# systemctl status bind

И, если она была включена, выключить службу bind и перезапустить службу samba:

#systemctl stop bind#systemctl restart samba

Предупреждение

# samba-tool dns add 192.168.0.122 test.alt DC2 A 192.168.0.106 -Uadministrator

Password for [TEST\administrator]:

Record added successfully

/etc/krb5.conf):

[libdefaults] default_realm = TEST.ALT dns_lookup_realm = false dns_lookup_kdc = true

Примечание

/etc/resolv.conf обязательно должен быть добавлен PDC как nameserver:

#echo "name_servers=192.168.0.122" >> /etc/resolvconf.conf#echo "search_domains=test.alt" >> /etc/resolvconf.conf#resolvconf -u#cat /etc/resolv.confsearch test.alt nameserver 192.168.0.122 nameserver 8.8.8.8

# kinit administrator@TEST.ALT

Password for administrator@TEST.ALT:

Предупреждение

# klist

Ticket cache: KEYRING:persistent:0:0

Default principal: administrator@TEST.ALT

Valid starting Expires Service principal

18.10.2024 11:28:35 18.10.2024 21:28:35 krbtgt/TEST.ALT@TEST.ALT

renew until 25.10.2024 11:28:32

# samba-tool domain join test.alt DC -Uadministrator --realm=test.alt --option="dns forwarder=8.8.8.8"

Если всё нормально, в конце будет выведена информация о присоединении к домену:

Joined domain TEST (SID S-1-5-21-80639820-2350372464-3293631772) as a DCДля получения дополнительной информации можно воспользоваться командой:

# samba-tool domain join --help

# systemctl enable --now samba

Предупреждение

Предупреждение

# samba-tool drs replicate dc2.test.alt dc1.test.alt dc=test,dc=alt -Uadministrator

Сначала указывается приемник, затем источник, после этого реплицируемая ветка в LDAP.

# samba-tool drs replicate dc1.test.alt dc2.test.alt dc=test,dc=alt -Uadministrator

Сначала указывается приемник, затем источник, после этого реплицируемая ветка в LDAP.

Примечание

# samba-tool drs showrepl

Примечание

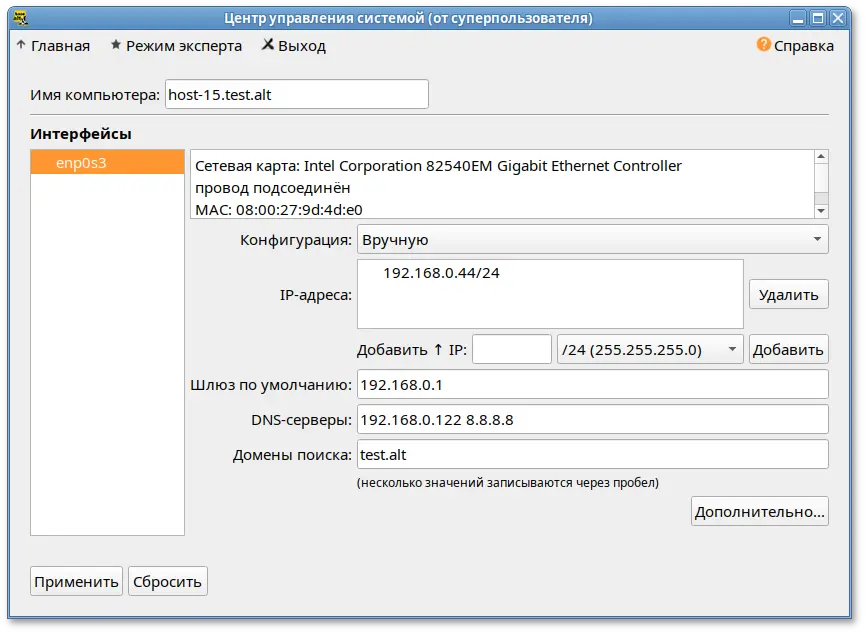

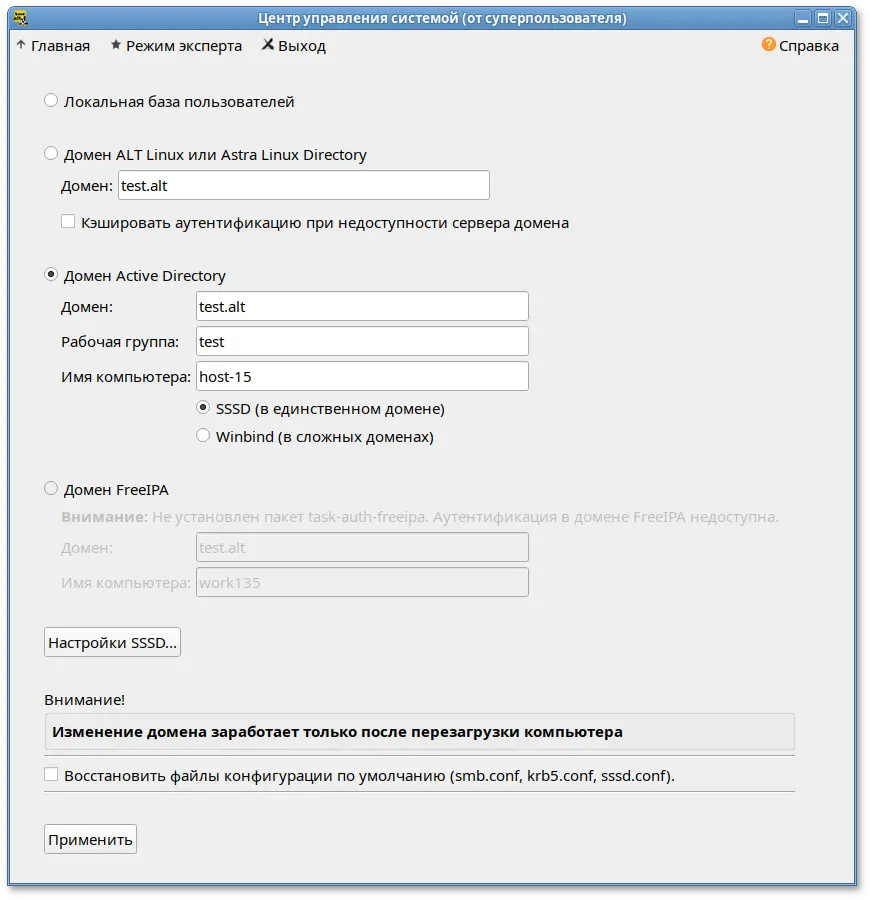

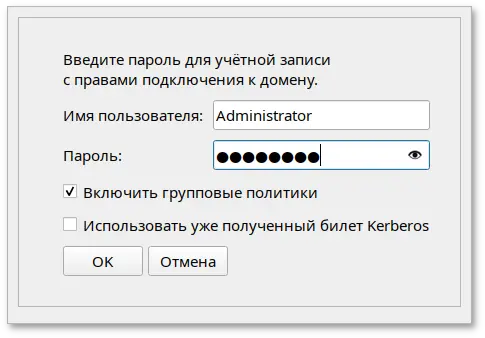

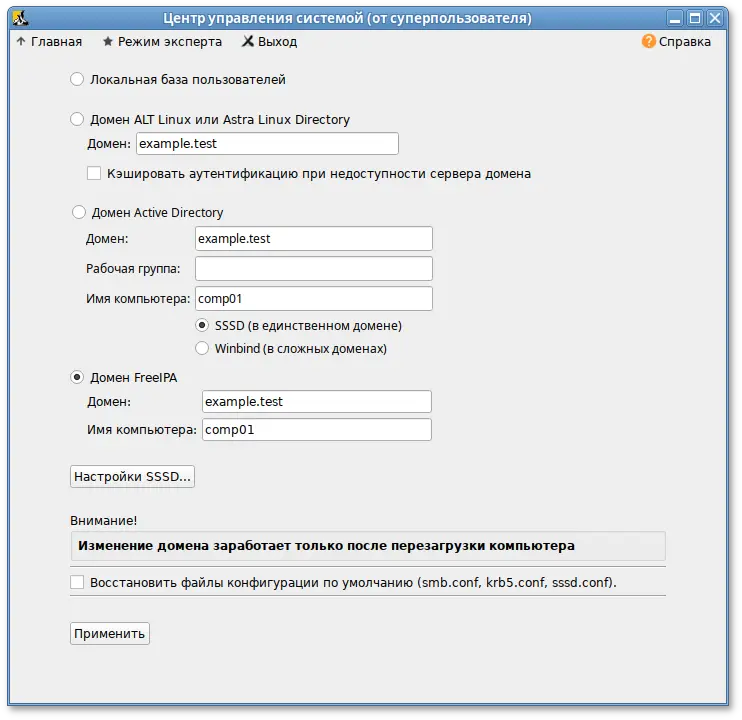

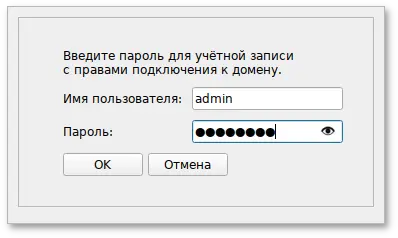

# apt-get install task-auth-ad-sssd

# hostnamectl set-hostname host-15.test.alt

/etc/net/ifaces/enp0s3/resolv.conf со следующим содержимым:

nameserver 192.168.0.122где 192.168.0.122 — IP-адрес DNS-сервера домена.

/etc/resolvconf.conf добавить/отредактировать следующие параметры:

interface_order='lo lo[0-9]* lo.* enp0s3' search_domains=test.altгде enp0s3 — интерфейс, на котором доступен контроллер домена, test.alt — домен.

# resolvconf -u

Примечание

/etc/resolv.conf должны появиться строки:

search test.alt nameserver 192.168.0.122

# system-auth write ad test.alt host-15 test 'administrator' 'Pa$$word'

Joined 'HOST-15' to dns domain 'test.alt'

Важно

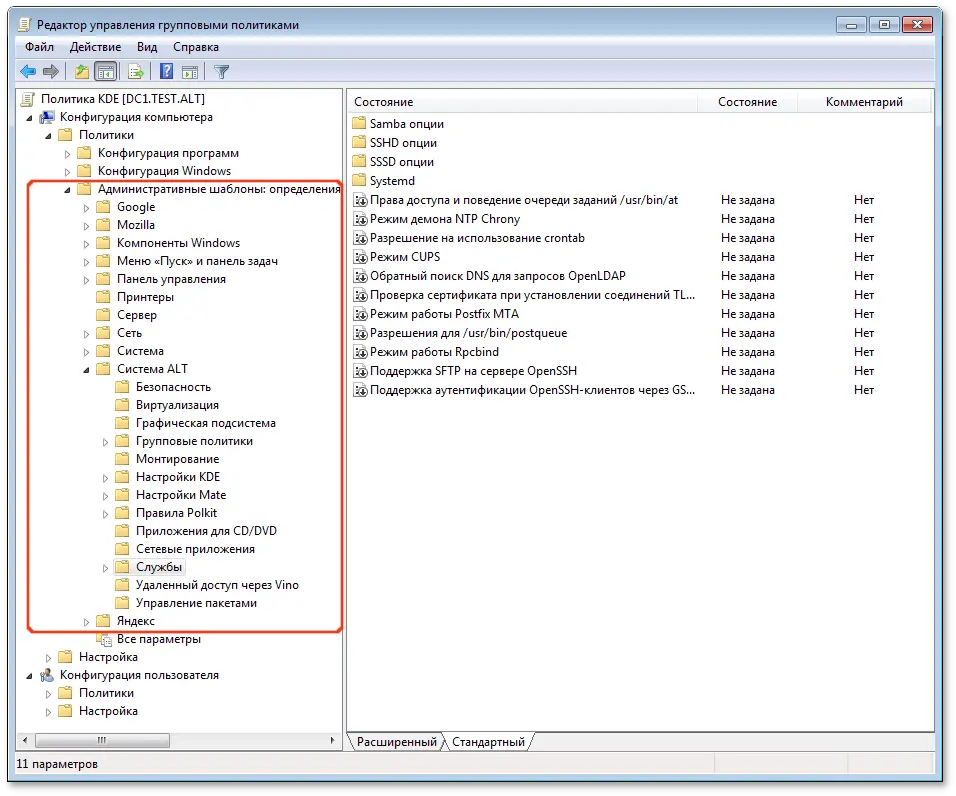

# apt-get install admx-basealt admx-chromium admx-firefox admx-yandex-browser admx-msi-setup

# admx-msi-setup

Примечание

admx-msi-setup устанавливает последнюю версию ADMX от Microsoft (сейчас это Microsoft Group Policy — Windows 10 October 2020 Update (20H2)). С помощью параметров, можно указать другой источник:

# admx-msi-setup -h

admx-msi-setup - download msi files and extract them in <destination-directory> default value is /usr/share/PolicyDefinitions/.

Usage: admx-msi-setup [-d <destination-directory>] [-s <admx-msi-source>]

Removing admx-msi-setup temporary files...

/usr/share/PolicyDefinitions. Необходимо скопировать локальные ADMX-файлы в сетевой каталог sysvol (/var/lib/samba/sysvol/<DOMAIN>/Policies/):

# samba-tool gpo admxload -U Administrator

Примечание

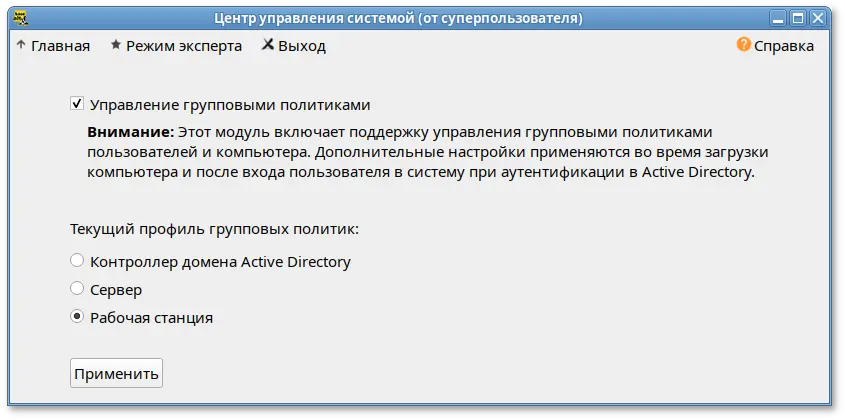

# apt-get install alterator-gpupdate

Примечание

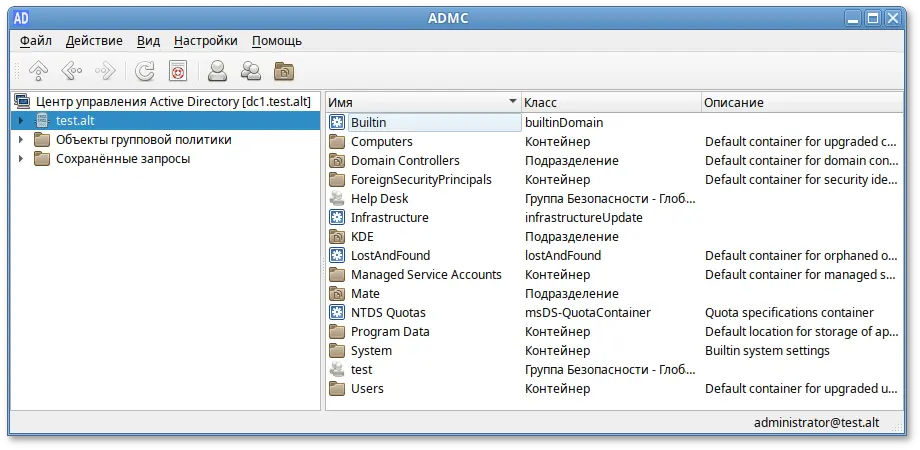

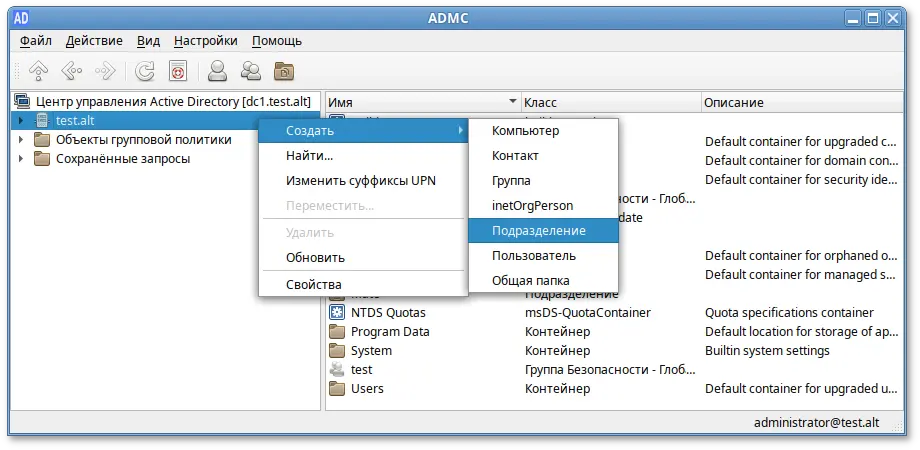

# apt-get install admc gpui

Примечание

#apt-get install admx-basealt admx-chromium admx-firefox admx-yandex-browser admx-msi-setup#admx-msi-setup

\\<DOMAIN>\SYSVOL\<DOMAIN>\Policies\PolicyDefinitions.

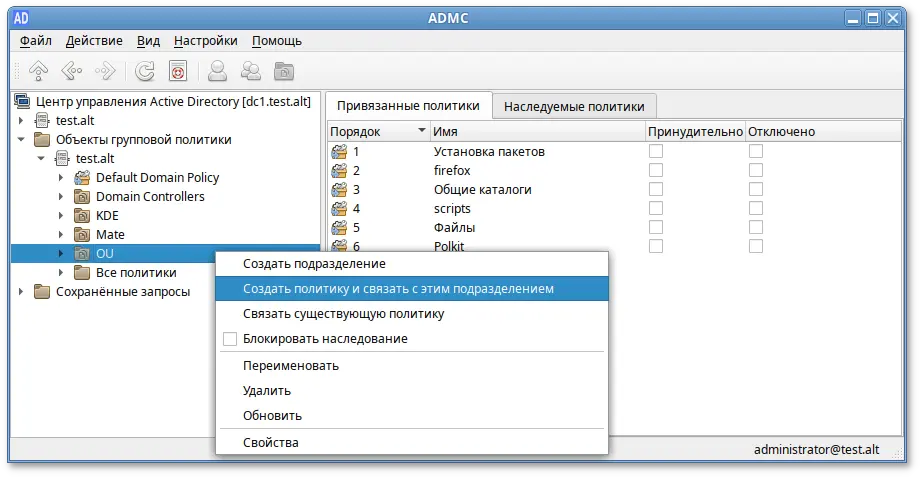

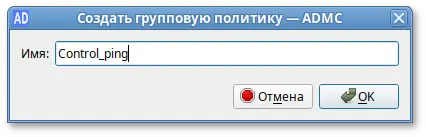

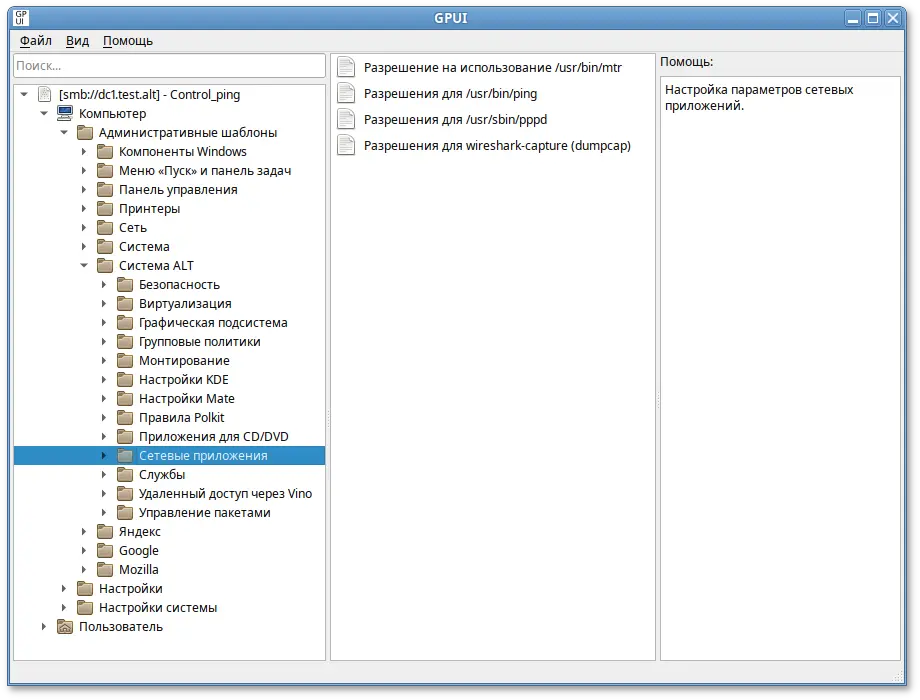

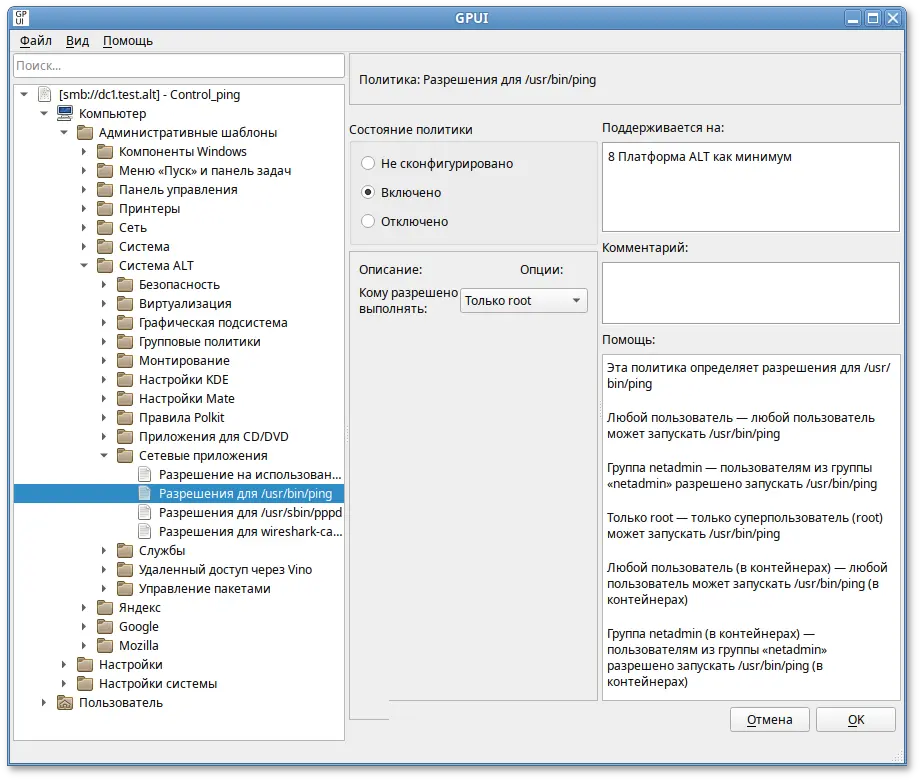

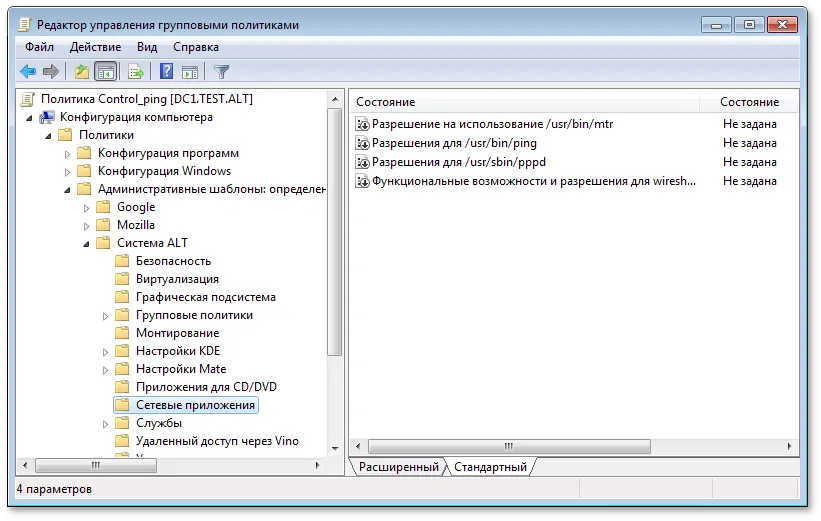

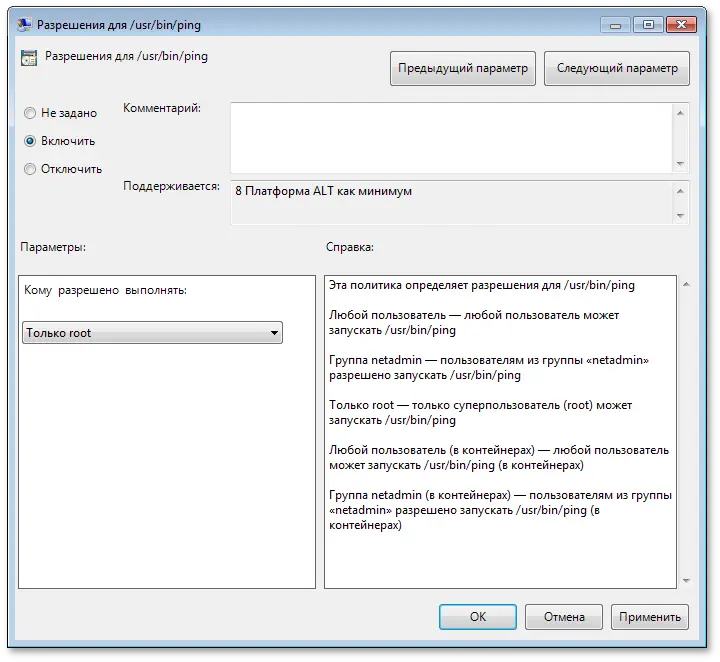

ping только суперпользователю (root).

$ kinit administrator

Password for administrator@TEST.ALT:

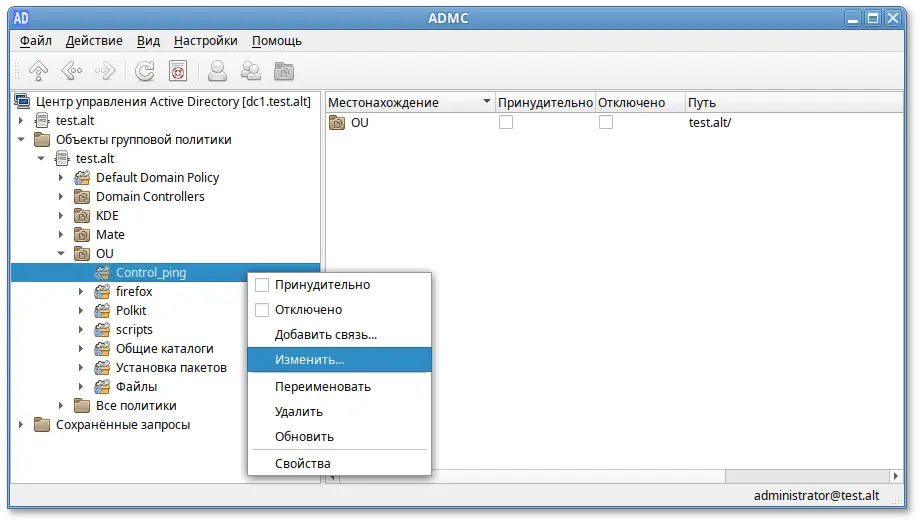

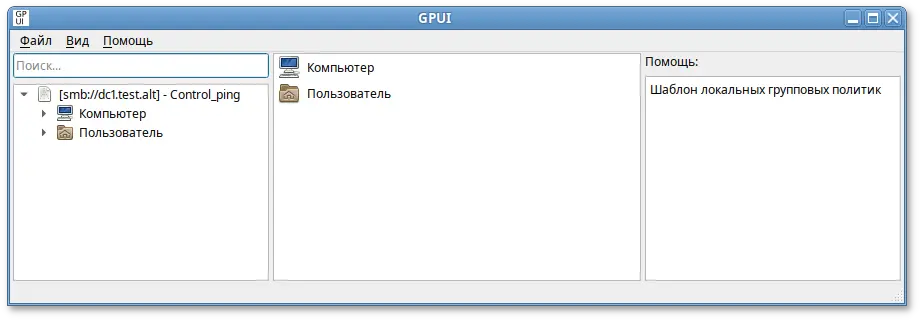

admc:

$ admc

ping сможет только администратор:

$ping localhostbash: ping: команда не найдена $/usr/bin/ping localhostbash: /usr/bin/ping: Отказано в доступе #control pingrestricted

Важно

# gpoa --loglevel 0

В выводе команды будут фигурировать полученные групповые объекты. В частности, соответствующий уникальный код (GUID) объекта.

smb.confПримечание

/etc/samba/smb.conf, следует запустить команду testparm для проверки файла на синтаксические ошибки:

# testparm /etc/samba/smb.conf

И, в случае отсутствия ошибок, перезапустить службы smb и nmb, чтобы изменения вступили в силу:

#systemctl restart smb#systemctl restart nmb

Примечание

# smbpasswd -a <имя_пользователя>

Примечание

# smbpasswd -a user

New SMB password:

Retype new SMB password:

Added user user.

Примечание

Примечание

browseable для домашних каталогов будет унаследован от глобального флага browseable, а не флага browseable раздела [homes]. Таким образом, установка browseable = no в разделе [homes] скроет общий ресурс [homes], но сделает видимыми все автоматические домашние каталоги.

browseable — определяет, отображается ли этот общий ресурс в списке доступных общих ресурсов в сетевом окружении и в списке просмотра (по умолчанию: browseable = yes);

path — указывает каталог, к которому должен быть предоставлен доступ;

read only — если для этого параметра задано значение «yes», то пользователи службы не могут создавать или изменять файлы в каталоге (по умолчанию: read only = yes);

writable — инвертированный синоним для read only (по умолчанию: writeable = no);

write list — список пользователей, которым будет предоставлен доступ для чтения и записи. Если пользователь находится в этом списке, ему будет предоставлен доступ для записи, независимо от того, какой параметр установлен для параметра read only. Список может включать имена групп с использованием синтаксиса @group;

read list — список пользователей, которым будет предоставлен доступ только для чтения. Если пользователь находится в этом списке, ему не будет предоставлен доступ для записи, независимо от того, какой параметр установлен для параметра read only. Список может включать имена групп;

guest ok — если этот параметр имеет значение «yes», то для подключения к ресурсу не требуется пароль (по умолчанию: guest ok = no);

guest only — разрешить только гостевые соединения к общему ресурсу (по умолчанию: guest only = no);

printable — если этот параметр имеет значение «yes», то клиенты могут открывать, писать и ставить задания в очередь печати (по умолчанию: printable = no);

map to guest — определяет что делать с запросами, которые не удалось аутентифицировать («Never» — запросы с неправильными паролями будут отклонены; «Bad user» — запросы с неправильными паролями будут отклонены, если такое имя пользователя существует;) (по умолчанию: map to guest = Never).

/etc/samba/smb.conf для работы Samba в режиме файлового сервера с двумя открытыми для общего доступа ресурсами, домашними каталогами пользователей и принтером (закомментированные параметры действуют по умолчанию):

[global]

workgroup = WORKGROUP

server string = Samba Server Version %v

security = user

log file = /var/log/samba/log.%m

max log size = 50

guest ok = yes

cups options = raw

map to guest = Bad User

; idmap config * : backend = tdb

[homes]

comment = Home Directory for '%u'

browseable = no

writable = yes

guest ok = no

[share]

comment = Commonplace

path = /srv/share

read only = No

[printers]

comment = All Printers

path = /var/spool/samba

browseable = no

; guest ok = no

; writable = no

printable = yes

# Каталог доступный только для чтения, за исключением пользователей

# входящих в группу "staff"

[public]

comment = Public Stuff

path = /home/samba

public = yes

writable = yes

write list = +staff

; browseable = yes

[Free]

path = /mnt/win/Free

read only = no

; browseable = yes

guest ok = yes

# smbclient -L 192.168.0.157 -Uuser

Password for [WORKGROUP\user]:

Sharename Type Comment

--------- ---- -------

share Disk Commonplace

public Disk Public Stuff

Free Disk

IPC$ IPC IPC Service (Samba Server Version 4.19.7-alt4)

user Disk Home Directory for 'user'

Примечание

man smb.conf.

/etc/fstab /etc/samba/sambacreds (например, командой mcedit /etc/samba/sambacreds), с содержимым:

username=имя_пользователя password=пароль

/etc/fstab необходимо прописать:

//server/public /mnt/server_public cifs users,credentials=/etc/samba/sambacreds 0 0

/etc/samba/sambacreds, надо установить так, чтобы файл был доступен только владельцу:

# chmod 600 /etc/samba/sambacreds

и принадлежать root:

# chown root: /etc/samba/sambacreds

Предупреждение

# apt-get install task-sogo

# /etc/init.d/postgresql initdb

# systemctl start postgresql

#su - postgres -s /bin/sh -c 'createuser --no-superuser --no-createdb --no-createrole sogo'#su - postgres -s /bin/sh -c 'createdb -O sogo sogo'#systemctl restart postgresql

#samba-tool user create sogo#samba-tool user setexpiry --noexpiry sogo

/etc/sogo/sogo.conf:

{

SOGoProfileURL = "postgresql://sogo@/sogo/sogo_user_profile";

OCSFolderInfoURL = "postgresql://sogo@/sogo/sogo_folder_info";

OCSSessionsFolderURL = "postgresql://sogo@/sogo/sogo_sessions_folder";

OCSEMailAlarmsFolderURL = "postgresql://sogo@/sogo/sogo_alarms_folder";

SOGoEnableEMailAlarms = YES;

SOGoDraftsFolderName = Drafts;

SOGoSentFolderName = Sent;

SOGoTrashFolderName = Trash;

SOGoIMAPServer = "imaps://localhost:993/?tlsVerifyMode=allowInsecureLocalhost";

SOGoMailingMechanism = sendmail;

SOGoForceExternalLoginWithEmail = NO;

NGImap4ConnectionStringSeparator = "/";

SOGoUserSources = (

{

id = sambaLogin;

displayName = "SambaLogin";

canAuthenticate = YES;

type = ldap;

CNFieldName = cn;

IDFieldName = cn;

UIDFieldName = sAMAccountName;

hostname = "ldaps://127.0.0.1";

baseDN = "CN=Users,DC=test,DC=alt";

bindDN = "CN=sogo,CN=Users,DC=test,DC=alt";

bindPassword = "Pa$$word";

bindFields = (sAMAccountName);

},

{

id = sambaShared;

displayName = "Shared Addressbook";

canAuthenticate = NO;

isAddressBook = YES;

type = ldap;

CNFieldName = cn;

IDFieldName = mail;

UIDFieldName = mail;

hostname = "ldaps://127.0.0.1";

baseDN = "CN=Users,DC=test,DC=alt";

bindDN = "CN=sogo,CN=Users,DC=test,DC=alt";

bindPassword = "Pa$$word";

filter = "((NOT isCriticalSystemObject='TRUE') AND (mail='*') AND (NOT objectClass=contact))";

},

{

id = sambaContacts;

displayName = "Shared Contacts";

canAuthenticate = NO;

isAddressBook = YES;

type = ldap;

CNFieldName = cn;

IDFieldName = mail;

UIDFieldName = mail;

hostname = "ldaps://127.0.0.1";

baseDN = "CN=Users,DC=test,DC=alt";

bindDN = "CN=sogo,CN=Users,DC=test,DC=alt";

bindPassword = "Pa$$word";

filter = "((((objectClass=person) AND (objectClass=contact) AND ((uidNumber>=2000) OR (mail='*')))

AND (NOT isCriticalSystemObject='TRUE') AND (NOT showInAdvancedViewOnly='TRUE') AND (NOT uid=Guest))

OR (((objectClass=group) AND (gidNumber>=2000)) AND (NOT isCriticalSystemObject='TRUE') AND (NOT showInAdvancedViewOnly='TRUE')))";

mapping = {

displayname = ("cn");

};

}

);

SOGoSieveScriptsEnabled = YES;

SOGoLanguage = Russian;

SOGoTimeZone = Europe/Moscow;

SOGoFirstDayOfWeek = 1;

}

# for service in samba postgresql memcached sogo httpd2; do systemctl enable $service; systemctl restart $service; done

/var/log/sogo/sogo.log

#for mod in proxy proxy_http authn_core authn_file auth_basic authz_user env dav headers rewrite version setenvif; do a2enmod $mod; done#a2ensite SOGo#systemctl restart httpd2 sogo

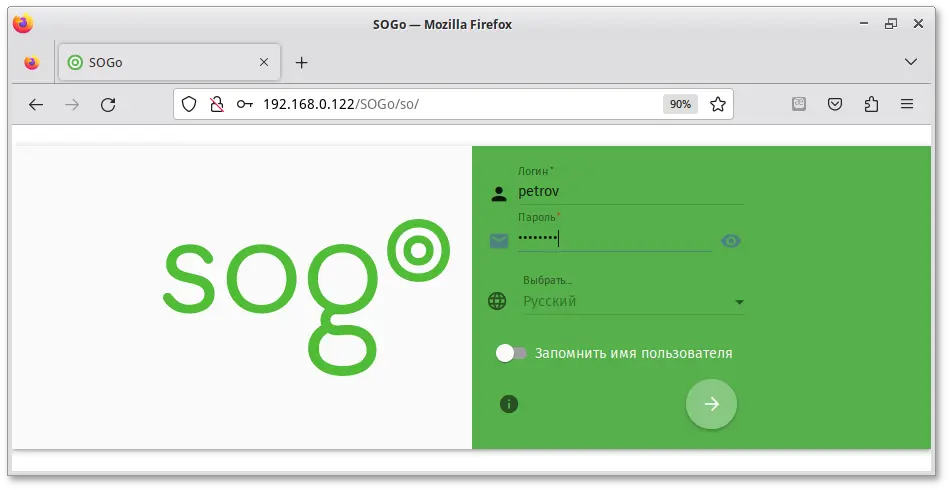

http://<адрес_сервера>/SOGo/

Примечание

/var/log/sogo/sogo.log есть ошибки вида:

Jul 06 16:14:51 sogod [12257]: [ERROR] <0x0x5578db070b40[LDAPSource]> Could not bind to the LDAP server ldaps://127.0.0.1 (389) using the bind DN: CN=sogo,CN=Users,DC=test,DC=altСледует в файл

/etc/openldap/ldap.conf добавить опцию

TLS_REQCERT allowи перезапустить службы samba и sogo:

# systemctl restart samba sogo

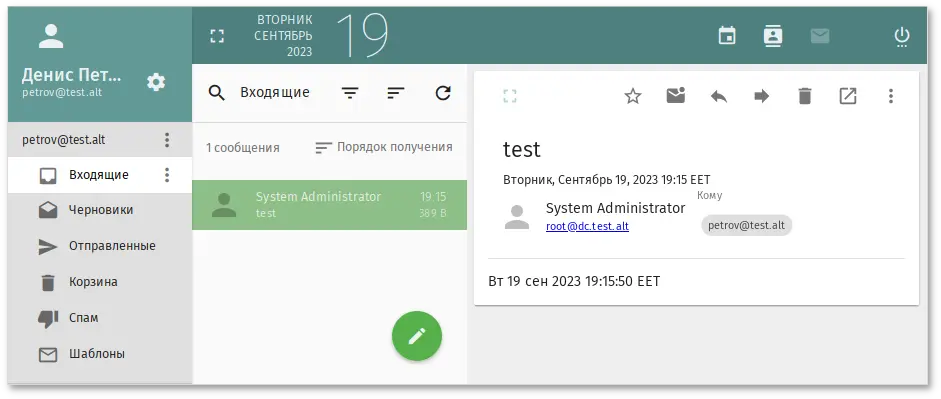

/var/mail/<имя_домена>/<имя_пользователя> (формат maildir);

Примечание

mail-address. Указать атрибут mail-address можно, например, при создании учётной записи:

# samba-tool user create petrov --mail-address='petrov@test.alt'

Предупреждение

/etc/samba/smb.conf в секции [global]:

ldap server require strong auth = noи перезапустить samba:

# systemctl restart samba

#samba-tool user create -W Users vmail#samba-tool user setexpiry vmail --noexpiry

# apt-get install postfix-ldap

/etc/postfix изменить файлы для домена test.alt:

main.cf:

# Global Postfix configuration file. This file lists only a small subset # of all parameters. For the syntax, and for a complete parameter list, # see the postconf(5) manual page. For a commented and more complete # version of this file see /etc/postfix/main.cf.dist mailbox_command = /usr/libexec/dovecot/dovecot-lda -f "$SENDER" -a "$RECIPIENT" inet_protocols = ipv4 # Mappings virtual_mailbox_base = /var/mail virtual_mailbox_domains = test.alt virtual_mailbox_maps = ldap:/etc/postfix/ad_local_recipients.cf virtual_alias_maps = ldap:/etc/postfix/ad_mail_groups.cf virtual_transport = dovecot local_transport = virtual local_recipient_maps = $virtual_mailbox_maps # SSL/TLS smtpd_use_tls = yes smtpd_tls_security_level = encrypt #smtpd_tls_security_level = may smtpd_sasl_auth_enable = yes smtpd_sasl_local_domain = test.alt smtpd_sasl_path = private/auth smtpd_sasl_type = dovecot smtpd_sender_login_maps = ldap:/etc/postfix/ad_sender_login.cf smtpd_tls_auth_only = yes smtpd_tls_cert_file = /var/lib/ssl/certs/dovecot.cert smtpd_tls_key_file = /var/lib/ssl/private/dovecot.key smtpd_tls_CAfile = /var/lib/ssl/certs/dovecot.pem smtpd_recipient_restrictions = permit_mynetworks, reject_unauth_destination, per-mit_sasl_authenticated, reject smtpd_sender_restrictions = reject_authenticated_sender_login_mismatch default_destination_recipient_limit = 1

/etc/postfix/mydestination должен быть пустым;

master.cf необходимо добавить строки:

dovecot unix - n n - - pipe

flags=DRhu user=mail:mail argv=/usr/libexec/dovecot/deliver -d ${recipient}

smtps inet n - n - - smtpd

-o smtpd_tls_wrappermode=yes

-o smtpd_sasl_auth_enable=yes

-o smtpd_client_restrictions=permit_sasl_authenticated,reject

ad_local_recipients.cf:

version = 3 server_host = test.alt:389 search_base = dc=test,dc=alt scope = sub query_filter = (&(|(mail=%s)(otherMailbox=%u@%d))(sAMAccountType=805306368)) result_filter = %s result_attribute = mail special_result_attribute = member bind = yes bind_dn = cn=vmail,cn=users,dc=test,dc=alt bind_pw = Pa$$word

ad_mail_groups.cf:

version = 3 server_host = test.alt:389 search_base = dc=test,dc=alt timeout = 3 scope = sub query_filter = (&(mail=%s)(sAMAccountType=268435456)) result_filter = %s leaf_result_attribute = mail special_result_attribute = member bind = yes bind_dn = cn=vmail,cn=users,dc=test,dc=alt bind_pw = Pa$$word

ad_sender_login.cf:

version = 3 server_host = test.alt:389 search_base = dc=test,dc=alt scope = sub query_filter = (&(objectClass=user)(|(sAMAccountName=%s)(mail=%s))) result_attribute = mail bind = yes bind_dn = cn=vmail,cn=users,dc=test,dc=alt bind_pw = Pa$$word

# systemctl restart postfix

# postconf >/dev/null

# postmap -q petrov@test.alt ldap:/etc/postfix/ad_local_recipients.cf

petrov@test.alt

Проверка входа:

# postmap -q petrov@test.alt ldap:/etc/postfix/ad_sender_login.cf

petrov@test.alt

Проверка общего адреса e-mail:

#samba-tool group add --mail-address=sales@test.alt SalesAdded group Sales #samba-tool group addmembers Sales ivanov,petrovAdded members to group Sales #postmap -q sales@test.alt ldap:/etc/postfix/ad_mail_groups.cfsales@test.alt,ivanov@test.alt,petrov@test.alt

# apt-get install dovecot

/etc/dovecot/dovecot-ldap.conf.ext:

hosts = test.alt:3268 ldap_version = 3 auth_bind = yes dn = cn=vmail,cn=Users,dc=test,dc=alt dnpass = Pa$$word base = cn=Users,dc=test,dc=alt scope = subtree deref = never user_filter = (&(objectClass=user)(|(mail=%Lu)(sAMAccountName=%Lu))) user_attrs = =uid=8,gid=12,mail=user pass_filter = (&(objectClass=user)(|(mail=%Lu)(sAMAccountName=%Lu))) pass_attrs = mail=user

/etc/dovecot/conf.d/10-auth.conf к виду:

auth_mechanisms = plain !include auth-ldap.conf.ext

/etc/dovecot/conf.d/10-mail.conf:

mail_location = maildir:/var/mail/%d/%n:UTF-8:INBOX=/var/mail/%d/%n/Inbox mail_uid = mail mail_gid = mail first_valid_uid = 5 first_valid_gid = 5

/etc/dovecot/conf.d/10-master.conf:

service imap-login {

inet_listener imap {

port = 0

}

inet_listener imaps {

}

}

service pop3-login {

inet_listener pop3 {

port = 0

}

inet_listener pop3s {

port = 0

}

}

service lmtp {

unix_listener lmtp {

}

}

service imap {

}

service pop3 {

}

service auth {

unix_listener auth-userdb {

}

unix_listener /var/spool/postfix/private/auth {

mode = 0600

user = postfix

group = postfix

}

}

service auth-worker {

}

service dict {

unix_listener dict {

}

}

/etc/dovecot/conf.d/15-lda.conf:

protocol lda {

hostname = test.alt

postmaster_address = administrator@test.alt

}

/etc/dovecot/conf.d/15-mailboxes.conf:

namespace inbox {

inbox = yes

mailbox Drafts {

auto = subscribe

special_use = \Drafts

}

mailbox Junk {

auto = subscribe

special_use = \Junk

}

mailbox Trash {

auto = subscribe

special_use = \Trash

}

mailbox Sent {

auto = subscribe

special_use = \Sent

}

mailbox "Sent Messages" {

special_use = \Sent

}

}

/etc/dovecot/conf.d/10-stats.conf:

service stats {

unix_listener stats-reader {

user = mail

group = mail

mode = 0660

}

unix_listener stats-writer {

user = mail

group = mail

mode = 0660

}

}

# systemctl restart dovecot

# doveconf >/dev/null

#chown dovecot:root /etc/dovecot/dovecot-ldap.conf.ext#chmod 0640 /etc/dovecot/dovecot-ldap.conf.ext#chown root:postfix /etc/postfix/ad_local_recipients.cf /etc/postfix/ad_mail_groups.cf /etc/postfix/ad_sender_login.cf#chmod 0640 /etc/postfix/ad_local_recipients.cf /etc/postfix/ad_mail_groups.cf /etc/postfix/ad_sender_login.cf

# systemctl restart dovecot postfix

#date | mail -s test petrov@test.alt#mailqMail queue is empty

#где dc1.test.alt — имя узла сервера SOGo.openssl s_client -crlf -connect dc1.test.alt:993...tag login petrov@test.alt Pa$$wordtag OK [CAPABILITY IMAP4rev1 LITERAL+ SASL-IR LOGIN-REFERRALS ID ENABLE IDLE SORT SORT=DISPLAY THREAD=REFERENCES THREAD=REFS THREAD=ORDEREDSUBJECT MULTIAPPEND URL-PARTIAL CATENATE UNSELECT CHILDREN NAMESPACE UIDPLUS LIST-EXTENDED I18NLEVEL=1 CONDSTORE QRESYNC ESEARCH ESORT SEARCHRES WITHIN CONTEXT=SEARCH LIST-STATUS BINARY MOVE] Logged in

/etc/dovecot/conf.d/dovecot.conf указать используемые протоколы:

protocols = imap lmtp submission sieve

/etc/dovecot/conf.d/10-mail.conf добавить опцию mail_home с указанием пути до каталогов с почтой:

mail_location = maildir:/var/mail/%d/%n:UTF-8:INBOX=/var/mail/%d/%n/Inbox mail_uid = mail mail_gid = mail first_valid_uid = 5 first_valid_gid = 5 mail_home = /var/mail/%d/%nПеременные

%d и %u указывают на имя домена и имя учетной записи.

/etc/dovecot/conf.d/15-lda.conf в раздел protocol lda добавить плагин sieve:

mail_plugins = $mail_plugins sieve

/etc/dovecot/conf.d/20-lmtp.conf в разделе protocol lmtp также указать плагин sieve:

mail_plugins = $mail_plugins sieve

/etc/dovecot/conf.d/20-managesieve.conf раскомментировать строку:

protocols = $protocols sieve

/etc/dovecot/conf.d/90-sieve.conf закомментировать строку sieve = file:~/sieve;active=~/.dovecot.sieve и добавить новое её значение:

#sieve = file:~/sieve;active=~/.dovecot.sieve sieve = file:/var/mail/%Ld/%n/sieve;active=/var/mail/%Ld/%n/active.sieveВ этом же файле раскомментировать опцию

sieve_extensions и привести её к виду:

sieve_extensions = +notify +imapflags +vacation-seconds +vacation +date +relational

/etc/dovecot/conf.d/10-auth.conf подключить master-users:

!include auth-master.conf.ext

/etc/dovecot/master-users создать запись:

my_master_user@non-exist.com:{PLAIN}password::::::

Должно быть обязательно указано несуществующее имя домена. В реальных условиях необходимо использовать хэш пароля (например, doveadm pw -s SSHA512).

/etc/sogo/sieve.creds указать эти данные в виде:

my_master_user@non-exist.com:password

/etc/cron.d/sogo дописать:

MAILTO=""и раскомментировать строку:

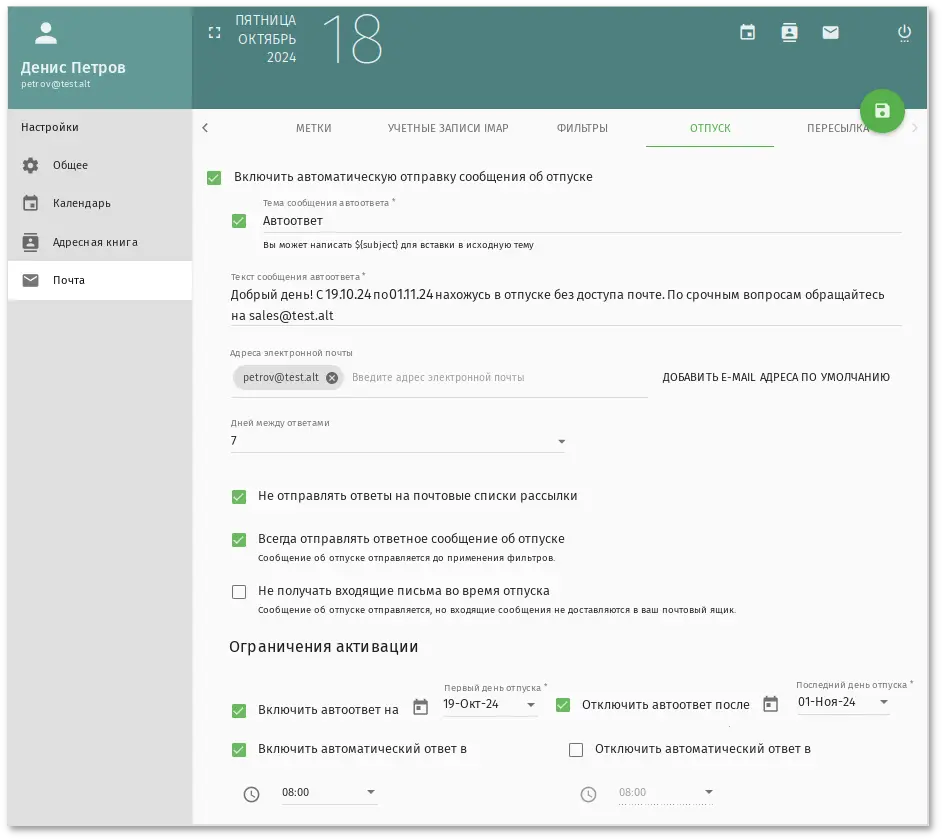

*/5 * * * * _sogo /usr/sbin/sogo-tool update-autoreply -p /etc/sogo/sieve.creds

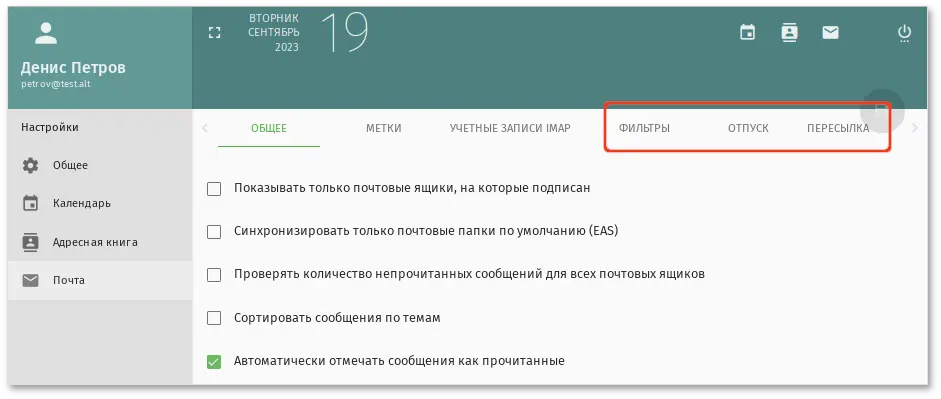

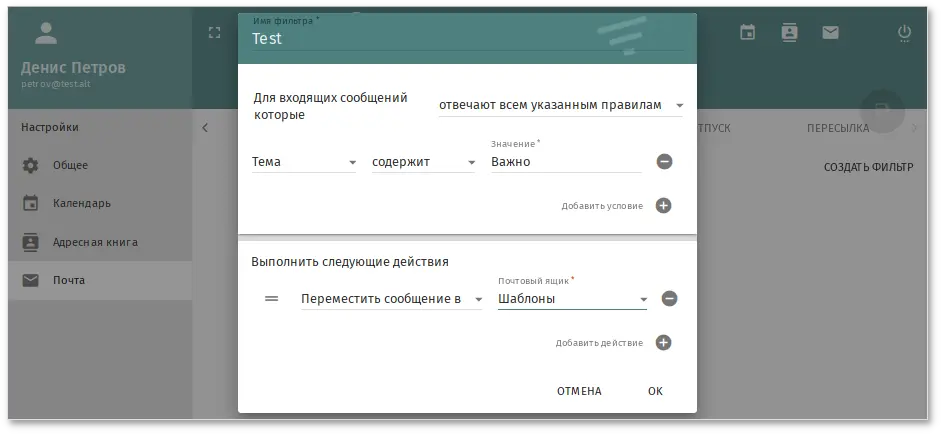

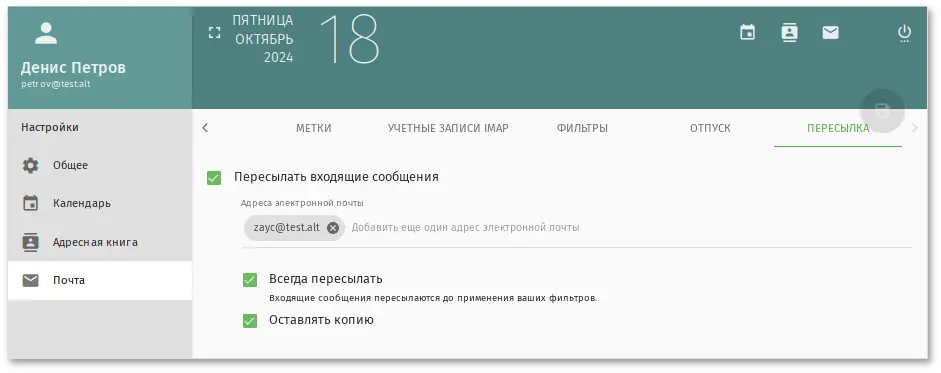

SOGoSieveScriptsEnabled), окно настроек сообщений об отпуске (параметр SOGoVacationEnabled), а также окно настроек адресов электронной почты для пересылки (параметр SOGoForwardEnabled). Для этого в файл конфигурации /etc/sogo/sogo.conf добавить строки:

SOGoSieveScriptsEnabled = YES; SOGoVacationEnabled = YES; SOGoForwardEnabled = YES; SOGoSieveFolderEncoding = UTF-8;

# systemctl restart postfix dovecot sogo

#systemctl stop ahttpd#a2dissite 000-default_https#a2disport https#systemctl condreload httpd2

# apt-get install freeipa-server freeipa-server-dns

# hostnamectl set-hostname ipa.example.test

Примечание

# ipa-server-install -U --hostname=$(hostname) -r EXAMPLE.TEST -n example.test -p 12345678 -a 12345678 --setup-dns --forwarder 8.8.8.8 --auto-reverse

Для пакетной установки необходимо указать следующие параметры:

-r REALM_NAME — имя области Kerberos для сервера FreeIPA;

-n DOMAIN_NAME — доменное имя;

-p DM_PASSWORD — пароль, который будет использоваться сервером каталогов для менеджера каталогов (DM);

-a ADMIN_PASSWORD — пароль пользователя admin, администратора FreeIPA;

-U — позволить процессу установки выбрать параметры по умолчанию, не запрашивая у пользователя информацию;

--hostname=HOST_NAME — полное DNS-имя этого сервера.

--setup-dns — создать зону DNS, если она еще не существует, и настроить DNS-сервер;

--forwarder или --no-forwarders — в зависимости от того, нужно ли настроить серверы пересылки DNS или нет;

--auto-reverse или --no-reverse — в зависимости от того, нужно ли настроить автоматическое обнаружение обратных зон DNS, которые должны быть созданы в FreeIPA DNS, или отключить автоматическое определение обратных зон.

Предупреждение

--mkhomedir):

# ipa-server-install -U --hostname=$(hostname) -r EXAMPLE.TEST -n example.test -p 12345678 -a 12345678 --setup-dns --forwarder 8.8.8.8 --auto-reverse --mkhomedir

# ipa-server-install

Do you want to configure integrated DNS (BIND)? [no]: yesОстальные вопросы необходимо выбрать по умолчанию (можно просто нажать Enter). Так же при установке необходимо ввести пароль администратора системы и пароль администратора каталогов (пароли должны быть не менее 8 символов).

The IPA Master Server will be configured with: Hostname: ipa.example.test IP address(es): 192.168.0.113 Domain name: example.test Realm name: EXAMPLE.TEST The CA will be configured with: Subject DN: CN=Certificate Authority,O=EXAMPLE.TEST Subject base: O=EXAMPLE.TEST Chaining: self-signed BIND DNS server will be configured to serve IPA domain with: Forwarders: 8.8.8.8 Forward policy: only Reverse zone(s): 0.168.192.in-addr.arpa. Continue to configure the system with these values? [no]: yesДалее начнётся процесс конфигурации. После его завершения будет выведена подсказка со следующими шагами.

# kinit admin

# ipa dnsrecord-add example.test _ntp._udp --srv-priority=0 --srv-weight=100 --srv-port=123 --srv-target=ipa.example.test

# ntpdate -q localhost

server 127.0.0.1, stratum 3, offset 0.000018, delay 0.02568

27 Nov 10:27:00 ntpdate[29854]: adjust time server 127.0.0.1 offset 0.000018 sec

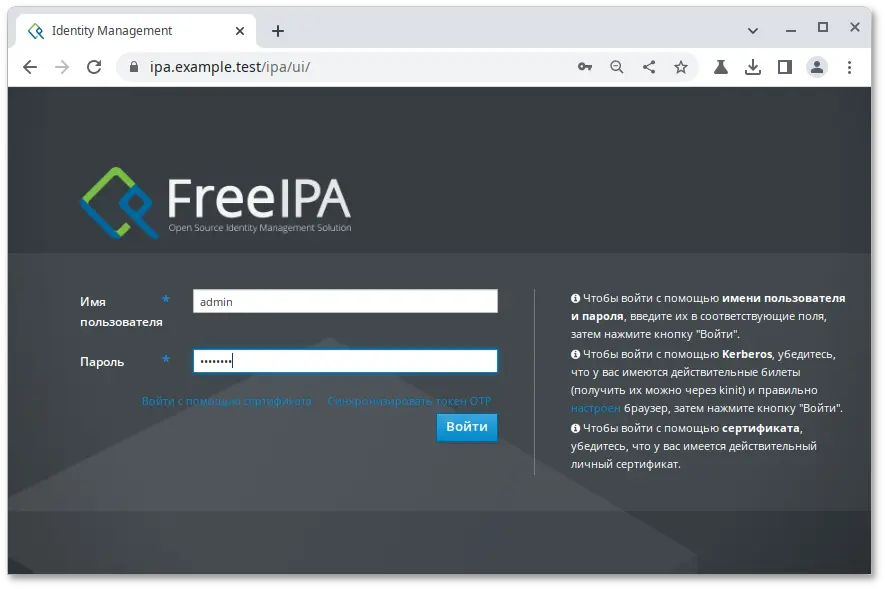

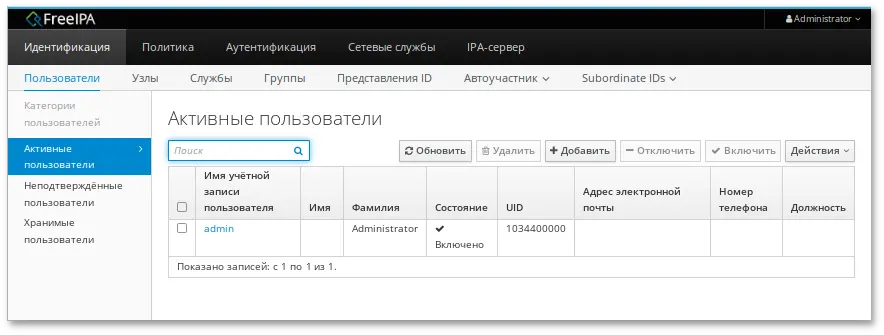

https://ipa.example.test/ipa/ui/.

Примечание

# ipa-server-install --uninstall

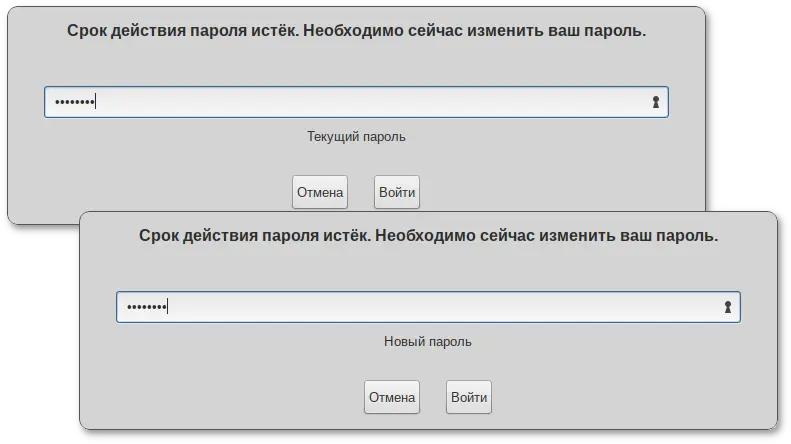

https://ipa.example.test и ввести данные администратора для входа в систему.

# apt-get install freeipa-client libsss_sudo krb5-kinit bind-utils libbind zip task-auth-freeipa

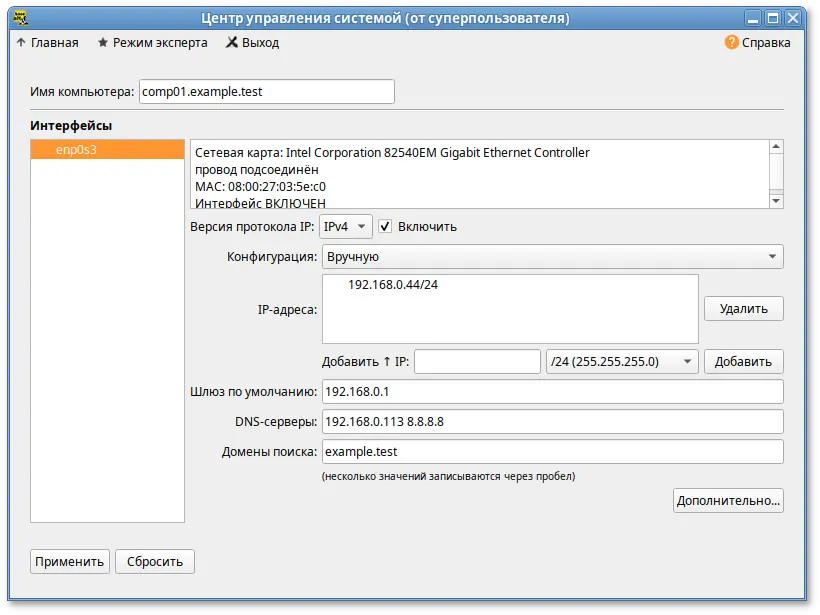

# hostnamectl set-hostname comp01.example.test

/etc/net/ifaces/eth0/resolv.conf со следующим содержимым:

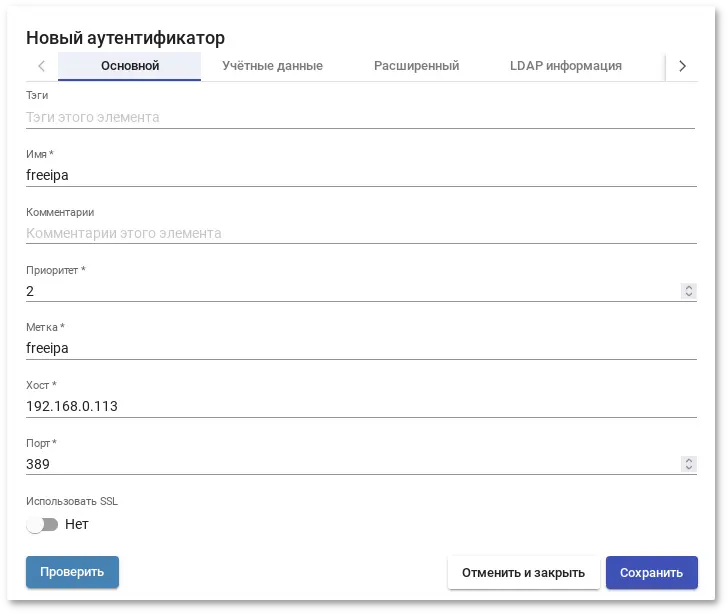

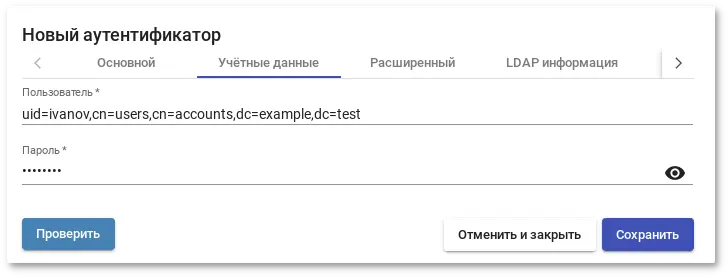

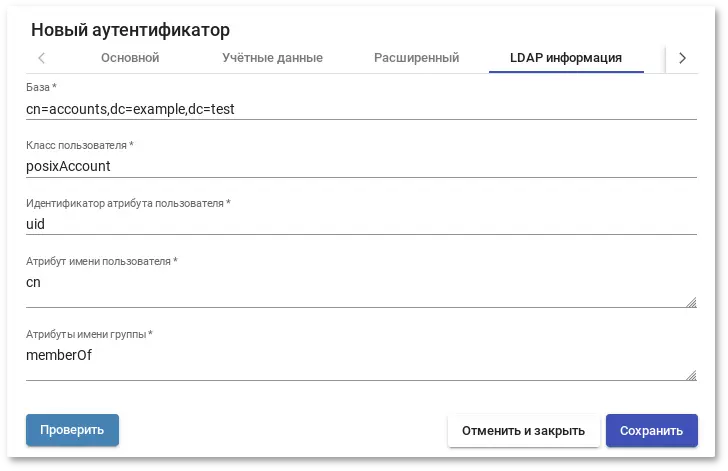

nameserver 192.168.0.113где 192.168.0.113 — IP-адрес FreeIPA сервера.

/etc/resolvconf.conf добавить/отредактировать следующие параметры:

interface_order='lo lo[0-9]* lo.* eth0' search_domains=example.testгде eth0 — интерфейс, на котором доступен FreeIPA сервер, example.test — домен.

# resolvconf -u

Примечание

/etc/resolv.conf должны появиться строки:

search example.test nameserver 192.168.0.113

# ipa-client-install -U -p admin -w 12345678

или интерактивно:

# ipa-client-install

'''Discovery was successful!''' Client hostname: comp01.example.test Realm: EXAMPLE.TEST DNS Domain: example.test IPA Server: ipa.example.test BaseDN: dc=example,dc=test Continue to configure the system with these values? [no]:Необходимо ответить

yes, ввести имя пользователя, имеющего право вводить машины в домен, и его пароль.

Предупреждение

Hostname (comp01.example.test) does not have A/AAAA record. Failed to update DNS records.Необходимо проверить IP-адрес доменного DNS сервера в файле

/etc/resolv.conf.

# ipa-client-install -U --uninstall

# control sudo public

Предупреждение

#systemctl stop sssd#rm -f /var/lib/sss/db/*#rm -f /var/lib/sss/mc/*#systemctl start sssd

# ipa-client-install --uninstall

…

Client uninstall complete.

The original nsswitch.conf configuration has been restored.

You may need to restart services or reboot the machine.

Do you want to reboot the machine? [no]: yes

The ipa-client-install command was successful

/etc/krb5.keytab):

# ipa-rmkeytab -k /path/to/keytab -r EXAMPLE.TEST

# ipa dnsrecord-del

Имя записи: comp01

Имя зоны: example.test

Возможность удаления определённой записи не предусмотрена.

Удалить все? Yes/No (default No): yes

-----------------------

Удалена запись "comp01"

-----------------------

# ipa host-del comp01.example.test

---------------------------------

Удалён узел "comp01.example.test"

---------------------------------

Примечание

ipa-replica-install сначала регистрирует систему в качестве клиента, а затем устанавливает компоненты реплики. В примере, описанном ниже, для авторизации регистрации используется случайный пароль, действительный только для одной регистрации этого клиента.

$ kinit admin

$ ipa host-add replica.example.test --random --ip-address=192.168.0.145

----------------------------------

Добавлен узел "replica.example.test"

----------------------------------

Имя узла: replica.example.test

Случайный пароль: 2AaT0Ix8itDsYugdDGoRtBt

Пароль: True

Таблица ключей: False

Managed by: replica.example.test

$ ipa hostgroup-add-member ipaservers --hosts replica.example.test

Группа узлов: ipaservers

Описание: IPA server hosts

Узлы-участники: ipa.example.test, replica.example.test

-----------------------------------

Количество добавленных участников 1

-----------------------------------

# apt-get install freeipa-server freeipa-server-dns

ipa-replica-install, указав сгенерированный пароль в параметре --password (т.к. пароль часто содержит специальные символы, следует заключить его в одинарные кавычки):

# ipa-replica-install --password='2AaT0Ix8itDsYugdDGoRtBt' --setup-ca --setup-dns --forwarder 192.168.0.113 --forwarder 8.8.8.8

Configuring client side components

This program will set up IPA client.

Version 4.9.11

Discovery was successful!

Client hostname: replica.example.test

Realm: EXAMPLE.TEST

DNS Domain: example.test

IPA Server: ipa.example.test

BaseDN: dc=example,dc=test

…

The ipa-client-install command was successful

…

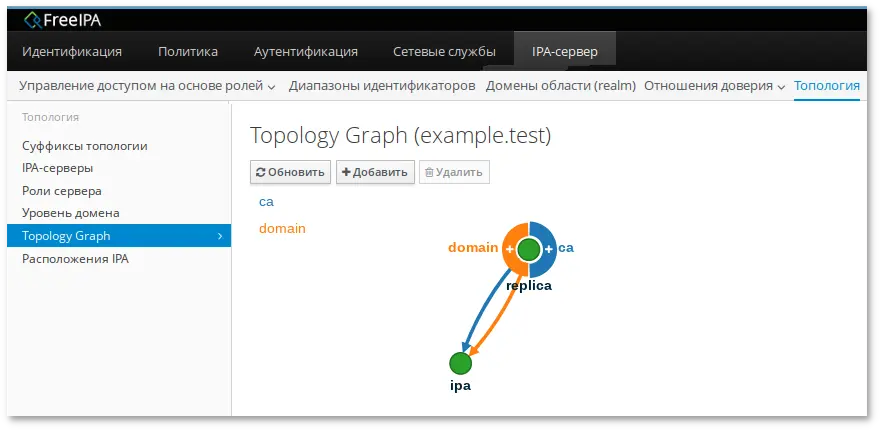

The ipa-replica-install command was successful

$kinit admin$ipa user-add test_user

$kinit admin$ipa user-show test_user

# apt-get install libvirt-kvm virt-install

# systemctl enable --now libvirtd.service

# virsh net-list --all

Имя Статус Автозапуск Persistent

----------------------------------------------

default активен yes yes

Примечание

# virsh net-define /etc/libvirt/qemu/networks/default.xml

# virsh net-autostart default

# virsh net-start default

Примечание

# control sshd-permit-root-login enabled

и перезагрузить ssh-сервер:

# systemctl restart sshd.service

После того как ключ будет скопирован, рекомендуется отключить парольную аутентификацию:

#control sshd-permit-root-login disabled#systemctl restart sshd.service

# virt-install --name alt \

--ram 4096 --cpu kvm64 --vcpus 2 \

--disk pool=default,size=20,bus=virtio,format=qcow2 \

--network network=default --graphics spice,listen=127.0.0.1,password=test \

--cdrom /var/lib/libvirt/images/alt-workstation-10.0-x86_64.iso --os-variant=alt10.0

$ virt-viewer --connect qemu+ssh://user@192.168.0.190/system

# apt-get install fleet-commander-logger

Примечание

--mkhomedir).

# apt-get install freeipa-desktop-profile

...

Perform the IPA upgrade. This may take a while.

The IPA upgrade was successful.

Завершено.

Примечание

#kinit adminPassword for admin@EXAMPLE.TEST: #ipa deskprofileconfig-showPriority of profile application: 1

Примечание

ipa deskprofileconfig-show появляется ошибка:

ipa: ERROR: неизвестная команда "deskprofileconfig-show"необходимо почистить кэш текущему пользователю и повторить команду:

#rm -rf ~/.cache/ipa#ipa deskprofileconfig-showPriority of profile application: 1

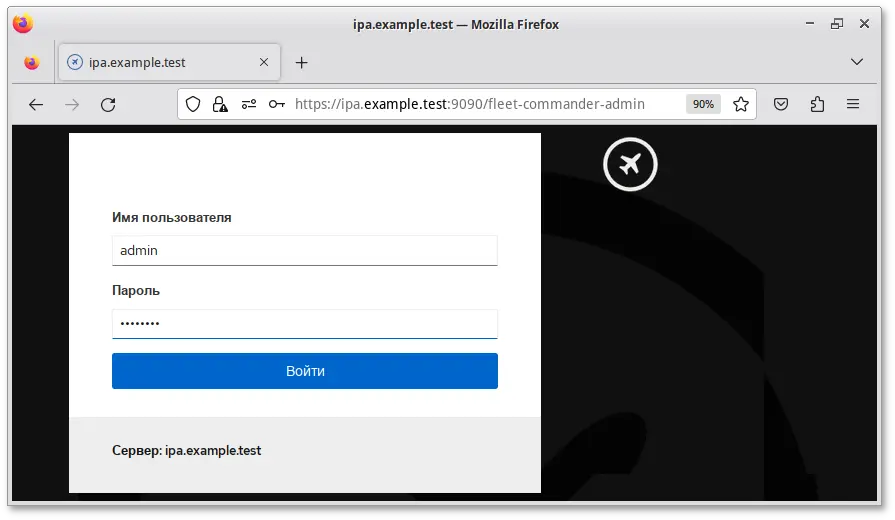

# apt-get install fleet-commander-admin

Примечание

# systemctl enable --now cockpit.socket

https://адрес-сервера:9090/:

Примечание

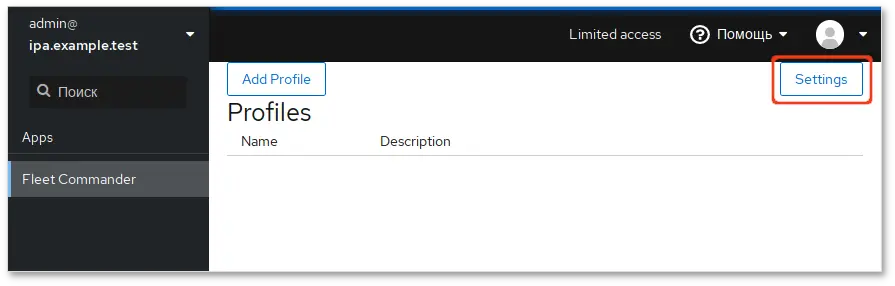

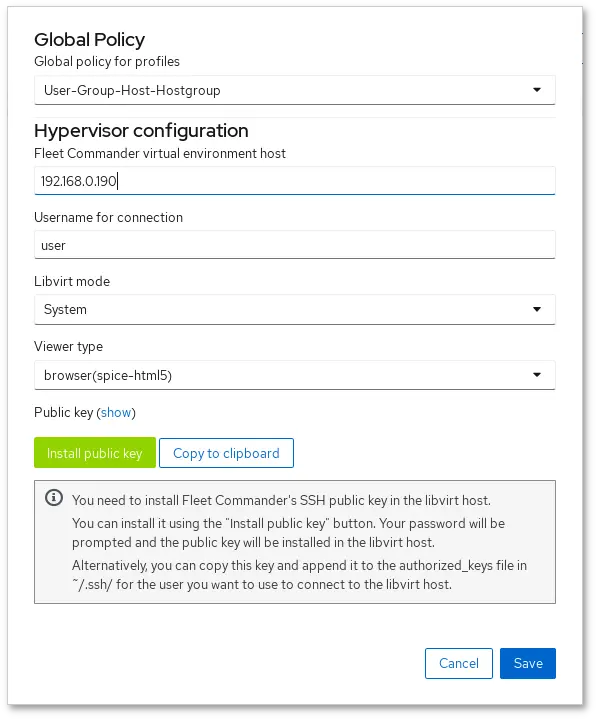

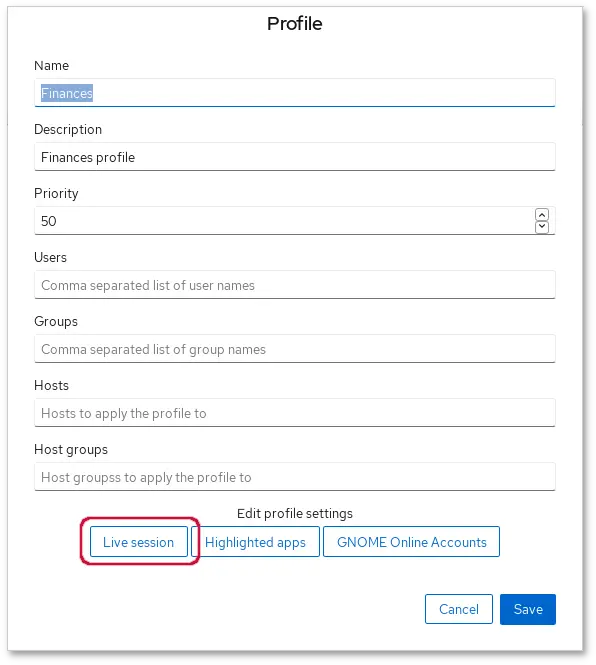

User-Group-Host-Hostgroup.

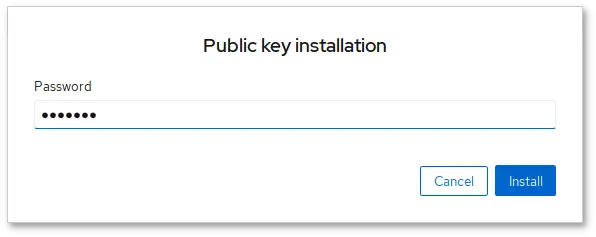

.ssh/authorized_keys для соответствующего пользователя на libvirt-хосте. Это можно сделать, нажав кнопку (), при этом будет необходимо ввести пароль пользователя. Пароль используется только для установки ключа и нигде не хранится.

Примечание

# apt-get install fleet-commander-client

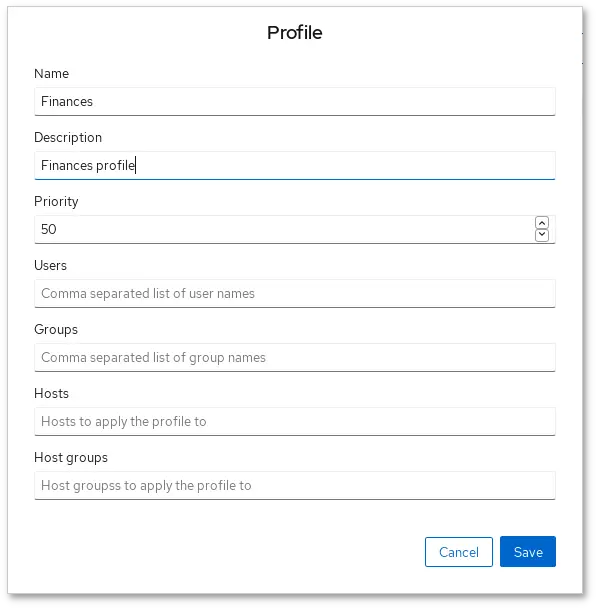

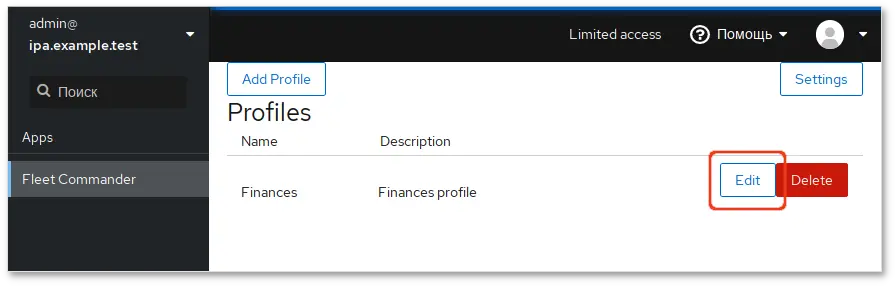

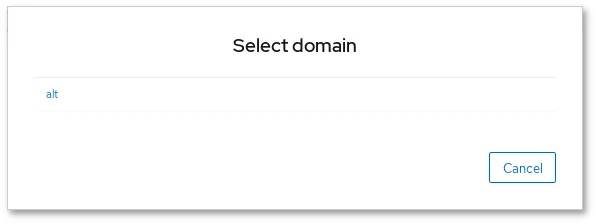

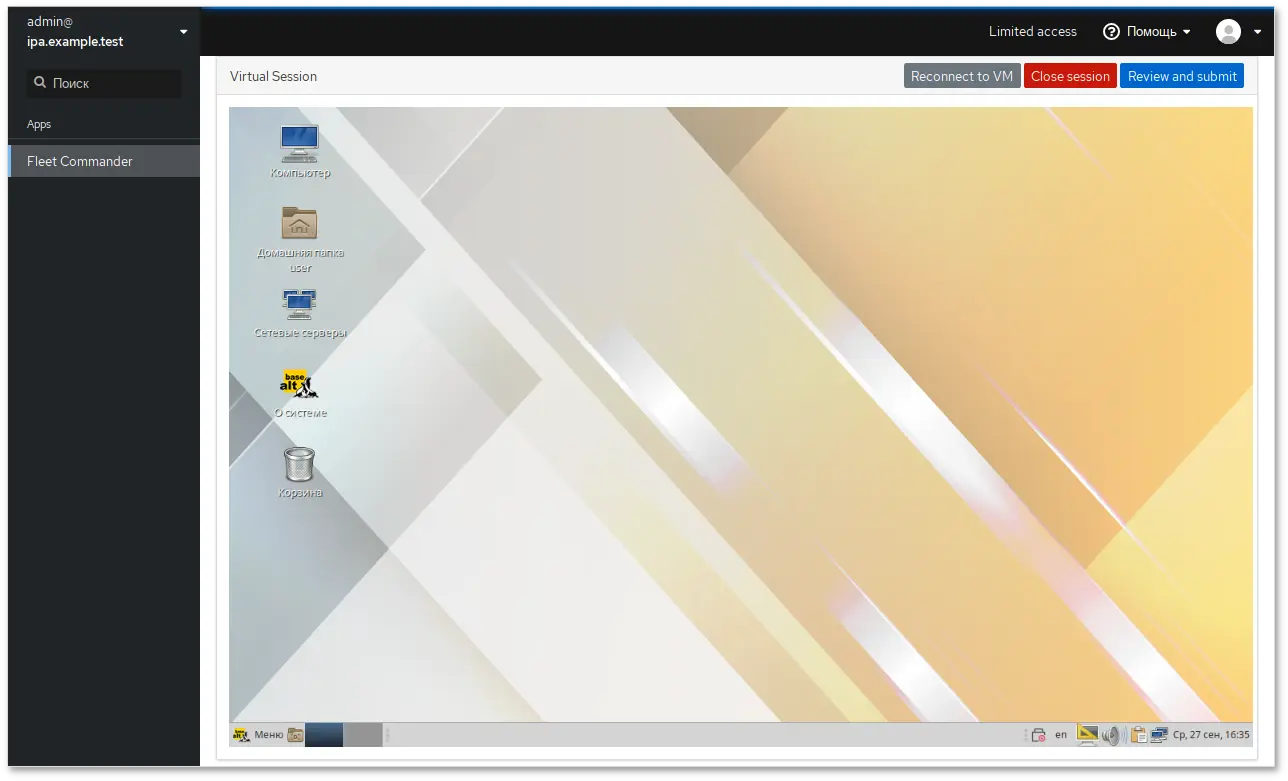

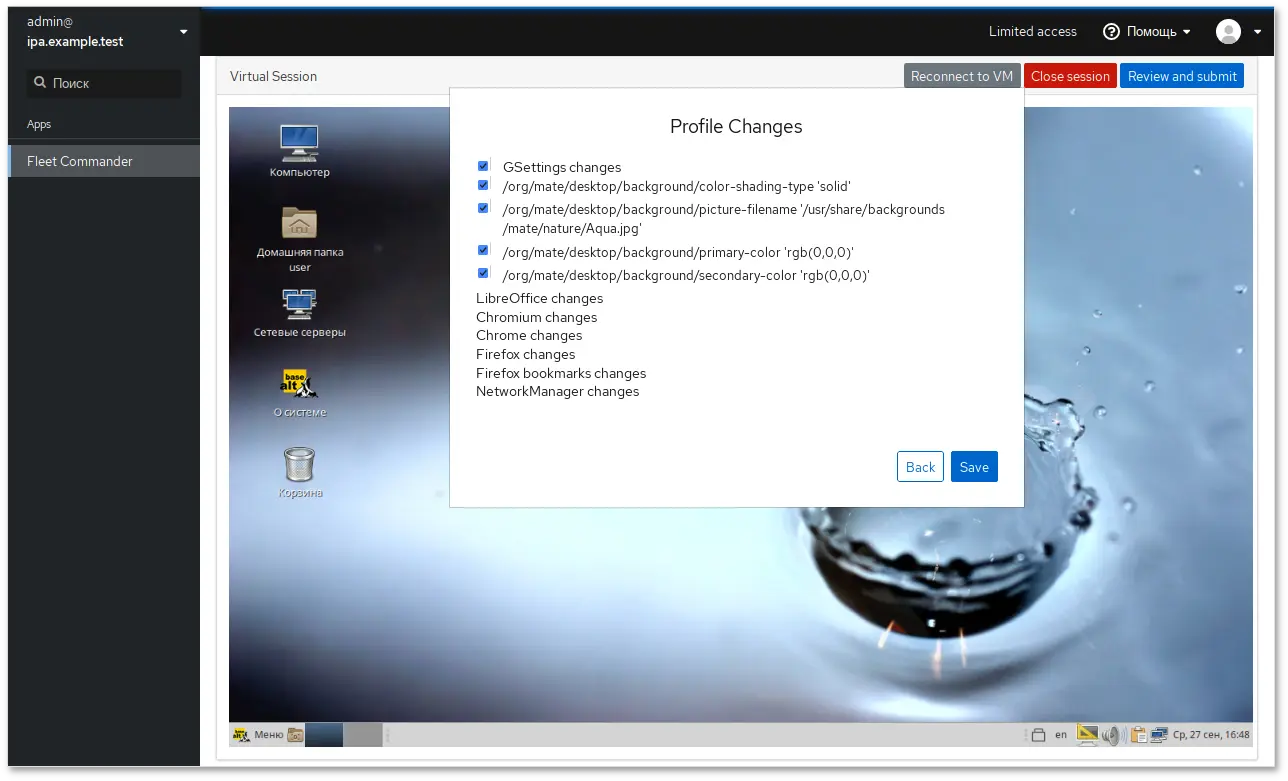

https://адрес-сервера:9090/fleet-commander-admin и запустить live-сессию ( → ). Появится окно со списком доступных ВМ, которые можно использовать в качестве шаблона для загрузки в live-сессии:

Предупреждение

log_level = debug в /etc/xdg/fleet-commander-admin.conf. Возникшие ошибки можно отследить, используя journalctl.

fping:

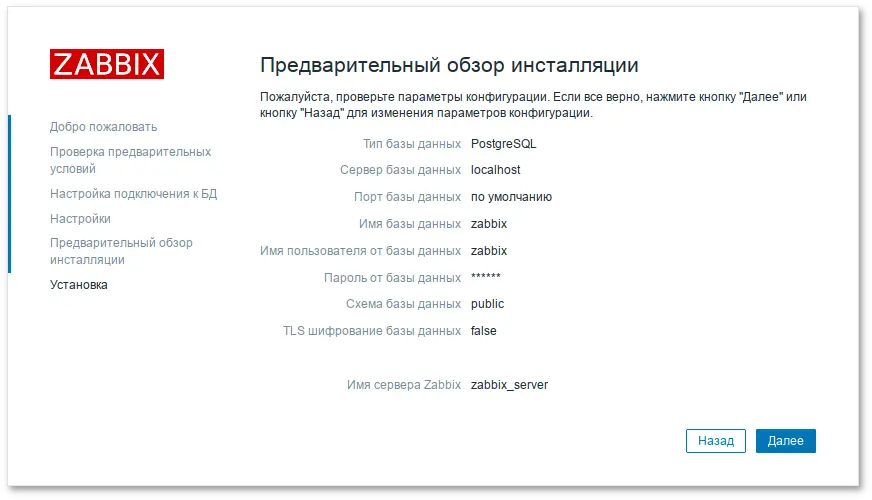

# apt-get install postgresql15-server zabbix-server-pgsql fping

# /etc/init.d/postgresql initdb

# systemctl enable --now postgresql

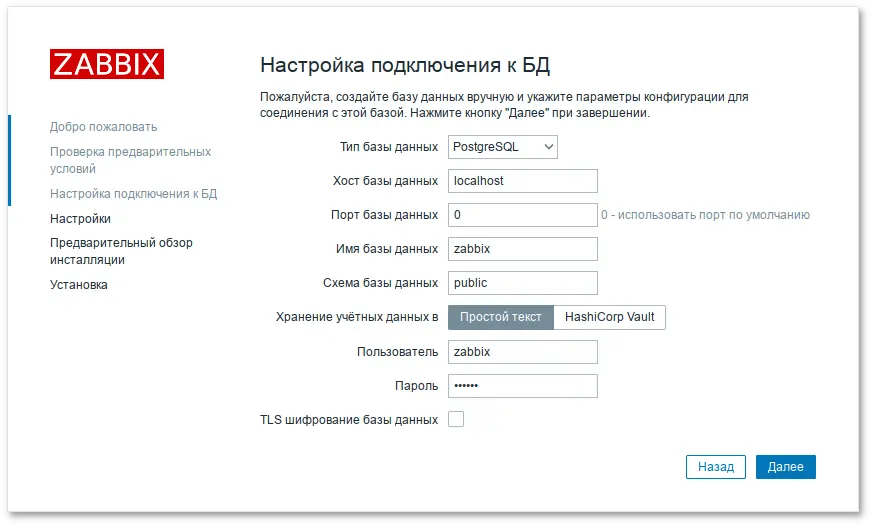

#su - postgres -s /bin/sh -c 'createuser --no-superuser --no-createdb --no-createrole --encrypted --pwprompt zabbix'#su - postgres -s /bin/sh -c 'createdb -O zabbix zabbix'#systemctl restart postgresql

#su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/schema.sql zabbix'#su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/images.sql zabbix'#su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/data.sql zabbix'

# apt-get install apache2 apache2-mod_php8.2

# systemctl enable --now httpd2

Примечание

php<мажорная>.<минорная версии>-<имя модуля>

# apt-get install php8.2 php8.2-mbstring php8.2-sockets php8.2-gd php8.2-xmlreader php8.2-pgsql php8.2-ldap php8.2-openssl

/etc/php/8.2/apache2-mod_php/php.ini:

memory_limit = 256M post_max_size = 32M max_execution_time = 600 max_input_time = 600 date.timezone = Europe/Moscow always_populate_raw_post_data = -1

# systemctl restart httpd2

/etc/zabbix/zabbix_server.conf:

DBHost=localhost DBName=zabbix DBUser=zabbix DBPassword=Пароль от базы

# systemctl enable --now zabbix_pgsql

# apt-get install zabbix-phpfrontend-apache2 zabbix-phpfrontend-php8.2

# ln -s /etc/httpd2/conf/addon.d/A.zabbix.conf /etc/httpd2/conf/extra-enabled/

# systemctl restart httpd2

# chown apache2:apache2 /var/www/webapps/zabbix/ui/conf

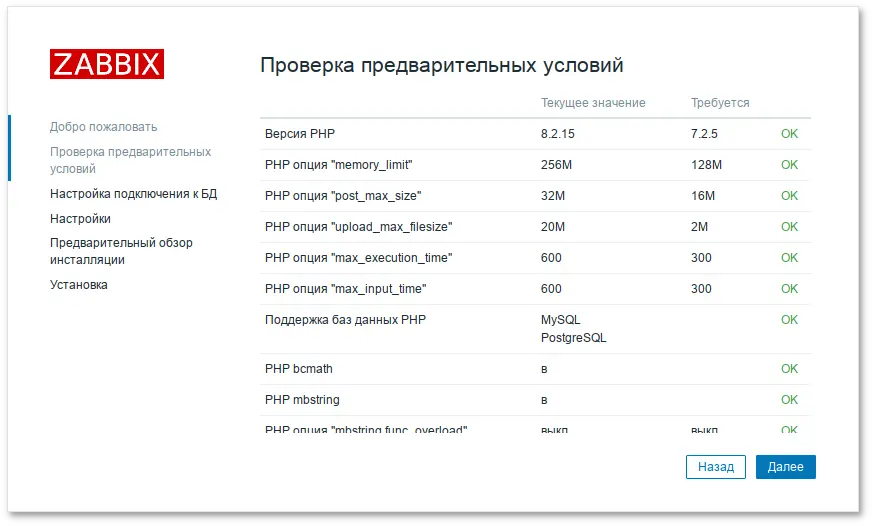

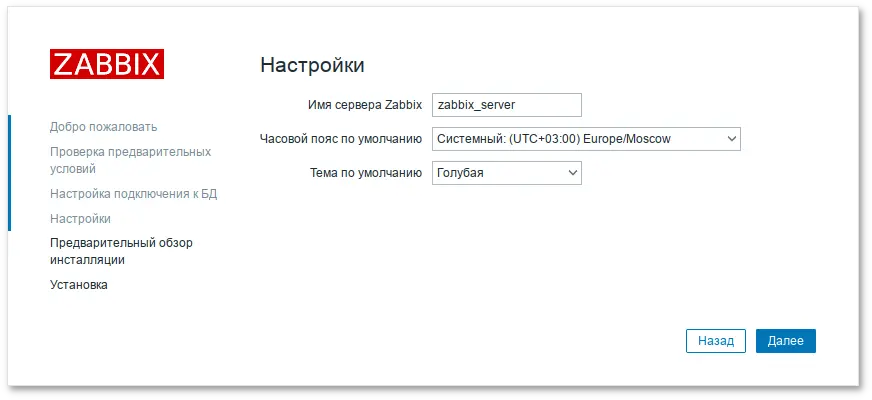

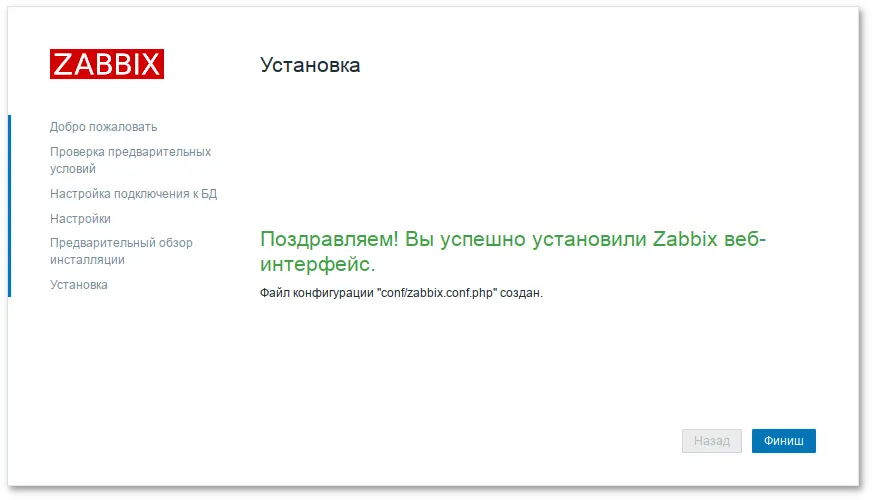

http://<ip-сервера>/zabbix

Примечание

/etc/httpd2/conf/sites-available/default.conf в секцию <Directory> добавить запись:

Require all grantedи перезапустить apache2:

# systemctl restart httpd2

Примечание

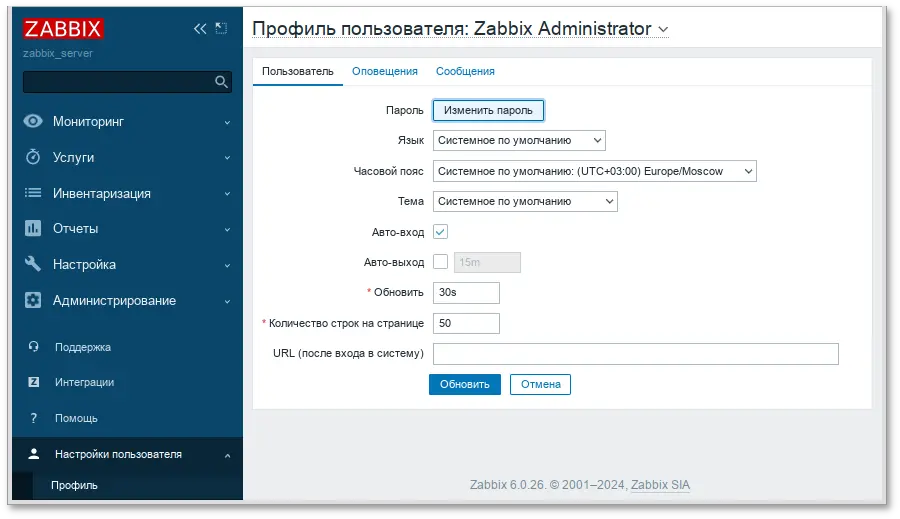

Логин: Admin Пароль: zabbix

Примечание

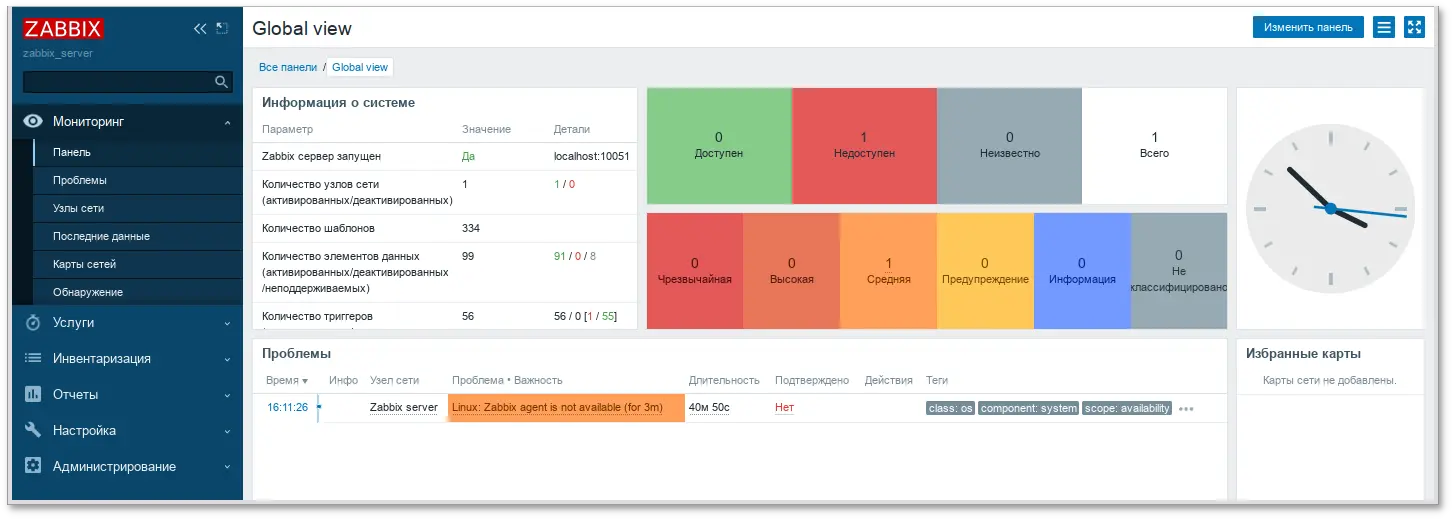

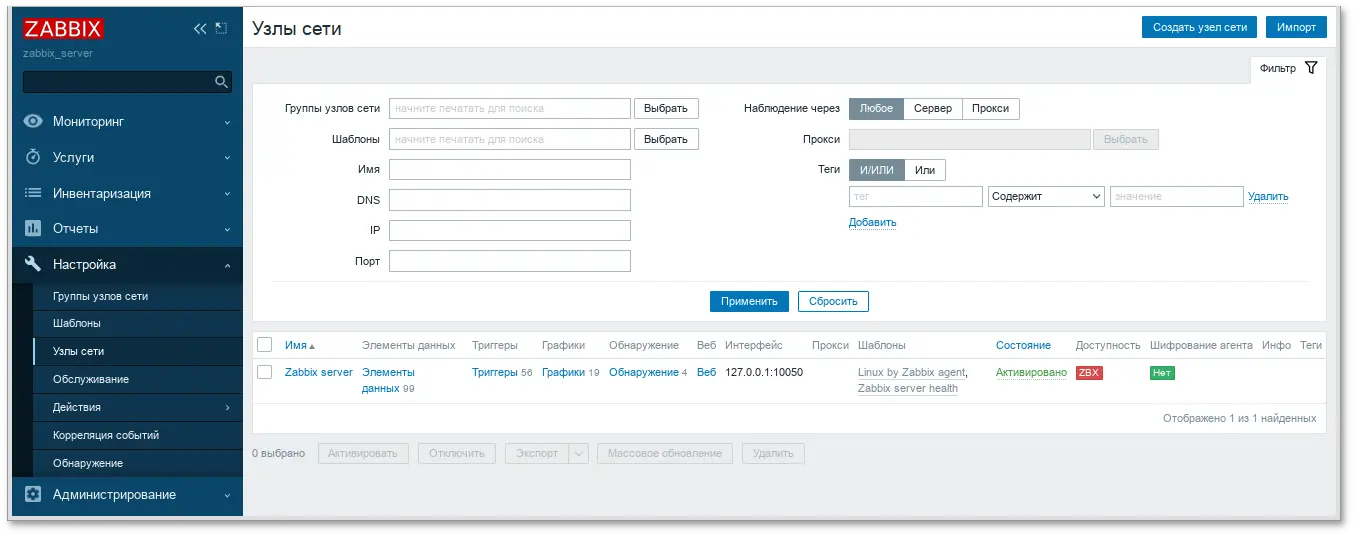

# apt-get install zabbix-agent

/etc/zabbix/zabbix_agentd.conf нужно задать следующие параметры:

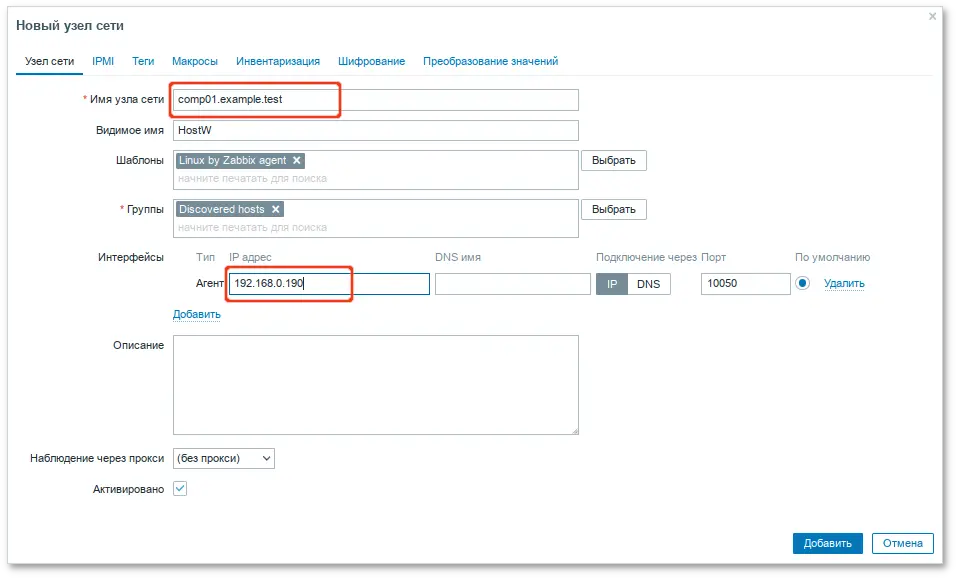

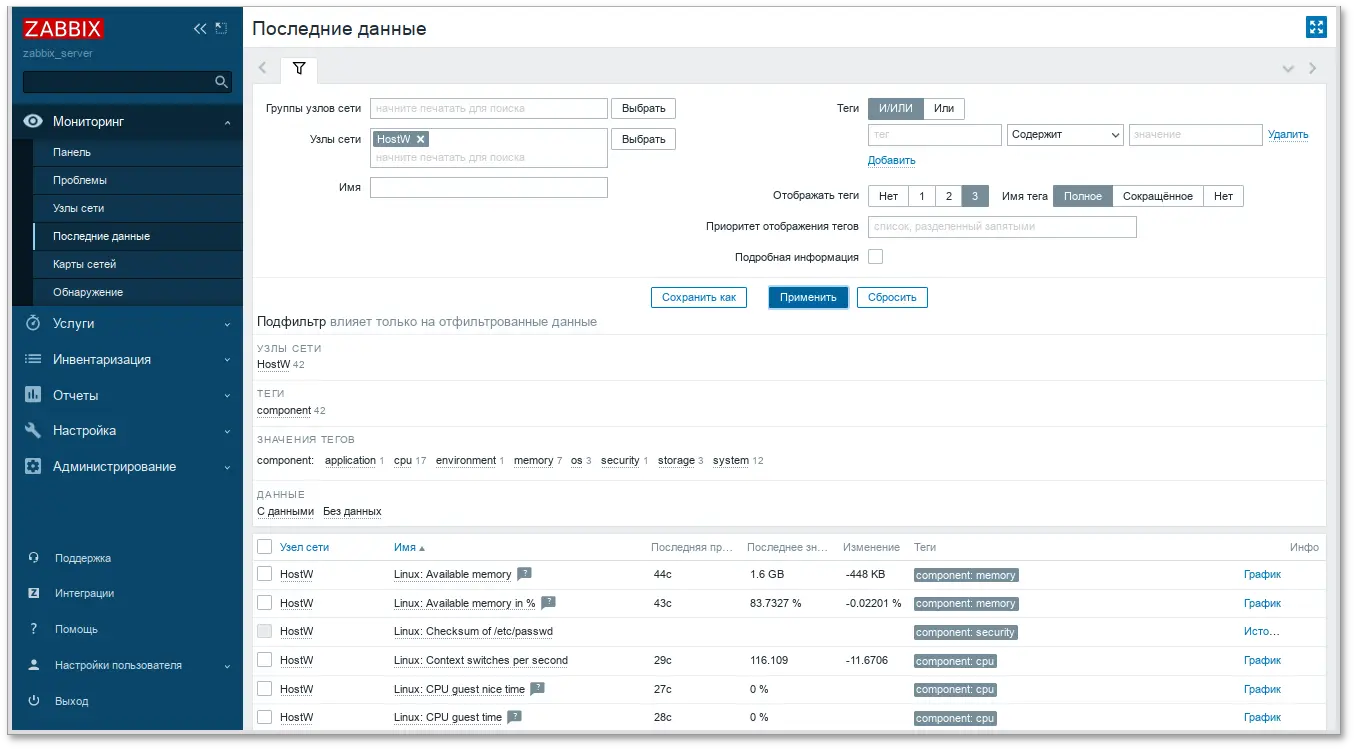

Server=<ip-сервера> ServerActive=<ip-сервера> Hostname=comp01.example.testcomp01.example.test — имя узла мониторинга, которое будет указано на сервере Zabbix.

Примечание

# systemctl enable --now zabbix_agentd.service

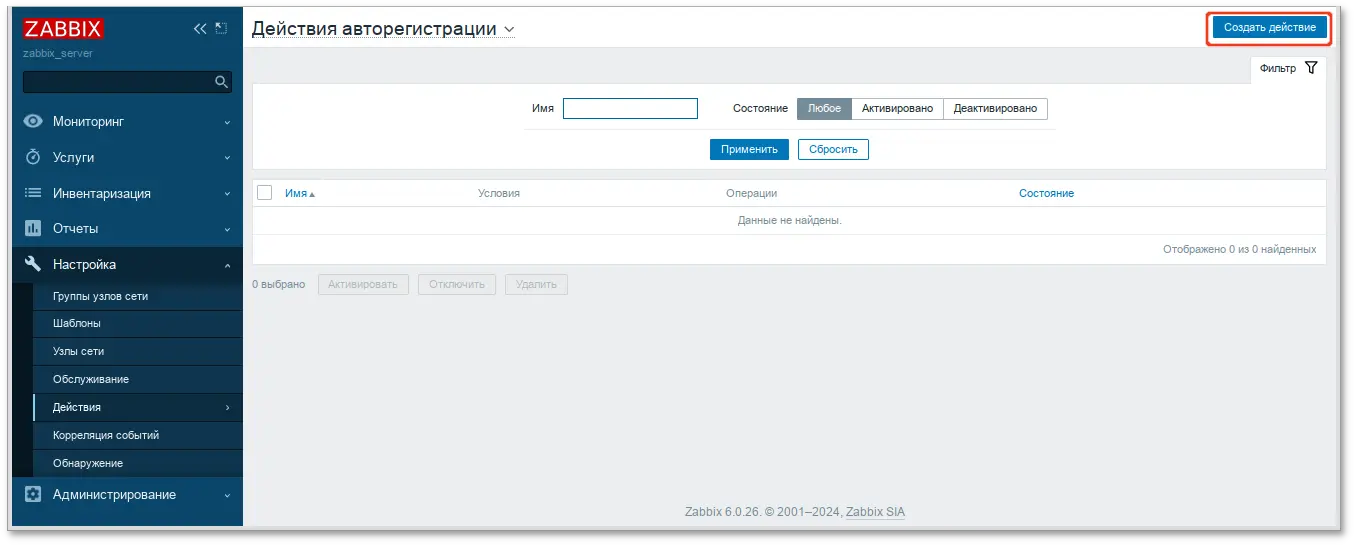

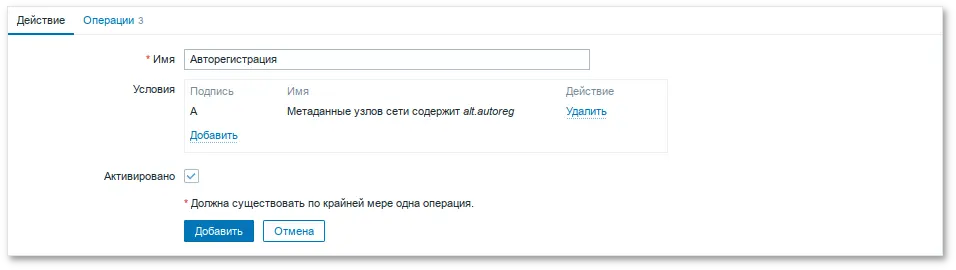

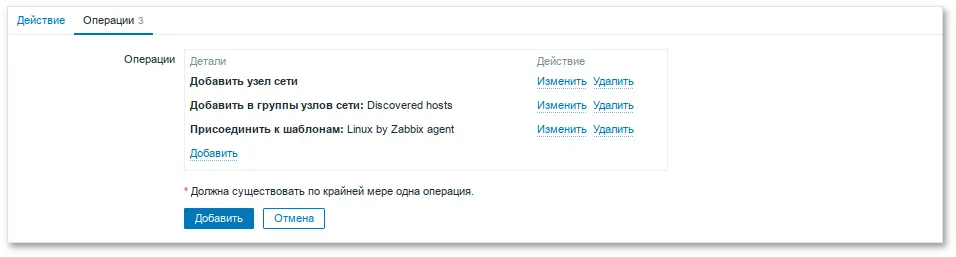

Примечание

Примечание

/etc/zabbix/zabbix_agentd.conf) в поле Hostname.

Примечание

Hostname — уникальное имя;

ServerActive — IP-адрес сервера;

HostMetadata — значение, которое было указано в настройках сервера (HostMetadata=alt.autoreg).

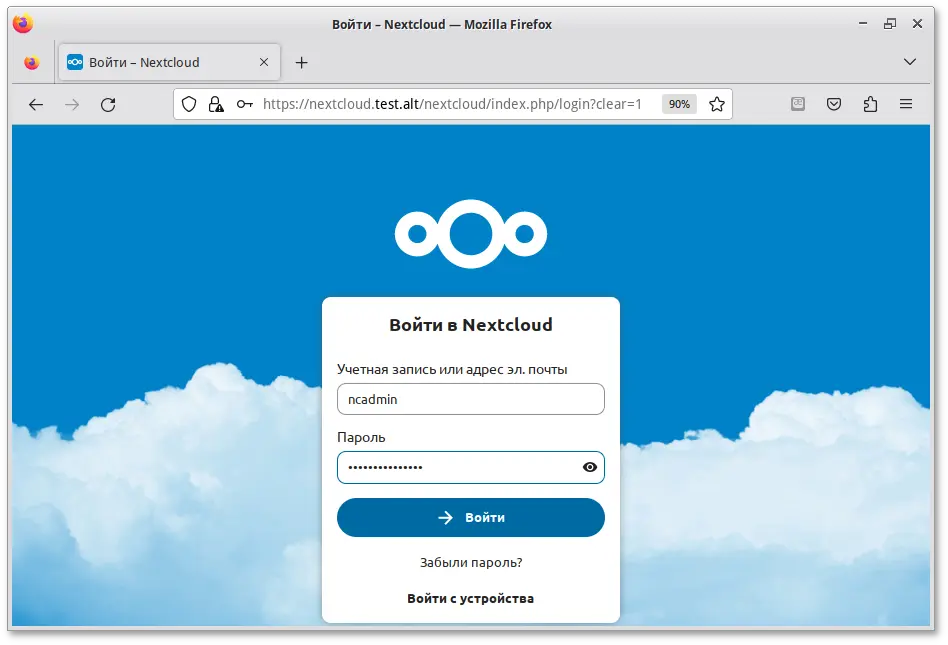

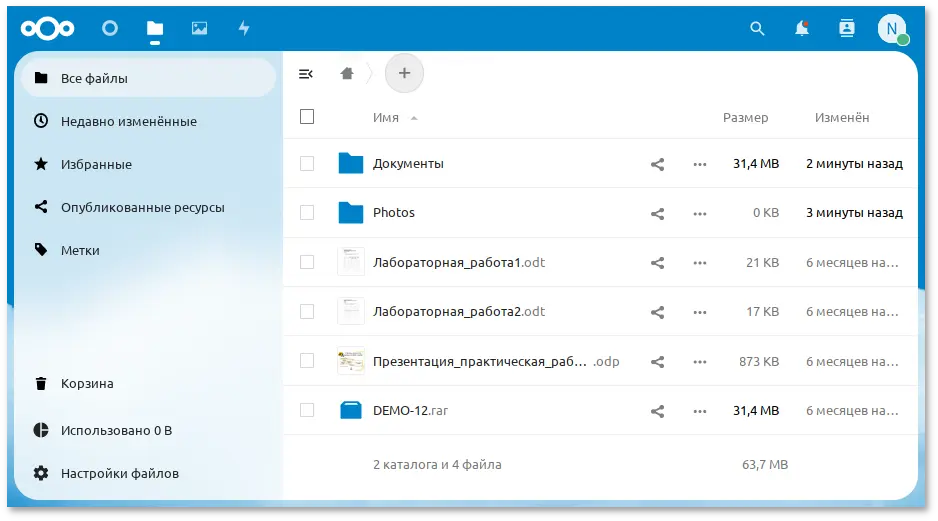

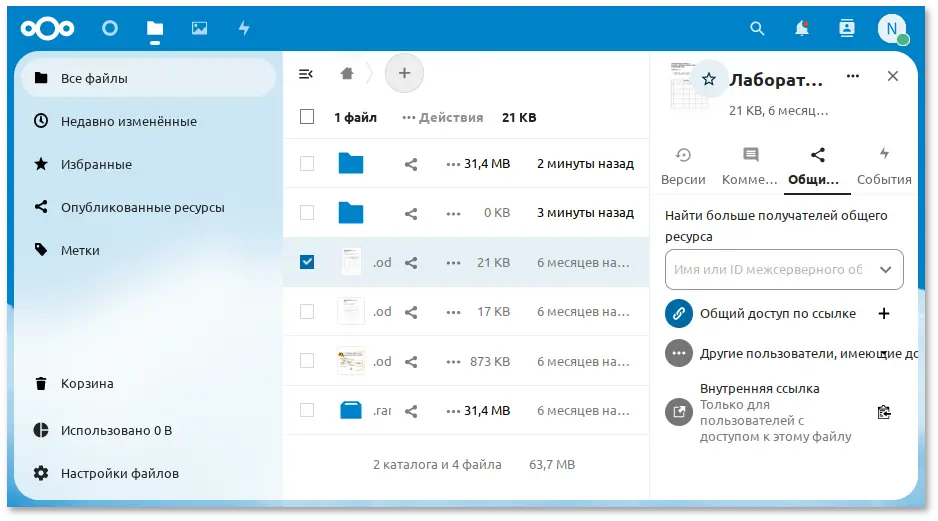

#apt-get install deploy#deploy nextcloud

Примечание

# deploy nextcloud

# deploy nextcloud password=5Z4SAq2U28rWyVz

https://<сервер>/nextcloud/. Где «сервер» — localhost или имя, заданное компьютеру при установке системы на этапе Настройка сети.

Примечание

$ hostname

Важно

/var/www/webapps/nextcloud/config/config.php в параметре version изменить старую версию на новую;

/var/www/webapps/nextcloud/config/config.php — файл конфигурации Nextcloud.

Важно

# systemctl restart httpd2

'memcache.local' => '\OC\Memcache\Memcached',

'memcache.distributed' => '\OC\Memcache\Memcached',

'memcached_servers' => array(

array('localhost', 11211),

),

Примечание

# apt-get install memcached php8.2-memcached

Служба memcached должна быть добавлена в автозагрузку:

# systemctl enable --now memcached

'trusted_domains' => array ( 0 => 'localhost', 1 => 'host-15', 2 => 'nextcloud.test.alt', ),

https://localhost/nextcloud/ или по имени сервера https://nextcloud.test.alt/nextcloud/.

Примечание

Примечание

Примечание

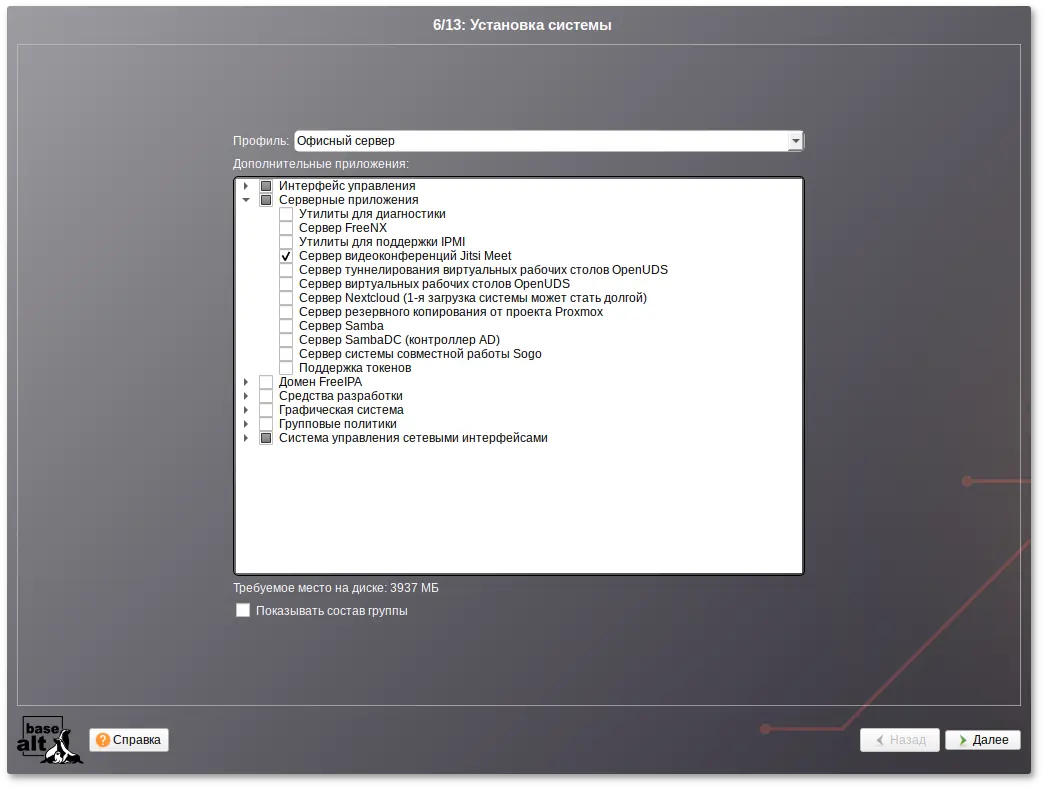

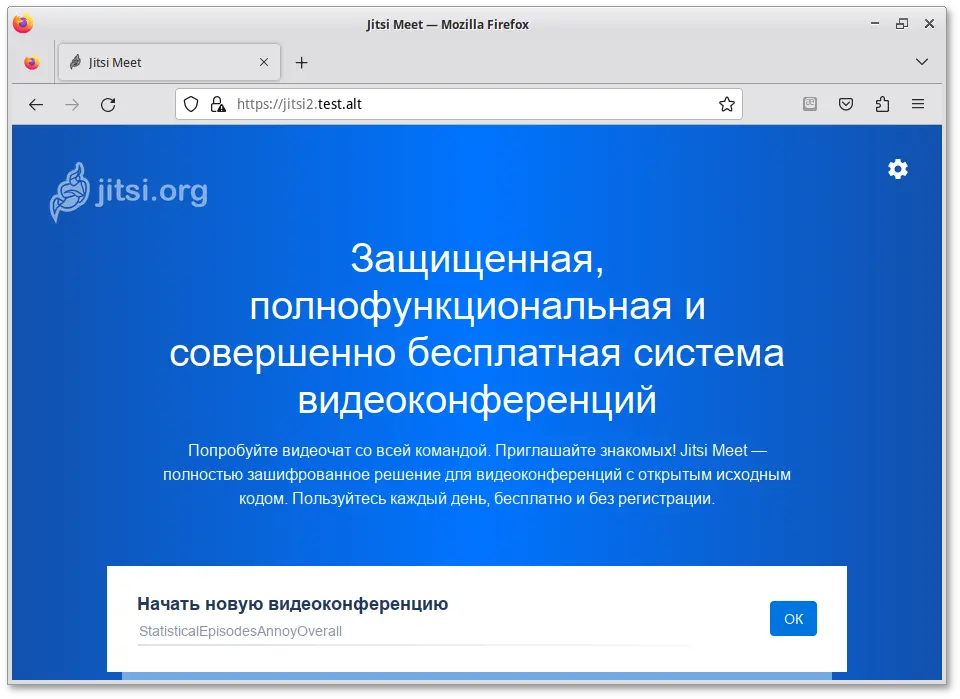

# apt-get install prosody jitsi-meet-prosody jitsi-meet-web jitsi-meet-web-config jicofo jitsi-videobridge

Примечание

Примечание

# hostnamectl set-hostname jitsi2

/etc/hosts строку:

127.0.0.1 jitsi2.test.alt jitsi2

Примечание

#hostnamejitsi2 #hostname -fjitsi2.test.alt $ping "$(hostname)"PING jitsi2.test.alt (127.0.0.1) 56(84) bytes of data. 64 bytes from localhost (127.0.0.1): icmp_seq=1 ttl=64 time=0.053 ms [...]

/etc/prosody/conf.d для хранения пользовательских конфигураций:

# mkdir -p /etc/prosody/conf.d

/etc/prosody/prosody.cfg.lua дописать строку:

Include "conf.d/*.cfg.lua"

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua) со следующим содержимым:

plugin_paths = { "/usr/share/jitsi-meet/prosody-plugins/" }

-- domain mapper options, must at least have domain base set to use the mapper

muc_mapper_domain_base = "jitsi2.test.alt";

cross_domain_bosh = false;

consider_bosh_secure = true;

----------- Virtual hosts -----------

VirtualHost "jitsi2.test.alt"

authentication = "anonymous"

ssl = {

key = "/var/lib/prosody/jitsi2.test.alt.key";

certificate = "/var/lib/prosody/jitsi2.test.alt.crt";

}

speakerstats_component = "speakerstats.jitsi2.test.alt"

conference_duration_component = "conferenceduration.jitsi2.test.alt"

-- we need bosh

modules_enabled = {

"bosh";

"pubsub";

"ping"; -- Enable mod_ping

"speakerstats";

"turncredentials";

"conference_duration";

}

c2s_require_encryption = false

Component "conference.jitsi2.test.alt" "muc"

storage = "memory"

modules_enabled = {

"muc_meeting_id";

"muc_domain_mapper";

-- "token_verification";

}

admins = { "focus@auth.jitsi2.test.alt" }

muc_room_locking = false

muc_room_default_public_jids = true

VirtualHost "auth.jitsi2.test.alt"

ssl = {

key = "/var/lib/prosody/auth.jitsi2.test.alt.key";

certificate = "/var/lib/prosody/auth.jitsi2.test.alt.crt";

}

authentication = "internal_plain"

-- internal muc component, meant to enable pools of jibri and jigasi clients

Component "internal.auth.jitsi2.test.alt" "muc"

storage = "memory"

modules_enabled = {

"ping";

}

admins = { "focus@auth.jitsi2.test.alt", "jvb@auth.jitsi2.test.alt" }

muc_room_locking = false

muc_room_default_public_jids = true

Component "focus.jitsi2.test.alt"

component_secret = "secret1" -- достаточно длинный пароль, он же JICOFO_SECRET

Component "speakerstats.jitsi2.test.alt" "speakerstats_component"

muc_component = "conference.jitsi2.test.alt"

Component "conferenceduration.jitsi2.test.alt" "conference_duration_component"

muc_component = "conference.jitsi2.test.alt"

#В ответах можно принять значения по умолчанию (можно просто нажать Enter) или ввести свои ответы. Важно в ответе на запрос commonName (jitsi2.test.alt): указать доменное имя сервера Prosody.prosodyctl cert generate jitsi2.test.altChoose key size (2048): countryName (GB): RU localityName (The Internet): organizationName (Your Organisation): organizationalUnitName (XMPP Department): commonName (jitsi2.test.alt): emailAddress (xmpp@jitsi2.test.alt): Config written to /var/lib/prosody/jitsi2.test.alt.cnf Certificate written to /var/lib/prosody/jitsi2.test.alt.crt #prosodyctl cert generate auth.jitsi2.test.altChoose key size (2048): countryName (GB): RU localityName (The Internet): organizationName (Your Organisation): organizationalUnitName (XMPP Department): commonName (auth.jitsi2.test.alt): emailAddress (xmpp@auth.jitsi2.test.alt): Config written to /var/lib/prosody/auth.jitsi2.test.alt.cnf Certificate written to /var/lib/prosody/auth.jitsi2.test.alt.crt

#ln -s /var/lib/prosody/jitsi2.test.alt.crt /etc/pki/ca-trust/source/anchors/#ln -s /var/lib/prosody/auth.jitsi2.test.alt.crt /etc/pki/ca-trust/source/anchors/#update-ca-trust

# prosodyctl register focus auth.jitsi2.test.alt secret2

где secret2 — достаточно длинный пароль.

# prosodyctl start

/etc/jitsi/jicofo/config следует указать:

# Jitsi Conference Focus settings

# sets the host name of the XMPP server

JICOFO_HOST=localhost

# sets the XMPP domain (default: none)

JICOFO_HOSTNAME=jitsi2.test.alt

# sets the secret used to authenticate as an XMPP component

JICOFO_SECRET=secret1

# overrides the prefix for the XMPP component domain. Default: "focus"

#JICOFO_FOCUS_SUBDOMAIN=focus

# sets the port to use for the XMPP component connection

JICOFO_PORT=5347

# sets the XMPP domain name to use for XMPP user logins

JICOFO_AUTH_DOMAIN=auth.jitsi2.test.alt

# sets the username to use for XMPP user logins

JICOFO_AUTH_USER=focus

# sets the password to use for XMPP user logins

JICOFO_AUTH_PASSWORD=secret2

# extra options to pass to the jicofo daemon

JICOFO_OPTS="${JICOFO_FOCUS_SUBDOMAIN:+ --subdomain=$JICOFO_FOCUS_SUBDOMAIN}"

# adds java system props that are passed to jicofo (default are for home and logging config file)

JAVA_SYS_PROPS="-Dnet.java.sip.communicator.SC_HOME_DIR_LOCATION=/etc/jitsi

-Dnet.java.sip.communicator.SC_HOME_DIR_NAME=jicofo

-Dnet.java.sip.communicator.SC_LOG_DIR_LOCATION=/var/log/jitsi

-Djava.util.logging.config.file=/etc/jitsi/jicofo/logging.properties"

Важно

JICOFO_SECRET=secret1должен быть указан пароль, установленный в файле

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua.

JICOFO_AUTH_PASSWORD=secret2должен быть указан пароль пользователя focus.

/etc/jitsi/jicofo/sip-communicator.properties следует указать:

org.jitsi.jicofo.health.ENABLE_HEALTH_CHECKS=true org.jitsi.jicofo.BRIDGE_MUC=JvbBrewery@internal.auth.jitsi2.test.alt

# systemctl start jicofo

# curl -i localhost:8888/about/health

HTTP/1.1 500 Internal Server Error

Date: Wed, 27 Sep 2023 09:32:05 GMT

Content-Type: application/json

Content-Length: 56

Server: Jetty(9.4.15.v20190215)

No operational bridges available (total bridge count: 0)

Так как пока ни одного Jitsi Videobridge к серверу не подключено, jicofo ответит кодом ответа 500 и сообщением No operational bridges available. Если в ответе сообщение об ошибке иного рода — следует проверить настройки и связь между prosody и jicofo.

# prosodyctl register jvb auth.jitsi2.test.alt secret3

/etc/jitsi/videobridge/config на следующее:

# Jitsi Videobridge settings # extra options to pass to the JVB daemon JVB_OPTS="--apis=," # adds java system props that are passed to jvb (default are for home and logging config file) JAVA_SYS_PROPS="-Dnet.java.sip.communicator.SC_HOME_DIR_LOCATION=/etc/jitsi -Dnet.java.sip.communicator.SC_HOME_DIR_NAME=videobridge -Dnet.java.sip.communicator.SC_LOG_DIR_LOCATION=/var/log/jitsi -Djava.util.logging.config.file=/etc/jitsi/videobridge/logging.properties -Dconfig.file=/etc/jitsi/videobridge/application.conf"

/etc/jitsi/videobridge/application.conf и /etc/jitsi/videobridge/sip-communicator.properties.

/etc/jitsi/videobridge/application.conf необходимо указать:

videobridge {

stats {

enabled = true

transports = [

{ type = "muc" }

]

}

apis {

xmpp-client {

configs {

shard {

hostname = "localhost"

domain = "auth.jitsi2.test.alt"

username = "jvb"

password = "secret3"

muc_jids = "JvbBrewery@internal.auth.jitsi2.test.alt"

# The muc_nickname must be unique across all instances

muc_nickname = "jvb-mid-123"

}

}

}

}

}

Важно

password = "secret3"должен быть указан пароль пользователя jvb.

/etc/jitsi/videobridge/sip-communicator.properties:

org.ice4j.ice.harvest.DISABLE_AWS_HARVESTER=true org.ice4j.ice.harvest.STUN_MAPPING_HARVESTER_ADDRESSES=meet-jit-si-turnrelay.jitsi.net:443 org.jitsi.videobridge.ENABLE_STATISTICS=true org.jitsi.videobridge.STATISTICS_TRANSPORT=muc org.jitsi.videobridge.xmpp.user.shard.HOSTNAME=localhost org.jitsi.videobridge.xmpp.user.shard.DOMAIN=auth.jitsi2.test.alt org.jitsi.videobridge.xmpp.user.shard.USERNAME=jvb org.jitsi.videobridge.xmpp.user.shard.PASSWORD=secret3 org.jitsi.videobridge.xmpp.user.shard.MUC_JIDS=JvbBrewery@internal.auth.jitsi2.test.alt org.jitsi.videobridge.xmpp.user.shard.MUC_NICKNAME=6d8b40cb-fe32-49f5-a5f6-13d2c3f95bba

Примечание

# systemctl start jitsi-videobridge

# curl -i localhost:8888/about/health

HTTP/1.1 200 OK

Date: Wed, 27 Sep 2023 09:39:28 GMT

Content-Length: 0

Server: Jetty(9.4.15.v20190215)

Если всё сделано правильно, jicofo на healthcheck-запрос будет отдавать HTTP-код 200.

Примечание

# openssl genrsa -out rootCA.key 2048

# openssl req -x509 -new -key rootCA.key -days 10000 -out rootCA.crt -subj "/C=RU/ST=Russia/L=Moscow/CN=SuperPlat CA Root"

# openssl genrsa -out jitsi2.test.alt.key 2048

# openssl req -new -key jitsi2.test.alt.key -out jitsi2.test.alt.csr -subj "/C=RU/L=Moscow/CN=jitsi2.test.alt"

# openssl x509 -req -in jitsi2.test.alt.csr -CA rootCA.crt -CAkey rootCA.key -CAcreateserial -out jitsi2.test.alt.crt -days 5000

Signature ok

subject=C = RU, CN = jitsi2.test.alt

Getting CA Private Key

/etc/jitsi/meet/:

#cp jitsi2.test.alt.crt /etc/jitsi/meet/#cp jitsi2.test.alt.key /etc/jitsi/meet/

/etc/jitsi/meet/jitsi2.test.alt-config.js на основе /usr/share/jitsi-meet-web-config/config.js:

# cp /usr/share/jitsi-meet-web-config/config.js /etc/jitsi/meet/jitsi2.test.alt-config.js

Внести изменения в файл /etc/jitsi/meet/jitsi2.test.alt-config.js в соответствии с настройками серверной части:

var config = {

// Connection

//

hosts: {

// XMPP domain.

domain: 'jitsi2.test.alt',

muc: 'conference.jitsi2.test.alt'

},

// BOSH URL. FIXME: use XEP-0156 to discover it.

bosh: '//jitsi2.test.alt/http-bind',

// Websocket URL

// websocket: 'wss://jitsi-meet.example.com/xmpp-websocket',

// The name of client node advertised in XEP-0115 'c' stanza

clientNode: 'http://jitsi.org/jitsimeet',

[...]

}

/usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache

/etc/httpd2/conf/sites-available/jitsi2.test.alt.conf на основе /usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache:

# cp /usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache /etc/httpd2/conf/sites-available/jitsi2.test.alt.conf

/etc/httpd2/conf/sites-available/jitsi2.test.alt.conf (изменить имя, указать сертификат):

<VirtualHost *:80>

ServerName jitsi2.test.alt

Redirect permanent / https://jitsi2.test.alt/

RewriteEngine On

RewriteCond %{HTTPS} off

RewriteRule ^ https://%{HTTP_HOST}%{REQUEST_URI} [R=301,L]

</VirtualHost>

<VirtualHost *:443>

ServerName jitsi2.test.alt

SSLProtocol TLSv1 TLSv1.1 TLSv1.2

SSLEngine on

SSLProxyEngine on

SSLCertificateFile /etc/jitsi/meet/jitsi2.test.alt.crt

SSLCertificateKeyFile /etc/jitsi/meet/jitsi2.test.alt.key

SSLCipherSuite "EECDH+ECDSA+AESGCM:EECDH+aRSA+AESGCM:EECDH+ECDSA+SHA256:EECDH+aRSA+SHA256:EECDH+ECDSA+SHA384:EECDH+ECDSA+SHA256:EECDH+aRSA+SHA384:EDH+aRSA+AESGCM:EDH+aRSA+SHA256:EDH+aRSA:EECDH:!aNULL:!eNULL:!MEDIUM:!LOW:!3DES:!MD5:!EXP:!PSK:!SRP:!DSS:!RC4:!SEED"

SSLHonorCipherOrder on

Header set Strict-Transport-Security "max-age=31536000"

DocumentRoot "/usr/share/jitsi-meet"

<Directory "/usr/share/jitsi-meet">

Options Indexes MultiViews Includes FollowSymLinks

AddOutputFilter Includes html

AllowOverride All

Order allow,deny

Allow from all

</Directory>

ErrorDocument 404 /static/404.html

Alias "/config.js" "/etc/jitsi/meet/jitsi2.test.alt-config.js"

<Location /config.js>

Require all granted

</Location>

Alias "/external_api.js" "/usr/share/jitsi-meet/libs/external_api.min.js"

<Location /external_api.js>

Require all granted

</Location>

ProxyPreserveHost on

ProxyPass /http-bind http://localhost:5280/http-bind/

ProxyPassReverse /http-bind http://localhost:5280/http-bind/

RewriteEngine on

RewriteRule ^/([a-zA-Z0-9]+)$ /index.html

</VirtualHost>

# apt-get install apache2-mod_ssl

#for mod in rewrite ssl headers proxy proxy_http; do a2enmod $mod; done#a2enport https#a2dissite 000-default#a2dissite 000-default_https

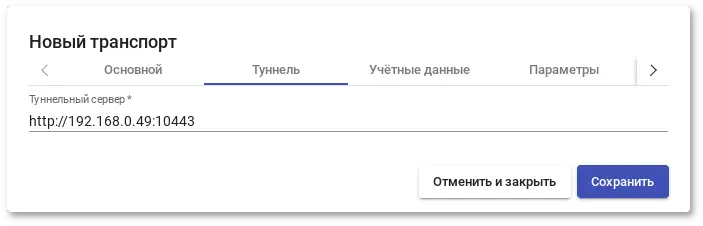

# a2ensite jitsi2.test.alt